Nvidia a annoncé une série de nouveaux produits lors de son événement dédié aux développeurs le 18 mars afin de consolider sa position sur le marché de l'intelligence artificielle (IA). Le cours de l'action du fabricant de puces a été multiplié par 54 et son chiffre d'affaires a plus que triplé depuis que ChatGPT a lancé la course mondiale à l'IA fin 2022. Les GPU serveur haut de gamme de Nvidia sont essentiels à l'entraînement et au déploiement de modèles de langage volumineux, des entreprises comme Microsoft et Meta investissant des milliards de dollars dans ces puces.

Nvidia baptise sa puce d'IA de nouvelle génération Blackwell. La première puce Blackwell, la GB200, sera disponible plus tard cette année. Nvidia propose à ses clients des puces plus puissantes pour stimuler les commandes. Les clients se bousculent encore pour se procurer la puce H100 Hopper.

« Hopper est génial, mais nous avons besoin de GPU plus gros », a déclaré Jensen Huang, PDG de Nvidia, lors de l'événement.

Parallèlement à la puce Blackwell, Nvidia a également lancé le logiciel NIM qui simplifie le déploiement de l'IA. Les responsables de Nvidia affirment que l'entreprise devient davantage un fournisseur de plateformes, à l'instar d'Apple et de Microsoft, qu'un simple fournisseur de puces.

« Blackwell n'est pas une puce, c'est le nom d'une plateforme », a déclaré Huang. Le vice-président de Nvidia, Manuvir Das, a promis que le logiciel NIM aiderait les développeurs à exécuter des programmes sur n'importe quel GPU Nvidia, ancien ou nouveau, afin de toucher un public plus large.

Blackwell, le « successeur » de Hopper

Tous les deux ans, Nvidia met à jour son architecture GPU, débloquant ainsi de nouveaux gains de performances. De nombreux modèles d'IA publiés l'année dernière ont été entraînés sur l'architecture Hopper, qui sera disponible à partir de 2022.

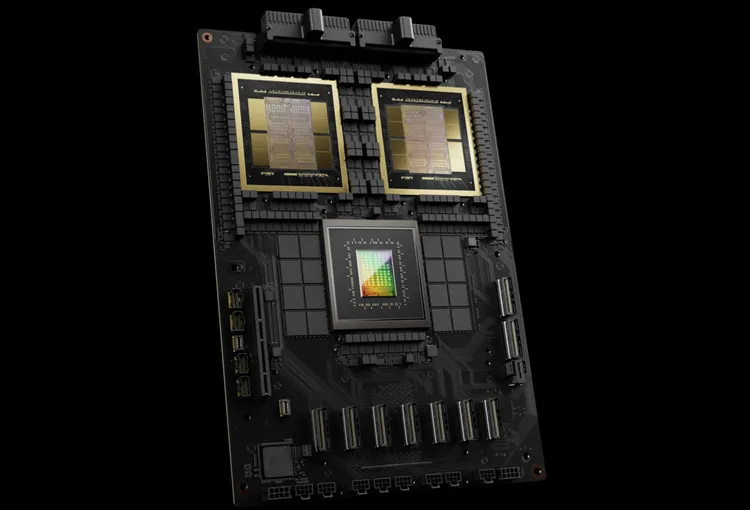

Nvidia affirme que les puces Blackwell comme la GB200 offrent un gain de performances significatif aux entreprises d'IA, avec 20 pétaflops contre 4 pétaflops pour la H100. Cette puissance de traitement permet aux entreprises d'IA d'entraîner des modèles plus grands et plus complexes.

Le GPU Blackwell est volumineux et combine deux matrices fabriquées séparément en une seule puce. Il est également disponible sous forme de serveur complet, le GB200 NVLink 2, qui combine 72 GPU Blackwell et d'autres composants Nvidia conçus pour entraîner des modèles d'IA.

Amazon, Google, Microsoft et Oracle commercialiseront l'accès au GB200 via des services cloud. Le GB200 combine deux GPU Blackwell B200 avec un processeur Grace. Nvidia a annoncé qu'Amazon Web Services (AWS) construirait un cluster de serveurs composé de 20 000 puces GB200.

Le système peut exécuter un modèle de 27 000 milliards de paramètres, bien plus grand que les plus grands modèles disponibles aujourd'hui, comme GPT-4 (1 700 milliards de paramètres). De nombreux chercheurs en IA estiment que des modèles plus grands, comportant davantage de paramètres et de données, pourraient ouvrir de nouvelles perspectives.

Nvidia n'a pas encore annoncé le prix du nouveau GB200 ni celui des systèmes qui l'intègrent. Le H100, basé sur la puce Hopper, coûte entre 25 000 et 40 000 dollars l'unité, et le système complet peut atteindre 200 000 dollars, selon les estimations des analystes.

(Selon CNBC)

Source

Comment (0)