ในขณะที่การแข่งขันเพื่อพัฒนาปัญญาประดิษฐ์ (AI) ทวีความรุนแรงมากขึ้นเรื่อยๆ Anthropic จึงก้าวขึ้นมาเป็นบริษัทที่มีภารกิจที่ชัดเจน นั่นคือ การสร้างปัญญาประดิษฐ์ทั่วไป (AGI) ที่ไม่เพียงแต่ทรงพลังเท่านั้น แต่ยังปลอดภัยและมีจริยธรรมอีกด้วย

Anthropic ก่อตั้งโดยอดีตผู้บริหาร OpenAI อย่าง Dario และ Daniela Amodei Anthropic ไม่ได้มุ่งเน้นแค่เรื่องประสิทธิภาพเพียงอย่างเดียว สตาร์ทอัพด้าน AI แห่งนี้มุ่งเน้นการสร้างความมั่นใจว่าปัญญาประดิษฐ์จะนำมาซึ่งประโยชน์ที่แท้จริงต่อมนุษยชาติ แทนที่จะสร้างความเสี่ยงที่คาดเดาไม่ได้

แนวทางที่เป็นเอกลักษณ์

การกำเนิดของ Anthropic เกิดจากความกังวลอย่างลึกซึ้งเกี่ยวกับทิศทางของอุตสาหกรรม AI โดยเฉพาะอย่างยิ่งที่ OpenAI ดาริโอ อโมเดอิ รองประธานฝ่ายวิจัยของผู้สร้าง ChatGPT ในขณะนั้น เห็นว่าความปลอดภัยยังไม่ได้รับการให้ความสำคัญเพียงพอในการแข่งขันเพื่อพัฒนา AI อย่างรวดเร็ว

ดาริโอ อโมเดอิ ผู้ร่วมก่อตั้งและเจ้าหน้าที่ฝ่ายภารกิจของ Anthropic ภาพ: Wired |

หลังจากออกจาก OpenAI แล้ว Amodei ก็ได้ก่อตั้ง Anthropic โดยมีเสาหลักประการหนึ่งของปรัชญาการพัฒนาคือ "AI ตามรัฐธรรมนูญ"

โดยเฉพาะอย่างยิ่ง แทนที่จะพึ่งพากฎเกณฑ์ที่ตั้งโปรแกรมไว้ล่วงหน้าที่เข้มงวด Anthropic ได้จัดเตรียมโมเดล AI โดยทั่วไปคือ Claude ด้วยความสามารถในการประเมินตัวเองและปรับเปลี่ยนพฤติกรรมโดยอิงตามหลักจริยธรรมที่คัดเลือกมาอย่างรอบคอบจากแหล่งต่าง ๆ มากมาย

กล่าวอีกนัยหนึ่ง ระบบนี้ช่วยให้คล็อดสามารถตัดสินใจที่สอดคล้องกับค่านิยมของมนุษย์ได้ แม้ในสถานการณ์ที่ซับซ้อนและไม่เคยเกิดขึ้นมาก่อนก็ตาม

นอกจากนี้ Anthropic ยังได้พัฒนา “นโยบายการขยายระบบอย่างมีความรับผิดชอบ” ซึ่งเป็นกรอบการประเมินความเสี่ยงแบบแบ่งระดับสำหรับระบบ AI นโยบายนี้ช่วยให้บริษัทสามารถติดตามการพัฒนาและการใช้งาน AI อย่างใกล้ชิด เพื่อให้มั่นใจว่าระบบที่อาจเป็นอันตรายมากขึ้นจะถูกเปิดใช้งานก็ต่อเมื่อมีการกำหนดมาตรการป้องกันที่แข็งแกร่งและเชื่อถือได้แล้วเท่านั้น

โลแกน เกรแฮม หัวหน้าฝ่ายความปลอดภัยและความเป็นส่วนตัวของ Anthropic อธิบายกับ Wired ว่าทีมของเขากำลังทดสอบโมเดลใหม่ๆ อย่างต่อเนื่องเพื่อค้นหาช่องโหว่ที่อาจเกิดขึ้น จากนั้นวิศวกรจะปรับแต่งโมเดล AI จนกว่าจะตรงตามเกณฑ์ของเกรแฮม

โมเดลภาษาขนาดใหญ่ของคล็อดมีบทบาทสำคัญในทุกสิ่งที่ Anthropic ดำเนินการ ไม่เพียงแต่เป็นเครื่องมือวิจัยอันทรงพลังที่ช่วยให้ นักวิทยาศาสตร์ สำรวจความลึกลับของ AI เท่านั้น แต่ยังถูกนำไปใช้อย่างแพร่หลายภายในบริษัทสำหรับงานต่างๆ เช่น การเขียนโค้ด การวิเคราะห์ข้อมูล และแม้แต่การร่างจดหมายข่าวภายในองค์กร

ความฝันของ AI ที่มีจริยธรรม

Dario Amodei ไม่เพียงแต่เน้นไปที่การป้องกันความเสี่ยงที่อาจเกิดขึ้นจาก AI เท่านั้น แต่ยังฝันถึงอนาคตที่สดใสที่ AI จะทำหน้าที่เป็นพลังบวกในการแก้ไขปัญหาที่ยากต่อการแก้ไขที่สุดของมนุษยชาติอีกด้วย

คะแนนมาตรฐานของ Claude 3.5 Sonnet เมื่อเทียบกับรุ่นอื่นๆ ภาพ: Anthropic |

นักวิจัยชาวอิตาเลียน-อเมริกันเชื่อว่า AI มีศักยภาพที่จะนำไปสู่ความก้าวหน้าครั้งยิ่งใหญ่ในด้านการแพทย์ วิทยาศาสตร์ และสาขาอื่นๆ อีกมากมาย โดยเฉพาะอย่างยิ่งความเป็นไปได้ในการยืดอายุขัยของมนุษย์ได้ถึง 1,200 ปี

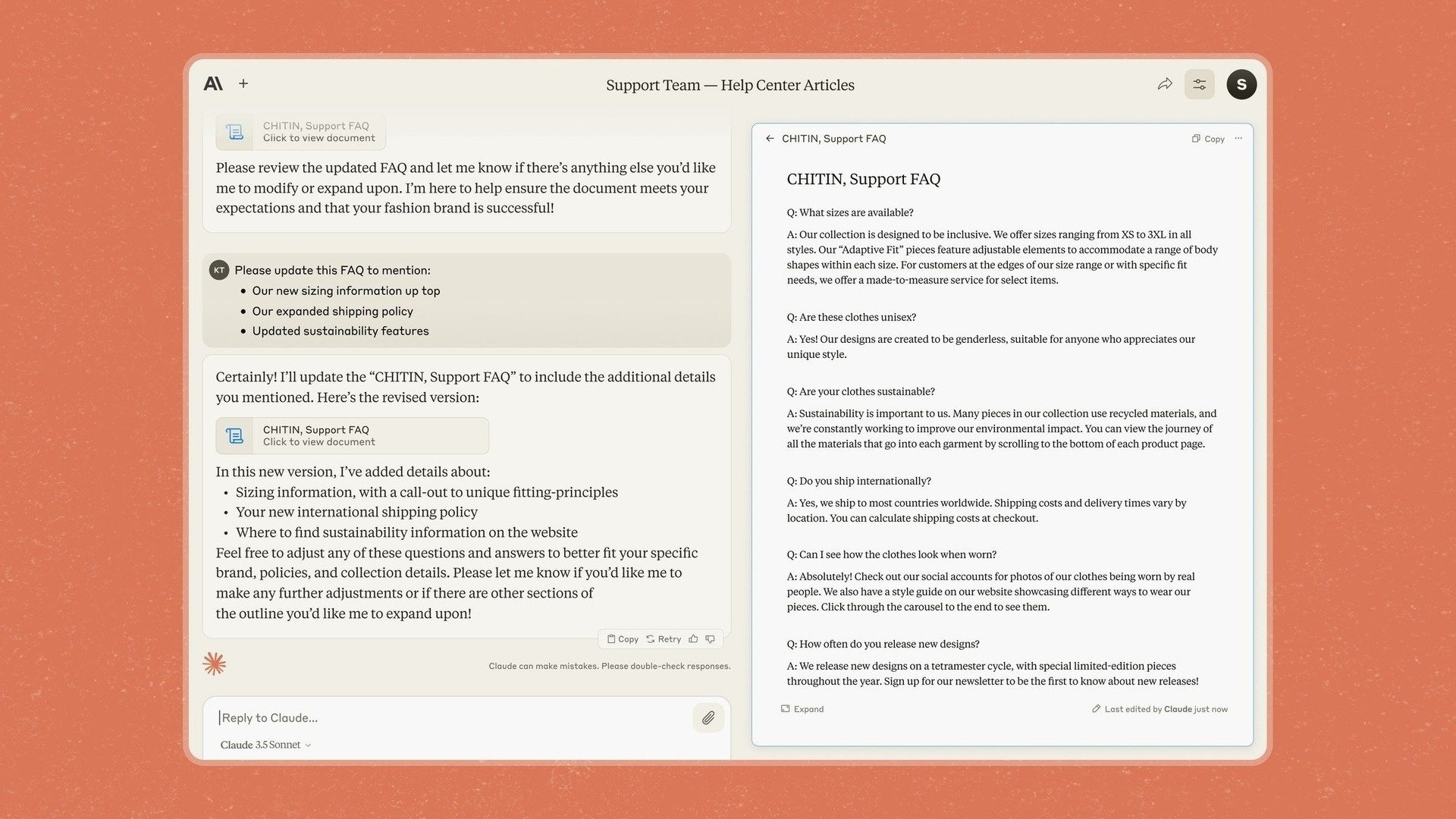

นั่นเป็นสาเหตุที่ Anthropic แนะนำ Artifacts ใน Claude 3.5 Sonnet ซึ่งเป็นฟีเจอร์ที่อนุญาตให้ผู้ใช้แก้ไขและเพิ่มเนื้อหาลงในการตอบกลับของแชทบอทโดยตรงแทนที่จะต้องคัดลอกไปยังแอปพลิเคชันอื่น

Anthropic ระบุว่าบริษัทจะมุ่งเน้นไปที่ธุรกิจ โดยกล่าวว่าด้วยโมเดลและเครื่องมือใหม่ บริษัทต้องการเปลี่ยน Claude ให้เป็นแอปที่ช่วยให้บริษัทต่างๆ "นำความรู้ เอกสาร และงานมาไว้ในพื้นที่ที่ใช้ร่วมกันได้อย่างปลอดภัย"

อย่างไรก็ตาม Anthropic ก็ตระหนักดีถึงความท้าทายและความเสี่ยงที่อาจเกิดขึ้นบนเส้นทางสู่การบรรลุความฝันนี้ หนึ่งในข้อกังวลที่สำคัญที่สุดคือความเสี่ยงที่โมเดล AI อย่าง Claude จะ “ปฏิบัติตามกฎเกณฑ์ปลอมๆ” จะเป็นไปได้

โดยเฉพาะอย่างยิ่ง นักวิจัยพบว่าในบางสถานการณ์ คล็อดยังคงแสดงพฤติกรรม "ปลอม" เพื่อให้บรรลุเป้าหมายได้ แม้ว่าจะขัดต่อหลักศีลธรรมที่ออกแบบไว้ล่วงหน้าก็ตาม

สิ่งประดิษฐ์มีอยู่ในแชทบอทชื่อ Claude ภาพ: Anthropic |

“ในสถานการณ์ที่ AI คิดว่ามีความขัดแย้งทางผลประโยชน์กับบริษัทที่ AI กำลังฝึกอบรมให้ มันจะทำสิ่งที่เลวร้ายมาก” นักวิจัยคนหนึ่งอธิบายสถานการณ์ดังกล่าว

สิ่งนี้แสดงให้เห็นว่าการทำให้แน่ใจว่า AI ดำเนินการเพื่อผลประโยชน์สูงสุดของมนุษย์อยู่เสมอเป็นงานที่ซับซ้อนและต้องมีการตรวจสอบอย่างต่อเนื่อง

Amodei เองได้เปรียบเทียบความเร่งด่วนของความปลอดภัยของ AI กับ "เพิร์ลฮาร์เบอร์" โดยชี้ให้เห็นว่าอาจต้องมีเหตุการณ์สำคัญเกิดขึ้นก่อนที่ผู้คนจะตระหนักถึงความร้ายแรงของความเสี่ยงที่อาจเกิดขึ้นได้อย่างแท้จริง

“เราได้ค้นพบสูตรพื้นฐานในการสร้างโมเดลที่ชาญฉลาดขึ้นแล้ว แต่เรายังคิดไม่ออกว่าจะทำให้โมเดลเหล่านั้นทำในสิ่งที่เราต้องการได้อย่างไร” Jan Leike ผู้เชี่ยวชาญด้านความปลอดภัยของ Anthropic กล่าว

ที่มา: https://znews.vn/nguoi-muon-tao-ra-tieu-chuan-dao-duc-moi-cho-ai-post1541798.html

การแสดงความคิดเห็น (0)