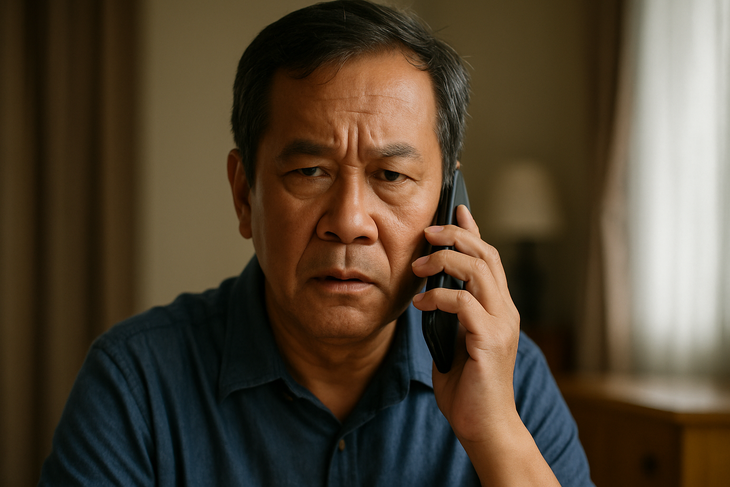

Arnaque en usurpant l'identité vocale avec une voix deepfake

À l'ère du développement rapide de l'intelligence artificielle, la voix, autrefois considérée comme une preuve authentique, est devenue un outil dangereux aux mains des malfaiteurs. La technologie du deepfake vocal permet de simuler des voix réelles, créant ainsi de faux appels sophistiqués pour frauder et s'approprier des biens.

Pourquoi les voix deepfake sont-elles effrayantes ?

La voix Deepfake est une technologie qui applique l'intelligence artificielle (IA) et l'apprentissage automatique pour créer une fausse voix identique à la voix d'une vraie personne.

Avec le support de modèles modernes tels que Tacotron, WaveNet, ElevenLabs ou de plateformes de clonage vocal comme Respeecher, les fraudeurs n'ont besoin que de 3 à 10 secondes d'échantillons vocaux pour créer un deepfake fiable à 95 %.

Les voix deepfake deviennent particulièrement dangereuses en raison de leur capacité à imiter les voix presque parfaitement, de la prononciation à l'intonation, jusqu'aux habitudes de parole uniques de chaque personne.

Il est donc très difficile pour les victimes de faire la distinction entre le vrai et le faux, surtout lorsque la voix appartient à leurs proches, amis ou supérieurs.

L'exploitation de voix est également facile, car la plupart des gens exposent aujourd'hui leurs enregistrements audio via des plateformes comme TikTok, des diffusions en direct sur les réseaux sociaux, des podcasts ou des réunions en ligne. Plus inquiétant encore, les voix deepfake ne laissent pas de trace visuelle comme les images ou les vidéos , ce qui complique les enquêtes et expose les victimes à des pertes financières.

Quelques secondes d'échantillon de voix suffisent pour créer un deepfake

Les escroqueries vocales deepfake deviennent de plus en plus sophistiquées, utilisant souvent un scénario familier : se faire passer pour une connaissance dans une situation d'urgence pour créer la panique et faire pression sur la victime pour qu'elle transfère de l'argent immédiatement.

Au Vietnam, une mère a reçu un appel de son « fils » l'informant qu'il avait eu un accident et avait un besoin urgent d'argent. Au Royaume-Uni, un dirigeant d'entreprise s'est fait escroquer de plus de 240 000 dollars après avoir entendu son « patron » lui demander un virement par téléphone. Un employé administratif a également été victime d'une arnaque après avoir reçu un appel d'un « grand patron » demandant un paiement à un « partenaire stratégique »…

Le point commun dans ces situations est que la fausse voix est reproduite exactement comme celle d'un parent ou d'un supérieur, ce qui fait que la victime lui fait absolument confiance et n'a pas le temps de vérifier.

Vérifiez toujours, ne faites pas confiance immédiatement

Face à la multiplication des arnaques vocales « deepfake », il est conseillé de ne pas transférer d'argent par téléphone uniquement en se basant sur la voix, même si elle ressemble exactement à celle d'un proche. Il est préférable de rappeler l'ancien numéro ou de vérifier les informations sur plusieurs canaux avant toute transaction.

De nombreux experts recommandent également de mettre en place un « mot de passe interne » au sein du domicile ou de l’entreprise pour vérification dans des situations inhabituelles.

Par ailleurs, il est nécessaire de limiter la publication de vidéos avec des voix claires sur les réseaux sociaux, en particulier les contenus longs. Il est notamment nécessaire d'avertir et d'orienter proactivement les groupes vulnérables, tels que les personnes âgées ou peu familiarisées avec les nouvelles technologies, car ils constituent des cibles privilégiées des arnaques high-tech.

Les voix des proches, des amis et des collègues peuvent toutes être falsifiées.

Dans de nombreux pays, les autorités ont commencé à renforcer le contrôle sur la technologie deepfake avec leur propre cadre juridique.

Aux États-Unis, plusieurs États ont interdit l'utilisation de deepfakes dans les campagnes électorales ou pour diffuser de fausses informations. L'Union européenne (UE) a adopté la loi sur l'IA, qui oblige les organisations à faire preuve de transparence et à avertir clairement si un contenu est généré par l'intelligence artificielle.

Pendant ce temps, au Vietnam, bien qu'il n'existe pas de réglementation spécifique pour les voix deepfake, les actes connexes peuvent être traités conformément à la loi en vigueur, avec des crimes tels que la fraude, l'atteinte à la vie privée ou la fraude à l'identité.

Cependant, la réalité est que la technologie se développe à un rythme bien supérieur à la capacité de surveillance de la loi, laissant de nombreuses failles que les acteurs malveillants peuvent exploiter.

Quand la voix n'est plus une preuve

La voix était autrefois un élément intime et fiable, mais avec les deepfakes, elle ne constitue plus une preuve fiable. À l'ère de l'IA, chaque individu doit maîtriser les techniques de défense numérique, effectuer des vérifications proactives et rester vigilant en permanence, car un appel peut se révéler un piège.

Source : https://tuoitre.vn/lua-dao-bang-deepfake-voice-ngay-cang-tinh-vi-phai-lam-sao-20250709105303634.htm

![[Infographie] En 2025, 47 produits obtiendront l'OCOP national](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/5d672398b0744db3ab920e05db8e5b7d)

Comment (0)