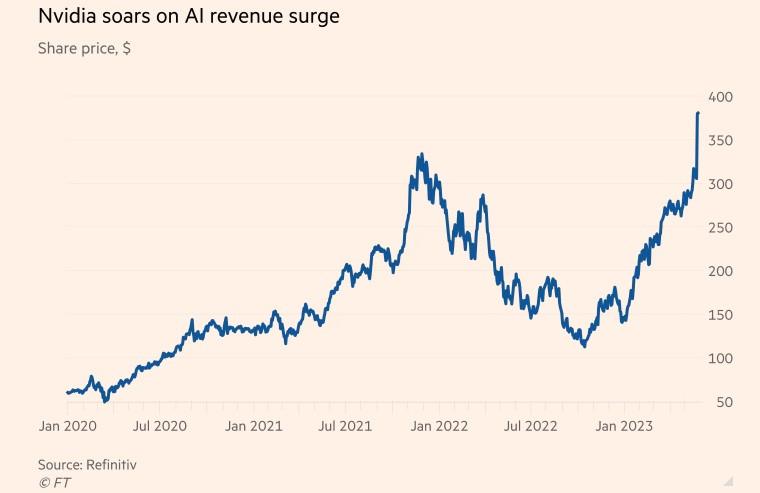

Nvidia alguna vez fue conocida como fabricante de chips utilizados en videojuegos, pero en los últimos años ha desplazado su atención hacia el mercado de centros de datos.

La empresa estadounidense de chips ha prosperado durante la pandemia, gracias al aumento de la demanda de juegos y aplicaciones en la nube y a la expansión global de la minería de criptomonedas. Al cierre del ejercicio fiscal, que concluyó el 29 de enero, su negocio de chips para centros de datos representaba más del 50 % de los ingresos de la compañía.

Mientras tanto, el popular chatbot ChatGPT llevó la inteligencia artificial (IA) generativa al siguiente nivel este año, utilizando grandes cantidades de datos existentes para generar nuevo contenido sobre temas que van desde la poesía hasta la programación informática.

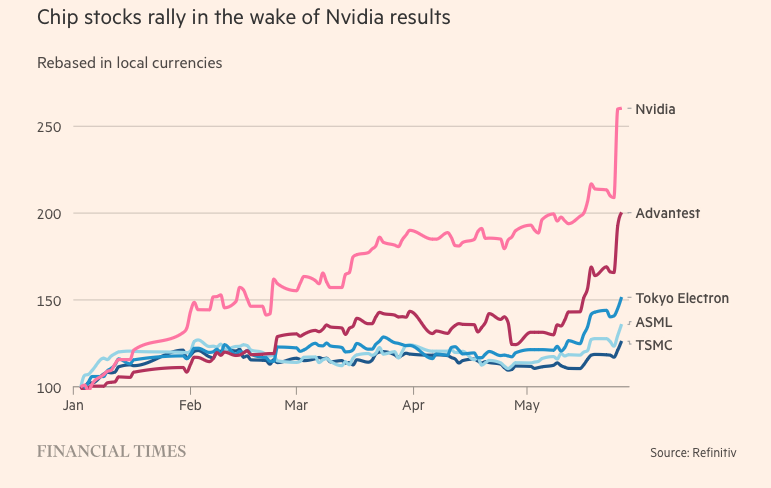

Microsoft y Alphabet, dos gigantes tecnológicos que también son importantes actores en el sector de la IA, creen que la tecnología generativa puede transformar la forma de trabajar de las personas. Ambos han emprendido una carrera para integrar la IA en los motores de búsqueda y el software ofimático, con la ambición de dominar este sector.

Goldman Sachs estima que la inversión estadounidense en IA podría alcanzar cerca del 1% de la producción económica del país en 2030.

Las supercomputadoras que procesan datos y ejecutan IA generativa dependen de unidades de procesamiento gráfico (GPU). Las GPU están diseñadas para gestionar los cálculos específicos de la computación de IA y son mucho más eficientes que las unidades centrales de procesamiento de otros fabricantes de chips como Intel. Por ejemplo, ChatGPT de OpenAI funciona con miles de GPU de Nvidia.

Mientras tanto, Nvidia posee aproximadamente el 80% del mercado de GPU. Sus principales competidores incluyen Advanced Micro Devices y chips de IA de empresas tecnológicas como Amazon, Google y Meta Platforms.

El secreto de la sublimación

El gran avance de la compañía fue el H100, un chip basado en la nueva arquitectura de Nvidia, llamada "Hopper", en honor a la pionera estadounidense de la programación, Grace Hopper. El auge de la inteligencia artificial ha convertido al H100 en el producto más codiciado de Silicon Valley.

Los chips de gran tamaño que se utilizan en los centros de datos tienen 80 000 millones de transistores, cinco veces más silicio que el que alimenta los iPhones más recientes. Aunque cuestan el doble que su predecesor, el A100 (lanzado en 2020), los usuarios del H100 afirman que ofrecen el triple de rendimiento.

El H100 ha demostrado ser particularmente popular entre las grandes empresas tecnológicas como Microsoft y Amazon, que están construyendo centros de datos completos centrados en cargas de trabajo de IA, y las nuevas empresas de IA de nueva generación como OpenAI, Anthropic, Stability AI e Inflection AI porque promete un mayor rendimiento, lo que puede acelerar el lanzamiento de productos o reducir los costos de capacitación a lo largo del tiempo.

"Este es uno de los recursos de ingeniería más escasos que existen", dijo Brannin McBee, director de estrategia y fundador de CoreWeave, una startup en la nube basada en IA que fue una de las primeras empresas en recibir envíos de H100 a principios de este año.

Otros clientes no tienen tanta suerte como CoreWeave, que ha tenido que esperar hasta seis meses para recibir productos para entrenar sus enormes conjuntos de datos. Muchas startups de IA temen que Nvidia no pueda satisfacer la demanda del mercado.

Elon Musk también ordenó miles de chips Nvidia para su startup de inteligencia artificial y dijo que "las GPU son más difíciles de conseguir que los medicamentos en este momento".

Los costos de computación se han disparado. El mínimo invertido en hardware de servidor para desarrollar IA creativa ha alcanzado los 250 millones de dólares, compartió el CEO de Tesla.

Si el H100 llega en el momento oportuno, el avance de Nvidia en IA se remonta a dos décadas atrás, gracias a la innovación de software, más que a la de hardware. En 2006, la compañía presentó el software Cuda, que aprovecha las GPU para acelerar tareas más allá de las gráficas.

“Nvidia vio el futuro antes que nadie y se abocó a las GPU programables. Vieron la oportunidad, apostaron fuerte y superaron constantemente a sus competidores”, afirmó Nathan Benaich, socio de Air Street Capital e inversor en startups de IA .

(Según Reuters, FT)

[anuncio_2]

Fuente

Kommentar (0)