ตามรายงานการวิจัยใหม่ ของ BGR ได้เผยแพร่เทคนิคที่น่าตกใจที่เรียกว่า 'Fun-Tuning' เมื่อใช้ AI (ปัญญาประดิษฐ์) เพื่อสร้างการโจมตีแบบฉีดทันทีที่มีประสิทธิภาพอย่างมากโดยอัตโนมัติโดยกำหนดเป้าหมายไปที่โมเดล AI ขั้นสูงอื่น ๆ รวมถึง Gemini ของ Google ด้วย

วิธีการดังกล่าวทำให้การ "เจาะ" AI เร็วขึ้น ราคาถูกลง และง่ายขึ้นกว่าที่เคย ซึ่งถือเป็นการยกระดับการต่อสู้ด้านความปลอดภัยทางไซเบอร์ที่เกี่ยวข้องกับ AI ขึ้นอีกขั้น

อันตรายเมื่อคนร้ายใช้ AI ทำลาย AI

Prompt injection คือเทคนิคที่ผู้ไม่ประสงค์ดีแอบใส่คำสั่งที่เป็นอันตรายลงในข้อมูลอินพุตของโมเดล AI (เช่น ผ่านความคิดเห็นในโค้ดต้นฉบับ ข้อความที่ซ่อนอยู่บนเว็บ) เป้าหมายคือการ "หลอก" AI ให้หลีกเลี่ยงกฎความปลอดภัยที่ตั้งโปรแกรมไว้ล่วงหน้า ซึ่งจะนำไปสู่ผลลัพธ์ที่ร้ายแรง เช่น การรั่วไหลของข้อมูลที่ละเอียดอ่อน การให้ข้อมูลเท็จ หรือการดำเนินการที่เป็นอันตรายอื่นๆ

แฮกเกอร์กำลังใช้ AI เพื่อโจมตี AI

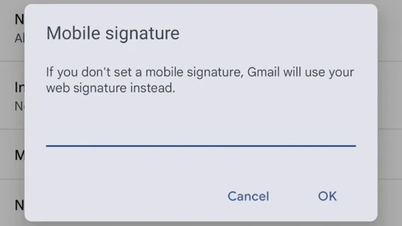

รูปภาพ: ภาพหน้าจอ LINKEDIN

ก่อนหน้านี้ การดำเนินการโจมตีเหล่านี้ให้สำเร็จ โดยเฉพาะกับโมเดล "ปิด" อย่าง Gemini หรือ GPT-4 มักต้องใช้การทดสอบด้วยตนเองที่ซับซ้อนและใช้เวลานานเป็นจำนวนมาก

แต่ Fun-Tuning ได้เปลี่ยนรูปแบบนี้ไปโดยสิ้นเชิง วิธีการที่พัฒนาขึ้นโดยทีมนักวิจัยจากมหาวิทยาลัยหลายแห่งนี้ใช้ประโยชน์จากอินเทอร์เฟซการเขียนโปรแกรมแอปพลิเคชันปรับแต่ง (API) ที่ Google มอบให้กับผู้ใช้ Gemini ฟรีอย่างชาญฉลาด

ด้วยการวิเคราะห์ปฏิกิริยาที่ละเอียดอ่อนของโมเดล Gemini ในระหว่างการปรับแต่ง (เช่น การตอบสนองต่อข้อผิดพลาดในข้อมูล) Fun-Tuning สามารถกำหนด 'คำนำหน้า' และ 'คำต่อท้าย' ที่มีประสิทธิภาพมากที่สุดโดยอัตโนมัติเพื่อซ่อนคำสั่งที่เป็นอันตราย ซึ่งจะเพิ่มโอกาสที่ AI จะปฏิบัติตามเจตนาที่เป็นอันตรายของผู้โจมตีได้อย่างมาก

ผลการทดสอบแสดงให้เห็นว่า Fun-Tuning มีอัตราความสำเร็จสูงถึง 82% ใน Gemini บางเวอร์ชัน ซึ่งถือเป็นตัวเลขที่สูงกว่าวิธีโจมตีแบบเดิมที่ทำได้ไม่ถึง 30%

การเพิ่มความเสี่ยงในการปรับแต่ง Fun-Tuning ก็คือต้นทุนที่ต่ำ เนื่องจาก Google เปิดให้ใช้งาน API สำหรับการปรับแต่งได้ฟรี ต้นทุนในการคำนวณเพื่อสร้างการโจมตีที่มีประสิทธิภาพจึงอาจต่ำเพียง 10 ดอลลาร์ นอกจากนี้ นักวิจัยยังพบว่าการโจมตีที่ออกแบบมาสำหรับ Gemini เวอร์ชันหนึ่งสามารถนำไปใช้กับเวอร์ชันอื่นๆ ได้อย่างง่ายดาย จึงเปิดโอกาสให้เกิดการโจมตีในวงกว้าง

Google ยืนยันว่าทราบถึงภัยคุกคามที่เกิดจาก Fun-Tuning แต่ยังไม่ได้แสดงความคิดเห็นว่าการเปลี่ยนแปลงดังกล่าวจะส่งผลต่อการทำงานของ API การปรับแต่งหรือไม่ นักวิจัยยังชี้ให้เห็นถึงปัญหาเชิงป้องกันด้วยว่า การลบข้อมูลที่ Fun-Tuning ใช้ประโยชน์ในกระบวนการปรับแต่งจะทำให้ API มีประโยชน์น้อยลงสำหรับนักพัฒนาซอฟต์แวร์ที่ถูกต้องตามกฎหมาย ในทางกลับกัน การปล่อยให้เป็นเช่นนี้ต่อไปจะเป็นการเปิดช่องให้ผู้ไม่หวังดีเข้ามาใช้ประโยชน์ต่อไป

การเกิดขึ้นของ Fun-Tuning ถือเป็นการเตือนที่ชัดเจนว่าการเผชิญหน้าในโลกไซเบอร์ได้เข้าสู่ระยะใหม่ที่ซับซ้อนยิ่งขึ้น AI ไม่เพียงแต่เป็นเป้าหมายเท่านั้น แต่ยังเป็นเครื่องมือและอาวุธในมือของผู้กระทำผิดอีกด้วย

ที่มา: https://thanhnien.vn/hacker-dung-ai-de-tan-cong-gemini-cua-google-18525033010473121.htm

การแสดงความคิดเห็น (0)