Nvidia ประกาศเปิดตัวผลิตภัณฑ์ใหม่มากมายในงานนักพัฒนาซอฟต์แวร์เมื่อวันที่ 18 มีนาคม เพื่อตอกย้ำสถานะในตลาดปัญญาประดิษฐ์ (AI) ราคาหุ้นของผู้ผลิตชิปรายนี้เพิ่มขึ้น 54 เท่า และรายได้เพิ่มขึ้นมากกว่าสามเท่านับตั้งแต่ ChatGPT เริ่มต้นการแข่งขัน AI ระดับโลกในช่วงปลายปี 2022 GPU เซิร์ฟเวอร์ระดับไฮเอนด์ของ Nvidia มีความสำคัญอย่างยิ่งต่อการฝึกฝนและการใช้งานโมเดลภาษาขนาดใหญ่ โดยบริษัทต่างๆ เช่น Microsoft และ Meta ทุ่มเงินหลายพันล้านดอลลาร์เพื่อพัฒนาชิปเหล่านี้

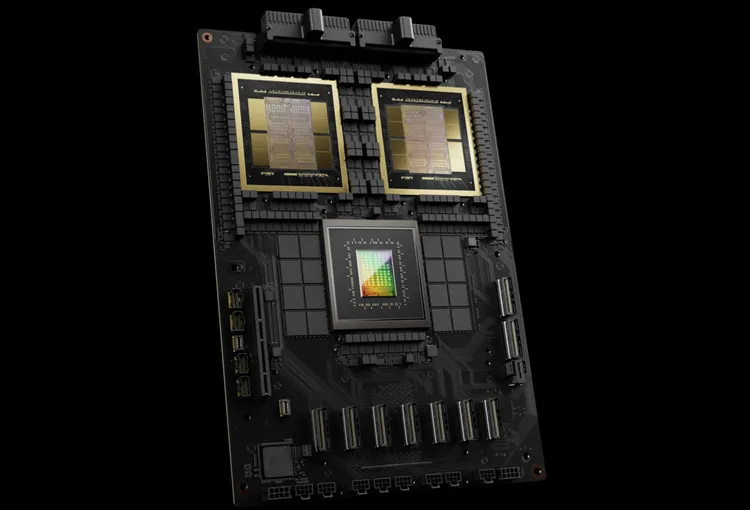

Nvidia เรียกชิป AI รุ่นถัดไปว่า Blackwell ชิป Blackwell ตัวแรกคือ GB200 ซึ่งจะวางจำหน่ายในช่วงปลายปีนี้ Nvidia กำลังนำเสนอชิปที่ทรงพลังยิ่งขึ้นให้กับลูกค้าเพื่อกระตุ้นยอดสั่งซื้อใหม่ ลูกค้ายังคงพยายามดิ้นรนเพื่อให้ได้ชิป H100 Hopper มาครอบครอง

“Hopper นั้นยอดเยี่ยมมาก แต่เราจำเป็นต้องมี GPU ที่ใหญ่กว่านี้” เจนเซ่น หวง ซีอีโอของ Nvidia กล่าวในงาน

นอกจากชิป Blackwell แล้ว Nvidia ยังได้เปิดตัวซอฟต์แวร์ NIM ที่ช่วยให้การใช้งาน AI ง่ายขึ้น เจ้าหน้าที่ของ Nvidia กล่าวว่าบริษัทกำลังกลายเป็นผู้ให้บริการแพลตฟอร์มเช่นเดียวกับ Apple และ Microsoft มากกว่าที่จะเป็นผู้จัดหาชิป

“Blackwell ไม่ใช่ชิป แต่มันคือชื่อของแพลตฟอร์ม” หวงกล่าว มานูเวียร์ ดาส รองประธาน Nvidia สัญญาว่าซอฟต์แวร์ NIM จะช่วยให้นักพัฒนาสามารถรันโปรแกรมบน GPU Nvidia ทุกรุ่น ไม่ว่าจะเก่าหรือใหม่ เพื่อให้เข้าถึงผู้คนได้มากขึ้น

แบล็กเวลล์ “ผู้สืบทอด” ของฮอปเปอร์

Nvidia จะอัปเดตสถาปัตยกรรม GPU ทุก ๆ สองปี เพื่อปลดล็อกประสิทธิภาพที่เพิ่มขึ้นใหม่ ๆ โมเดล AI หลายรุ่นที่เปิดตัวเมื่อปีที่แล้วได้รับการฝึกฝนบนสถาปัตยกรรม Hopper ซึ่งจะพร้อมใช้งานตั้งแต่ปี 2022 เป็นต้นไป

Nvidia ระบุว่าชิปที่ใช้ Blackwell เช่น GB200 ช่วยเพิ่มประสิทธิภาพอย่างมีนัยสำคัญสำหรับธุรกิจ AI โดยให้ความเร็ว 20 เพตาฟล็อป เทียบกับ 4 เพตาฟล็อปบน H100 พลังการประมวลผลนี้ช่วยให้ธุรกิจ AI สามารถฝึกอบรมโมเดลที่มีขนาดใหญ่ขึ้นและซับซ้อนยิ่งขึ้นได้

GPU Blackwell มีขนาดใหญ่และรวมชิปที่ผลิตแยกกันสองตัวไว้ในชิปตัวเดียว นอกจากนี้ยังมีเซิร์ฟเวอร์แบบสมบูรณ์ชื่อ GB200 NVLink 2 ซึ่งรวม GPU Blackwell 72 ตัวและชิ้นส่วน Nvidia อื่นๆ ที่ออกแบบมาเพื่อฝึกฝนโมเดล AI

Amazon, Google, Microsoft และ Oracle จะจำหน่ายสิทธิ์การเข้าถึง GB200 ผ่านบริการคลาวด์ GB200 ประกอบด้วย GPU B200 Blackwell สองตัว และ CPU Grace Nvidia ระบุว่า Amazon Web Services (AWS) จะสร้างคลัสเตอร์เซิร์ฟเวอร์ด้วยชิป GB200 จำนวน 20,000 ตัว

ระบบสามารถรันโมเดลพารามิเตอร์ได้ถึง 27 ล้านล้านตัว ซึ่งมากกว่าโมเดลที่ใหญ่ที่สุดในปัจจุบัน เช่น GPT-4 (1.7 ล้านล้านพารามิเตอร์) นักวิจัย AI หลายคนเชื่อว่าโมเดลขนาดใหญ่ที่มีพารามิเตอร์และข้อมูลมากขึ้นอาจปลดล็อกความสามารถใหม่ๆ ได้

Nvidia ยังไม่ได้ประกาศราคาของ GB200 ใหม่หรือระบบที่มี GB200 อยู่ด้วย นักวิเคราะห์ประเมินว่า H100 ที่ใช้ชิป Hopper ของ Nvidia มีราคาอยู่ระหว่าง 25,000 ถึง 40,000 ดอลลาร์สหรัฐต่อเครื่อง และทั้งระบบอาจมีราคาสูงถึง 200,000 ดอลลาร์สหรัฐ

(ตามรายงานของ CNBC)

แหล่งที่มา

การแสดงความคิดเห็น (0)