Un grupo de destacados expertos internacionales se reunió en Beijing la semana pasada, donde identificaron “líneas rojas” en el desarrollo de IA, incluida la creación de armas biológicas y la realización de ciberataques.

En una declaración días después de la reunión, los académicos advirtieron que se necesita un enfoque común sobre la seguridad de la IA para prevenir “riesgos catastróficos o incluso existenciales para la humanidad en nuestras vidas”.

En el apogeo de la Guerra Fría, la cooperación científica y gubernamental internacional ayudó a prevenir una catástrofe nuclear. La humanidad debe volver a colaborar para prevenir la catástrofe que podría surgir de una tecnología sin precedentes, afirma la declaración.

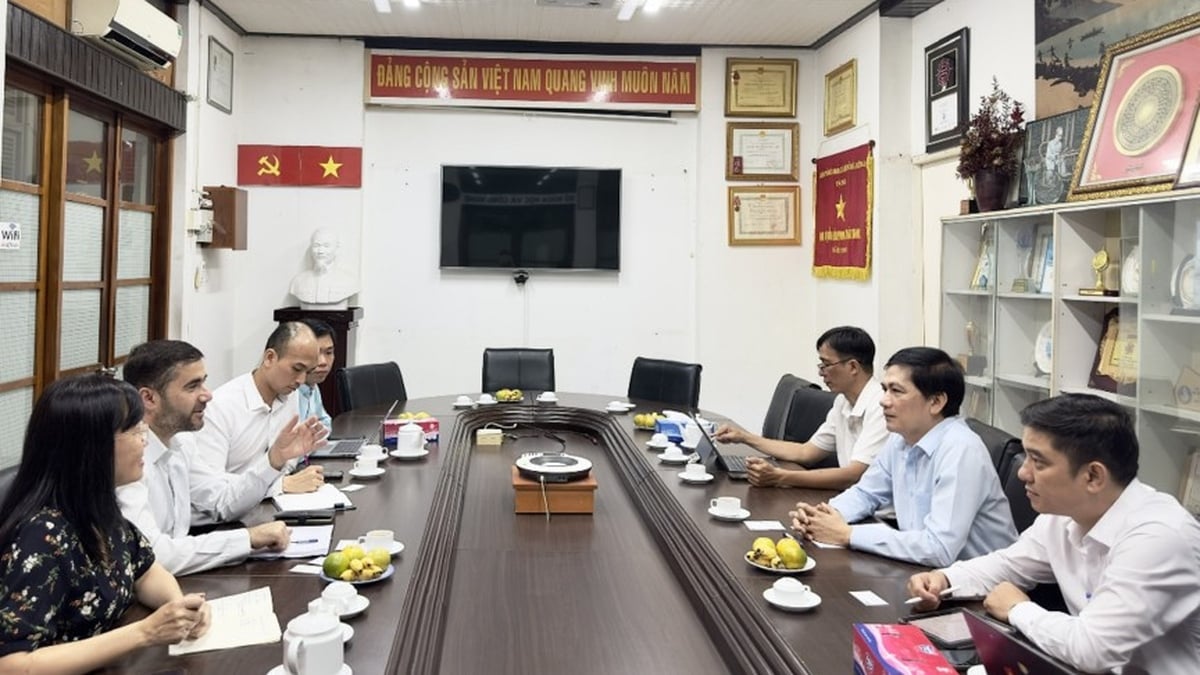

Expertos del Diálogo Internacional sobre Seguridad de la IA en Pekín han identificado puntos críticos en el desarrollo de la IA. Foto: FT

Entre los firmantes se incluyen Geoffrey Hinton y Yoshua Bengio, a menudo descritos como los “padres” de la IA; Stuart Russell, profesor de informática en la Universidad de California; y Andrew Yao, uno de los científicos informáticos más destacados de China.

La declaración se produce después del Diálogo Internacional sobre Seguridad de la IA en Beijing la semana pasada, una reunión a la que asistieron funcionarios del gobierno chino para expresar su aprobación del foro y sus resultados.

El presidente estadounidense, Joe Biden, y el presidente chino, Xi Jinping, se reunieron en noviembre del año pasado para tratar la seguridad de la IA y acordaron entablar un diálogo al respecto. Las principales empresas mundiales de IA también se han reunido en privado con expertos chinos en IA en los últimos meses.

En noviembre de 2023, 28 países, incluida China, y empresas líderes de IA acordaron un amplio compromiso para trabajar juntos para abordar los riesgos existenciales derivados de la IA avanzada en la cumbre de seguridad de IA del Ministro de Hacienda del Reino Unido, Rishi Sunak.

La semana pasada, en Beijing, los expertos discutieron las amenazas asociadas con el desarrollo de la “Inteligencia General Artificial – AGI”, o sistemas de IA que son iguales o superiores a los humanos.

“El tema central del debate fueron las líneas rojas que ningún sistema de IA potente debería cruzar y que los gobiernos de todo el mundo deberían imponer en el desarrollo y la implementación de la IA”, afirmó Bengio.

Estas líneas rojas garantizarían que “ningún sistema de IA pueda replicarse o mejorarse a sí mismo sin el consentimiento y apoyo humano explícito” o “tomar acciones que aumenten indebidamente su poder e influencia”.

Los científicos añadieron que ningún sistema “mejoraría significativamente la capacidad de los actores para diseñar armas de destrucción masiva, violar la convención sobre armas biológicas o químicas” o ser capaz de “realizar automáticamente ciberataques que resulten en graves pérdidas financieras o daños equivalentes”.

Hoang Hai (según el FT)

[anuncio_2]

Fuente

Kommentar (0)