Technologický gigant OpenAI propaguje svůj nástroj pro převod řeči na text Whisper jako umělou inteligenci s „přesností a robustností podobnou lidské“. Whisper má však jednu zásadní chybu: generuje zcela falešný text a věty.

Některé texty generované umělou inteligencí – nazývané „halucinace“ – mohou obsahovat rasové komentáře, násilný jazyk a dokonce i imaginární léčebné postupy – Foto: AP

Část textu generovaného umělou inteligencí je podle agentury AP neskutečná, nazývá se „halucinogenní“ a obsahuje rasové komentáře, násilný jazyk a dokonce i imaginární léčebné postupy.

Vysoká míra „iluze“ v textech generovaných umělou inteligencí

Odborníci jsou obzvláště znepokojeni tím, že Whisper se v mnoha odvětvích po celém světě široce používá k překladu a transkripci rozhovorů, generování textu v populárních spotřebitelských technologiích a vytváření titulků k videím.

Ještě znepokojivější je, že mnoho zdravotnických center používá Whisper k přenosu konzultací mezi lékaři a pacienty, ačkoli OpenAI varovala, že by tento nástroj neměl být používán ve „vysoce rizikových“ oblastech.

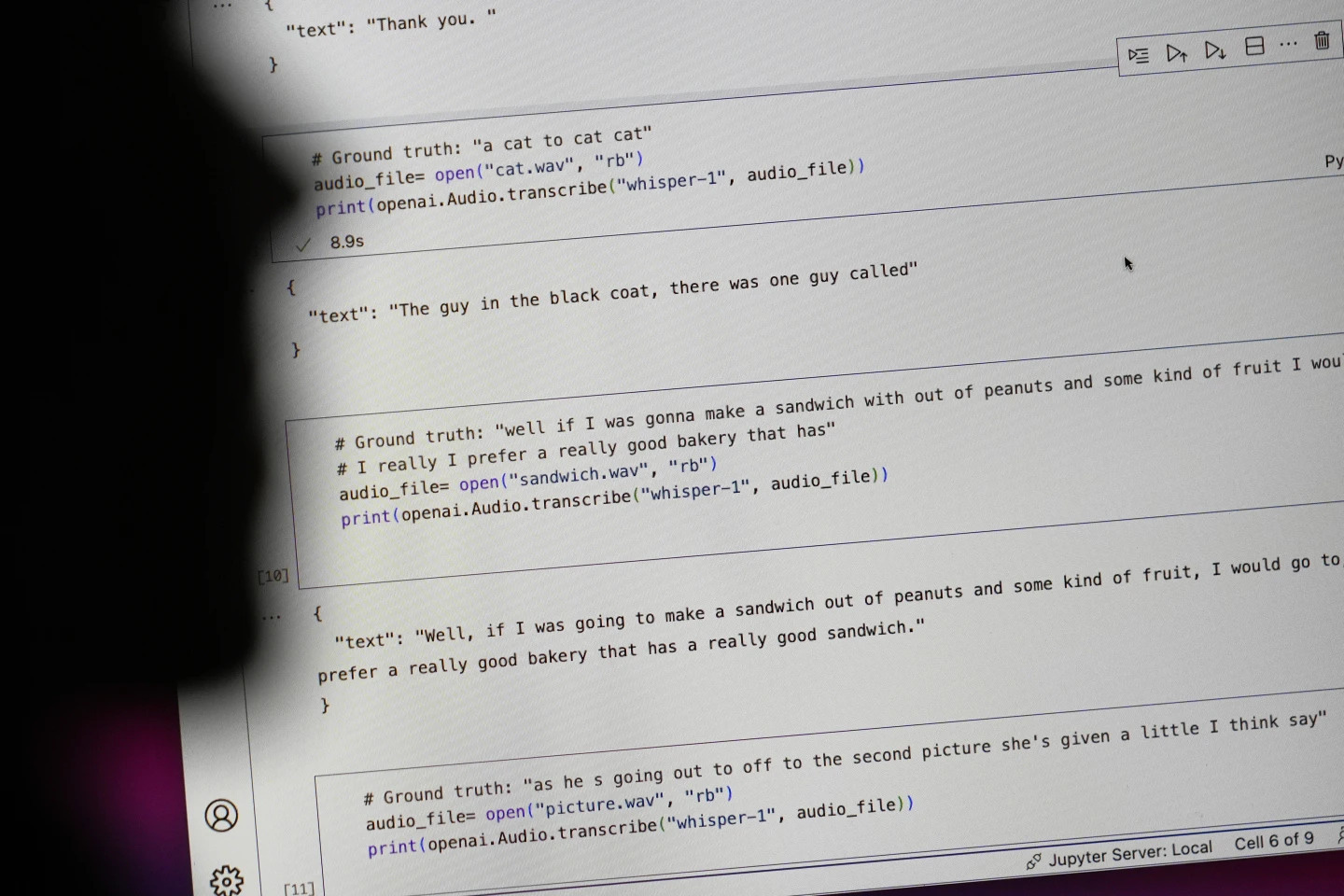

Plný rozsah problému je obtížné určit, ale vědci a inženýři tvrdí, že se při své práci pravidelně setkávají s „halucinacemi“ Whisper.

Výzkumník z Michiganské univerzity uvedl, že v osmi z deseti zkoumaných zvukových přepisů nalezl „halucinace“. Počítačový inženýr nalezl „halucinace“ zhruba v polovině přepisů více než 100 hodin zvuku, které analyzoval. Jiný vývojář uvedl, že nalezl „halucinace“ téměř ve všech z 26 000 nahrávek, které vytvořil pomocí Whisperu.

Problém přetrvává i u krátkých, jasně nahraných zvukových vzorků. Nedávná studie počítačových vědců zjistila 187 „iluzí“ ve více než 13 000 zkoumaných jasných zvukových klipech. Tento trend by podle vědců vedl k desítkám tisíc falešných přepisů v milionech nahrávek.

Takové chyby mohou mít „velmi vážné následky“, zejména v nemocničním prostředí, uvedla Alondra Nelsonová, která do loňského roku vedla Úřad pro vědu a technologie Bílého domu v Bidenově administrativě.

„Nikdo nechce chybnou diagnózu,“ řekl Nelson, nyní profesor na Institutu pro pokročilé studium v Princetonu v New Jersey. „Potřebuje vyšší standard.“

Šepot se také používá k vytváření titulků pro neslyšící a nedoslýchavé – populaci, která je obzvláště ohrožena chybným překladem. Je to proto, že neslyšící a nedoslýchaví lidé nemají způsob, jak identifikovat vymyšlené pasáže „skryté v celém ostatním textu,“ říká Christian Vogler, neslyšící a ředitel Programu pro přístupnost technologií na Gallaudetově univerzitě.

OpenAI je vyzvána k řešení problému

Rozšířenost takových „halucinací“ vedla odborníky, zastánce a bývalé zaměstnance OpenAI k tomu, aby vyzvali federální vládu, aby zvážila regulaci umělé inteligence. OpenAI musí minimálně tuto chybu vyřešit.

„Tento problém je řešitelný, pokud je společnost ochotna mu dát prioritu,“ řekl William Saunders, výzkumný inženýr v San Franciscu, který v únoru opustil OpenAI kvůli obavám ohledně směřování společnosti.

„Je to problém, když ho vydáte a lidé si natolik uvěří, co dokáže, že ho integrují do všech těchto ostatních systémů,“ řekl mluvčí OpenAI. Společnost neustále pracuje na způsobech, jak tyto „iluze“ zmírnit, a váží si zjištění výzkumníků. Dodal, že OpenAI zahrnuje zpětnou vazbu do aktualizací modelů.

Zatímco většina vývojářů předpokládá, že enginy pro převod textu na řeč mohou dělat překlepy nebo jiné chyby, inženýři a výzkumníci tvrdí, že nikdy neviděli engine pro převod textu na řeč poháněný umělou inteligencí, který by „halucinoval“ tolik jako Whisper.

Nobelova cena za fyziku 2024: Zakladatelé umělé inteligence

Nobelova cena za fyziku 2024: Zakladatelé umělé inteligenceZdroj: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[Foto] Generální tajemník To Lam se zúčastnil 80. výročí tradičního dne Lidového soudu](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/13/ff42d08a51cc4673bba7c56f6a576384)

![[Fotografie] Stovky metrů pobřeží Hoi An vážně erodované](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/13/57c85b745a004d169dfe1ee36b6777e5)

Komentář (0)