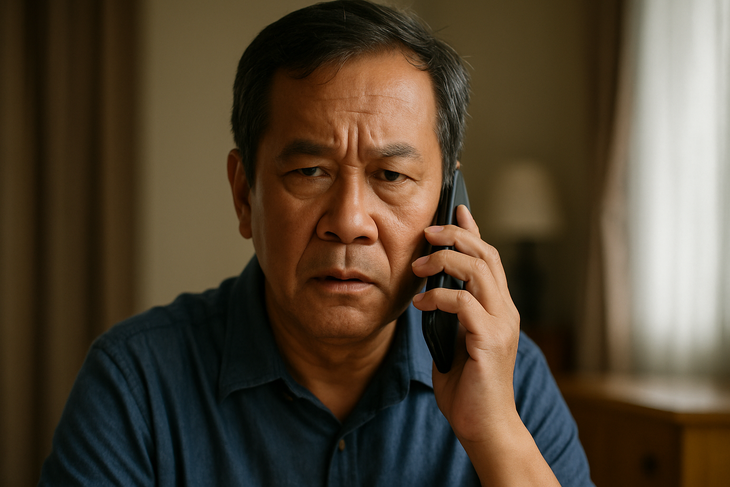

กลโกงหลอกลวงโดยการปลอมเสียงด้วยเสียงดีปเฟก

ในยุคที่ปัญญาประดิษฐ์กำลังพัฒนาอย่างรวดเร็ว เสียง ซึ่งครั้งหนึ่งเคยถูกมองว่าเป็นหลักฐานที่แท้จริง กลับกลายเป็นเครื่องมืออันตรายในมือของผู้ร้าย เทคโนโลยี เสียง Deepfake ช่วยให้เสียงปลอมมีความเหมือนจริงเหมือนคนจริง ทำให้เกิดการโทรปลอมที่ซับซ้อนเพื่อหลอกลวงและยักยอกทรัพย์สิน

ทำไมเสียง Deepfake ถึงน่ากลัว?

เสียง Deepfake เป็นเทคโนโลยีที่ประยุกต์ใช้ปัญญาประดิษฐ์ (AI) และการเรียนรู้ของเครื่องจักรเพื่อสร้างเสียงปลอมที่เหมือนกับเสียงของคนจริงทุกประการ

ด้วยการสนับสนุนของโมเดลทันสมัย เช่น Tacotron, WaveNet, ElevenLabs หรือแพลตฟอร์มโคลนเสียง เช่น Respeecher ผู้หลอกลวงต้องการตัวอย่างเสียงเพียง 3 - 10 วินาทีเท่านั้นเพื่อสร้างดีปเฟกที่เชื่อถือได้ 95%

เสียง Deepfake กลายเป็นอันตรายอย่างยิ่ง เนื่องจากสามารถเลียนเสียงได้เกือบสมบูรณ์แบบ ไม่ว่าจะเป็นการออกเสียง น้ำเสียง หรือแม้แต่พฤติกรรมการพูดที่เป็นเอกลักษณ์เฉพาะตัวของแต่ละคน

สิ่งนี้ทำให้เหยื่อแยกแยะระหว่างเสียงจริงและเสียงปลอมได้ยากมาก โดยเฉพาะเมื่อเสียงนั้นเป็นเสียงของญาติ เพื่อน หรือผู้บังคับบัญชา

การขุดเสียงก็ทำได้ง่ายเช่นกัน เนื่องจากปัจจุบันคนส่วนใหญ่เปิดเผยเสียงผ่านแพลตฟอร์มอย่าง TikTok ไลฟ์สตรีมบนโซเชียลมีเดีย พอดแคสต์ หรือการประชุมออนไลน์ ที่น่ากังวลยิ่งกว่าคือ เสียงดีปเฟกไม่ได้ทิ้งร่องรอยทางสายตา เช่น รูปภาพหรือ วิดีโอ ทำให้การสืบสวนทำได้ยากและเหยื่ออาจสูญเสียเงินได้

ตัวอย่างเสียงเพียงไม่กี่วินาทีก็เพียงพอที่จะสร้าง Deepfake ได้

การหลอกลวงด้วยเสียงแบบ Deepfake กำลังมีความซับซ้อนมากขึ้นเรื่อยๆ โดยมักใช้สถานการณ์ที่คุ้นเคย เช่น การแอบอ้างเป็นคนรู้จักในสถานการณ์ฉุกเฉินเพื่อสร้างความตื่นตระหนกและกดดันให้เหยื่อโอนเงินทันที

ในเวียดนาม มีกรณีหนึ่งที่แม่คนหนึ่งได้รับโทรศัพท์จาก "ลูกชาย" ของเธอ แจ้งว่าเขาประสบอุบัติเหตุและต้องการเงินด่วน ในสหราชอาณาจักร กรรมการบริษัทคนหนึ่งถูกหลอกเอาเงินไปกว่า 240,000 ดอลลาร์สหรัฐ หลังจากได้ยิน "เจ้านาย" ของเขาขอโอนเงินทางโทรศัพท์ พนักงานธุรการคนหนึ่งก็ถูกหลอกเช่นกัน เมื่อได้รับโทรศัพท์จาก "เจ้านายใหญ่" เรียกร้องเงินจาก "พันธมิตรเชิงกลยุทธ์"...

จุดร่วมในสถานการณ์เหล่านี้คือ เสียงปลอมจะถูกสร้างซ้ำเหมือนกับญาติหรือผู้บังคับบัญชาทุกประการ ทำให้เหยื่อไว้วางใจโดยสิ้นเชิงและไม่มีเวลาตรวจสอบ

ตรวจสอบเสมอ อย่าไว้ใจทันที

เนื่องจากกลโกงเสียง Deepfake กำลังเพิ่มสูงขึ้น ประชาชนจึงควรหลีกเลี่ยงการโอนเงินโดยใช้เสียงเพียงอย่างเดียวผ่านทางโทรศัพท์ แม้ว่าจะฟังดูคล้ายกับเสียงของคนที่คุณรักก็ตาม ควรโทรกลับหมายเลขเดิมหรือตรวจสอบข้อมูลผ่านหลายช่องทางก่อนทำธุรกรรมใดๆ

ผู้เชี่ยวชาญหลายคนยังแนะนำให้ตั้ง "รหัสผ่านภายใน" ภายในบ้านหรือธุรกิจเพื่อการตรวจยืนยันในสถานการณ์ที่ไม่ปกติ

นอกจากนี้ จำเป็นต้องจำกัดการโพสต์วิดีโอที่มีเสียงชัดเจนบนโซเชียลมีเดีย โดยเฉพาะเนื้อหาที่มีความยาว โดยเฉพาะอย่างยิ่ง จำเป็นต้องแจ้งเตือนและให้คำแนะนำกลุ่มเปราะบาง เช่น ผู้สูงอายุ หรือผู้ที่ไม่ค่อยได้สัมผัสกับเทคโนโลยี เนื่องจากกลุ่มเหล่านี้ถือเป็นเป้าหมายหลักของการหลอกลวงทางเทคโนโลยีขั้นสูง

เสียงของญาติพี่น้อง เพื่อนฝูง และเพื่อนร่วมงาน ล้วนสามารถปลอมแปลงได้

ในหลายประเทศ ทางการได้เริ่มเข้มงวดการควบคุมเทคโนโลยี Deepfake ด้วยกรอบกฎหมายของตนเอง

ในสหรัฐอเมริกา หลายรัฐได้ห้ามการใช้ดีปเฟกในการหาเสียงเลือกตั้งหรือเผยแพร่ข้อมูลเท็จ สหภาพยุโรป (EU) ได้ผ่านกฎหมาย AI ซึ่งกำหนดให้องค์กรต่างๆ ต้องมีความโปร่งใสและแจ้งเตือนอย่างชัดเจนหากเนื้อหานั้นถูกสร้างขึ้นโดยปัญญาประดิษฐ์

ในขณะเดียวกัน ในเวียดนาม แม้ว่าจะไม่มีกฎระเบียบเฉพาะสำหรับเสียง deepfake แต่การกระทำที่เกี่ยวข้องสามารถดำเนินการได้ตามกฎหมายปัจจุบัน โดยมีอาชญากรรม เช่น การฉ้อโกง การละเมิดความเป็นส่วนตัว หรือการฉ้อโกงข้อมูลส่วนตัว

อย่างไรก็ตาม ความเป็นจริงก็คือ เทคโนโลยีกำลังพัฒนาในอัตราที่เกินกว่ากฎหมายจะตรวจสอบได้มาก ทำให้เกิดช่องโหว่มากมายที่ผู้ไม่หวังดีสามารถใช้ประโยชน์ได้

เมื่อเสียงไม่ใช่หลักฐานอีกต่อไป

เสียงเคยเป็นสิ่งที่ใกล้ชิดและน่าเชื่อถือ แต่ด้วยเสียงแบบดีปเฟก เสียงเหล่านี้ไม่สามารถเป็นหลักฐานที่เชื่อถือได้อีกต่อไป ในยุค AI ทุกคนจำเป็นต้องมีความรู้เกี่ยวกับการป้องกันทางดิจิทัล ตรวจสอบเชิงรุก และเฝ้าระวังอยู่เสมอ เพราะการโทรอาจเป็นกับดักได้

ที่มา: https://tuoitre.vn/lua-dao-bang-deepfake-voice-ngay-cang-tinh-vi-phai-lam-sao-20250709105303634.htm

![[ข่าวการเดินเรือ] กว่า 80% ของความสามารถในการขนส่งตู้คอนเทนเนอร์ทั่วโลกอยู่ในมือของ MSC และพันธมิตรการขนส่งรายใหญ่](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

การแสดงความคิดเห็น (0)