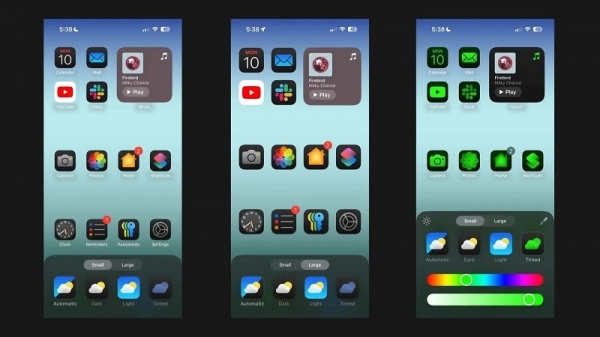

Selon Android Authority , une étude d'Apple détaille une solution permettant d'exécuter des modèles de langage volumineux (LLM) sur des appareils disposant de peu de RAM. L'étude révèle comment l'entreprise peut stocker des « paramètres de modèle » et en charger une partie dans la RAM de l'appareil si nécessaire, au lieu de charger l'intégralité du modèle dans la RAM.

Apple cherche à aider les anciens iPhones avec moins de RAM à exécuter l'IA générale

L'article affirme que cette méthode permet d'exécuter des modèles qui nécessitent deux fois plus de RAM qu'un iPhone peut avoir tout en garantissant des vitesses d'inférence 4 à 5 fois et 20 à 25 fois supérieures par rapport aux méthodes de chargement simples sur le CPU et le GPU respectivement.

Déployer une IA synthétique sur un appareil doté de plus de RAM constituerait un avantage considérable, car cela permettrait des vitesses de lecture/écriture plus rapides. La vitesse est essentielle pour l'IA embarquée, car elle permet des temps d'inférence bien plus courts, car les utilisateurs n'ont pas nécessairement à attendre des dizaines de secondes (ou plus) pour obtenir une réponse ou un résultat final. Tout cela signifie qu'un assistant IA embarqué pourrait potentiellement fonctionner à la vitesse d'une conversation, générer des images/textes beaucoup plus rapidement, résumer des articles plus rapidement, etc. Mais la solution d'Apple signifie que les utilisateurs n'ont pas nécessairement besoin de beaucoup de RAM pour accélérer la réactivité des tâches d'IA embarquées.

L'approche d'Apple pourrait permettre aux iPhone, anciens comme nouveaux, d'intégrer des fonctionnalités d'IA synthétique directement sur l'appareil. C'est important, car les iPhone d'Apple offrent généralement moins de RAM que les téléphones Android haut de gamme. La série iPhone 11, par exemple, n'offre que 4 Go de RAM, tandis que l'iPhone 15 d'entrée de gamme n'en propose que 6 Go.

Apple n'est pas le seul fabricant de mobiles à travailler sur la réduction de la taille de la mémoire LLM. Les puces phares récentes de Qualcomm et MediaTek prennent toutes deux en charge la précision INT4 pour réduire la taille de ces modèles. Quoi qu'il en soit, les entreprises cherchent de nouvelles façons de réduire la configuration système requise pour l'IA embarquée, permettant même aux téléphones d'entrée de gamme d'offrir cette fonctionnalité.

Lien source

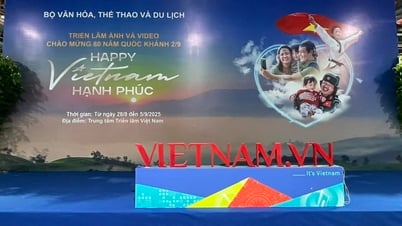

![[Photo] Espace culturel multicolore à l'Exposition « 80 ans du parcours Indépendance - Liberté - Bonheur »](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/26/fe69de34803e4ac1bf88ce49813d95d8)

![[Photo] Hanoï : les autorités travaillent dur pour surmonter les effets des fortes pluies](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/26/380f98ee36a34e62a9b7894b020112a8)

Comment (0)