ล่าสุด กรมรักษาความปลอดภัยสารสนเทศได้ออกคำเตือนเกี่ยวกับการฉ้อโกงภาพและ วิดีโอ ไฮเทคที่เกิดขึ้นซ้ำแล้วซ้ำเล่า

ด้วยเหตุนี้ สถานการณ์ของผู้ก่ออาชญากรรมทางไซเบอร์ที่ใช้ประโยชน์จากภาพและวิดีโอสาธารณะของผู้คน เพื่อตัดต่อ ตัดต่อ และข่มขู่แบล็กเมล์ด้วยวิดีโอปลอม จึงได้รับการเตือนจากทางการให้ประชาชนทราบเป็นวงกว้างแล้ว

โดยใช้เทคโนโลยี Deepfake ซึ่งช่วยให้สามารถจำลองเสียงและภาพของบุคคลได้ด้วยความแม่นยำสูง ผู้กระทำความผิดสามารถปลอมตัวเป็นผู้นำในการประชุมออนไลน์ หรือสร้างวิดีโอและการโทรเพื่อกระทำการฉ้อโกงทางการเงินได้

ยิ่งไปกว่านั้น การหลอกลวงเหล่านี้มักจะใช้ประโยชน์จากปัจจัยทางจิตวิทยา เช่น ความเร่งด่วน ความกลัว หรืออำนาจ ทำให้เหยื่อดำเนินการอย่างเร่งรีบโดยไม่ตรวจสอบความถูกต้องอย่างรอบคอบ

Deepfakes ไม่เพียงแต่เป็นการหลอกลวงด้านการลงทุนทางการเงินเท่านั้น อีกตัวอย่างหนึ่งคือการหลอกลวงเรื่องความรัก ซึ่ง Deepfakes ถูกใช้เพื่อสร้างตัวละครสมมติที่โต้ตอบกับเหยื่อผ่านวิดีโอคอล หลังจากที่ได้รับความไว้วางใจจากเหยื่อแล้ว ผู้หลอกลวงจะขอโอนเงินเพื่อแก้ปัญหาฉุกเฉิน ค่าเดินทาง หรือเงินกู้

จากสถานการณ์ดังกล่าว กรมการรักษาความปลอดภัยข้อมูลจึงแนะนำให้ประชาชนระมัดระวังคำแนะนำด้านการลงทุนจากผู้มีชื่อเสียงบนโซเชียลเน็ตเวิร์ก ระวังข้อความ อีเมล หรือการโทรที่ไม่ระบุตัวตน และสังเกตการแสดงสีหน้าไม่เป็นธรรมชาติในวิดีโออย่างระมัดระวัง

นอกจากนี้ ผู้คนยังต้องจำกัดการโพสต์เนื้อหาที่เกี่ยวข้องกับข้อมูลส่วนตัวบนเครือข่ายโซเชียล เพื่อหลีกเลี่ยงการถูกขโมยข้อมูล เช่น รูปภาพ วิดีโอ หรือเสียง โดยคนร้าย ขณะเดียวกัน ควรตั้งค่าบัญชีเป็นโหมดส่วนตัวเพื่อปกป้องข้อมูลส่วนบุคคล

นายโง มินห์ ฮิเออ ผู้เชี่ยวชาญด้านความปลอดภัยทางไซเบอร์และผู้ก่อตั้งร่วมของโครงการป้องกันการฉ้อโกงทางไซเบอร์ของเวียดนาม (Chongluadao.vn) ให้สัมภาษณ์กับผู้สื่อข่าวของหนังสือพิมพ์ได โดอัน เก็ท ว่าการใช้เทคโนโลยี Deepfake ใน AI เพื่อปลอมแปลงวิดีโอคอลเพื่อจุดประสงค์ในการฉ้อโกงยังคงมีความซับซ้อน โดยผู้โจมตีใช้ประโยชน์จากเทคโนโลยีนี้เพื่อเพิ่มความน่าเชื่อถือให้กับ "เหยื่อ" ของตน

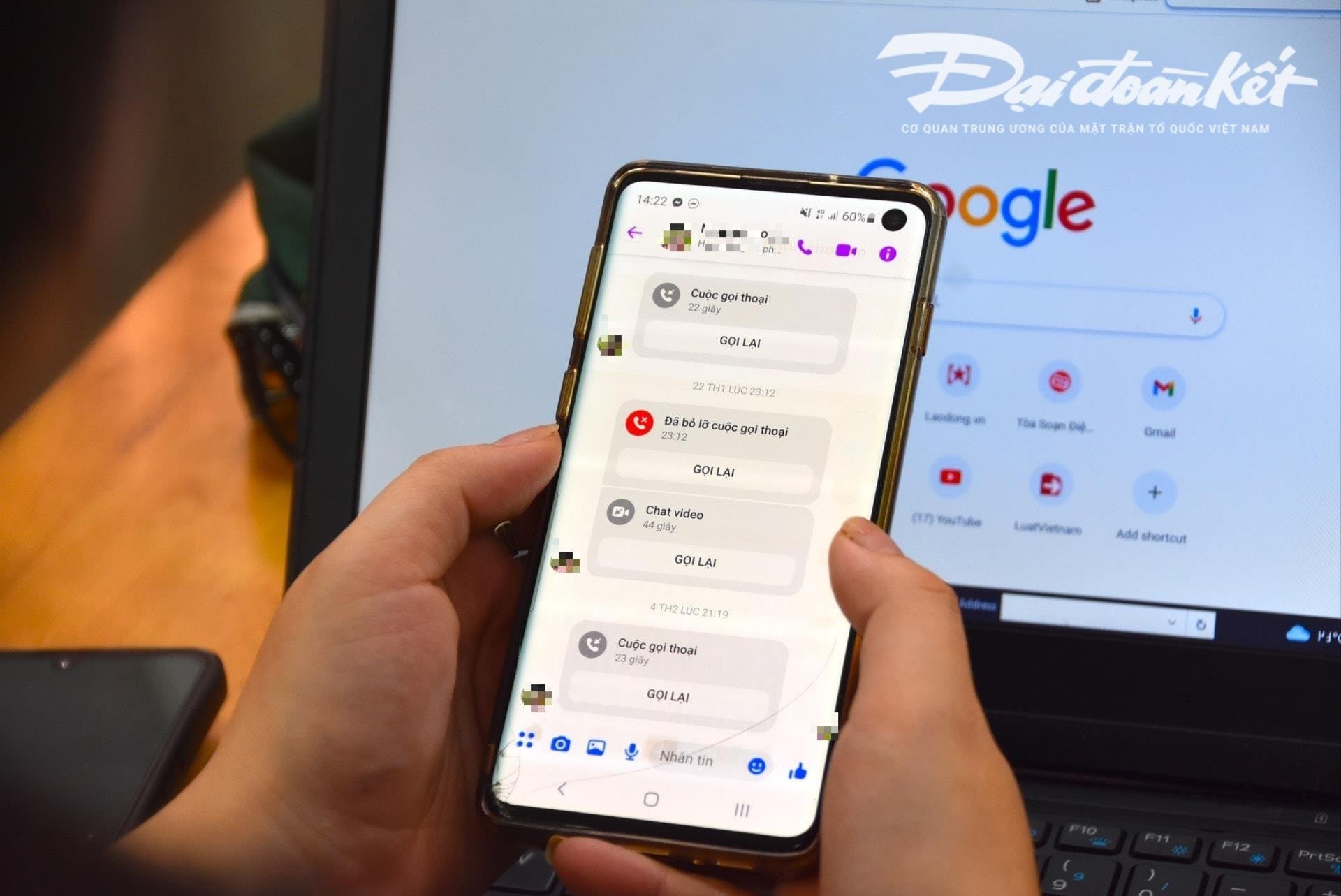

โดยเฉพาะอย่างยิ่ง ผู้เสียหายจะทำการโทรวิดีโอหาเหยื่อจากภาพและวิดีโอที่ "ขโมย" มาก่อน จากนั้นจึงทำการประมวลผลข้อมูลทางเทคนิค บิดเบือนเสียง หรือแก้ไขปัญหาภาพปลอม เพื่อสร้างความไว้วางใจให้กับเหยื่อ

โดยทั่วไปการโทรเหล่านี้มักสั้นมาก กินเวลาเพียงไม่กี่วินาที จากนั้นผู้หลอกลวงจึงอ้างข้ออ้างว่าเครือข่ายไม่เสถียร อยู่บนถนน ฯลฯ เพื่อขอให้เหยื่อทำตามคำขอของผู้หลอกลวง

ผู้เชี่ยวชาญเตือนว่าการใช้ AI เพื่อการฉ้อโกงทางไซเบอร์มีแนวโน้มเพิ่มขึ้นอย่างมากในอนาคตอันใกล้นี้ ดังนั้น ผู้คนจึงต้องสร้างความตระหนักรู้โดยเฉพาะอย่างยิ่งเมื่อได้รับข้อความ วิดีโอคอล และลิงก์แปลก ๆ

ตามการวิเคราะห์ของผู้เชี่ยวชาญ อัลกอริทึมปัญญาประดิษฐ์ (AI) Deepfake ในปัจจุบันจะไม่สามารถจัดการได้หากผู้โทรเลี้ยวซ้าย เลี้ยวขวา หรือยืนขึ้น...

จุดอ่อนอย่างหนึ่งที่ผู้คนต้องใส่ใจเมื่อรับสายคือฟัน ดังนั้นอัลกอริทึม AI ในปัจจุบันจึงไม่สามารถสร้างฟันของบุคคลที่ถูกปลอมแปลงได้

หากใช้ Deepfake รูปภาพของบุคคลที่กำลังอ้าปากอาจไม่มีฟัน บางคนมีขากรรไกร 3 ขากรรไกรหรือ 4 ขากรรไกร ดังนั้น ลักษณะของฟันจึงเป็นองค์ประกอบที่จดจำได้มากที่สุดของการโทรปลอมโดยใช้ Deepfake

การ “ชะลอความเร็ว” และไม่ปฏิบัติตามคำร้องขอทันทีเป็นเงื่อนไขเบื้องต้นเพื่อหลีกเลี่ยงการตกหลุมพรางการหลอกลวง เมื่อได้รับข้อความหรือโทรศัพท์ผ่านโซเชียลเน็ตเวิร์ก ผู้คนควรโทรหาญาติโดยตรงเพื่อยืนยันว่าใครเป็นคนติดต่อพวกเขา โดยใช้เวลาอย่างน้อย 30 วินาที หรือพบปะกันเป็นการส่วนตัว

ในกรณีที่สงสัยว่ามีการแอบอ้างเป็นญาติในโซเชียลเน็ตเวิร์กเพื่อฉ้อโกงหรือยักยอกทรัพย์สิน จำเป็นต้องรายงานไปยังหน่วยงานตำรวจที่ใกล้ที่สุดทันที เพื่อการสนับสนุนและการจัดการอย่างทันท่วงที

ที่มา: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

การแสดงความคิดเห็น (0)