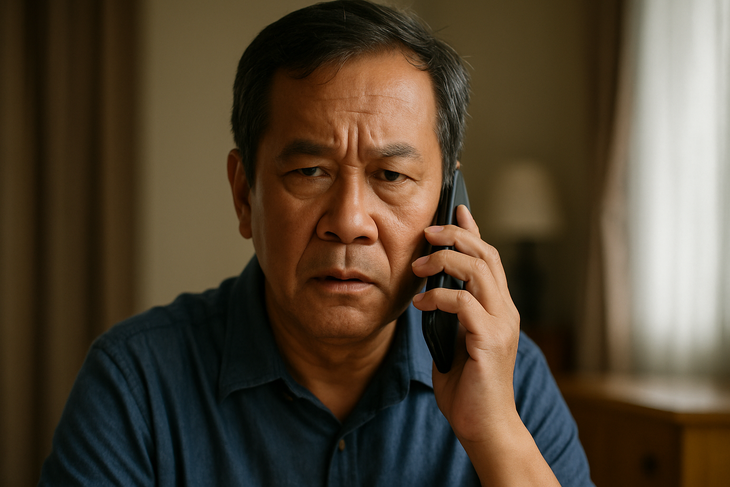

딥페이크 음성으로 음성 사칭하는 사기 수법

급속도로 발전하는 인공지능 시대에, 한때 확실한 증거로 여겨졌던 음성은 이제 악당들의 손에 들어가면 위험한 도구가 되었습니다. 딥페이크 음성 기술은 실제 사람과 똑같은 가짜 음성을 만들어내, 정교한 가짜 통화를 통해 재산을 사취하고 탈취하는 데 사용됩니다.

딥페이크 목소리가 무서운 이유는?

딥페이크 음성은 인공지능(AI)과 머신러닝을 적용하여 실제 사람의 목소리와 동일한 가짜 음성을 만드는 기술입니다.

Tacotron, WaveNet, ElevenLabs와 같은 최신 모델이나 Respeecher와 같은 음성 복제 플랫폼의 지원을 받으면 사기꾼은 3~10초 분량의 음성 샘플만으로 95% 신뢰도 높은 딥페이크를 만들 수 있습니다.

딥페이크 음성은 발음, 억양, 심지어 각 사람의 독특한 말투 습관까지 거의 완벽하게 사람의 목소리를 흉내낼 수 있기 때문에 특히 위험합니다.

이로 인해 피해자는 진짜와 가짜를 구별하기가 매우 어렵습니다. 특히 목소리가 친척, 친구 또는 상사의 것일 경우 더욱 그렇습니다.

음성 마이닝 또한 쉽습니다. 오늘날 대부분의 사람들이 TikTok, 소셜 미디어 라이브 스트리밍, 팟캐스트, 온라인 회의 등의 플랫폼을 통해 자신의 음성을 노출하고 있기 때문입니다. 더욱 우려스러운 점은 딥페이크 음성은 이미지나 동영상 처럼 시각적인 흔적을 남기지 않아 수사를 어렵게 만들고 피해자는 금전적 피해를 입을 위험이 있다는 것입니다.

단 몇 초의 음성 샘플만으로도 딥페이크를 만들 수 있다

딥페이크 음성 사기는 점점 더 정교해지고 있으며, 종종 익숙한 시나리오를 이용합니다. 즉, 비상 상황에 있는 지인을 사칭하여 피해자에게 공황 상태를 조성하고 즉시 돈을 이체하도록 압력을 가하는 것입니다.

베트남에서는 어머니가 "아들"에게서 사고를 당해서 급히 돈이 필요하다는 전화를 받은 사건이 있었습니다. 영국에서는 한 회사 임원이 "사장"의 전화 송금 요청을 듣고 24만 달러 이상을 사기당했습니다. 한 관리직 직원도 "전략적 파트너"에게 돈을 지불해 달라고 요청하는 "사장"의 전화를 받고 사기를 당했습니다.

이런 상황에서 공통적으로 나타나는 점은 가짜 목소리가 친척이나 상관의 목소리처럼 똑같이 재현되어 피해자가 그것을 절대적으로 신뢰하게 되고 확인할 시간도 없게 된다는 것입니다.

항상 확인하고, 즉시 믿지 마세요

딥페이크 음성 사기가 증가함에 따라, 사랑하는 사람의 목소리와 똑같다고 하더라도 음성만으로 전화로 돈을 이체하지 않는 것이 좋습니다. 대신, 거래를 하기 전에 이전 번호로 다시 전화를 걸거나 여러 채널을 통해 정보를 확인하세요.

많은 전문가는 특이한 상황에 대비해 집이나 회사 내부에 "내부 비밀번호"를 설정할 것을 권장합니다.

또한, 특히 긴 콘텐츠의 경우, 목소리가 또렷한 영상의 소셜 네트워크 게시를 제한해야 합니다. 특히, 노약자나 기술에 대한 노출이 적은 계층 등 취약 계층은 첨단 기술 사기의 주요 타깃이 되므로, 적극적으로 경고하고 안내해야 합니다.

친척, 친구, 동료의 목소리도 모두 가짜로 만들 수 있습니다.

많은 국가에서 당국은 자체적인 법적 틀을 마련하여 딥페이크 기술에 대한 통제를 강화하기 시작했습니다.

미국에서는 여러 주에서 선거 운동이나 허위 정보 유포에 딥페이크를 사용하는 것을 금지했습니다. 유럽연합(EU)은 AI법을 통과시켜, 관련 기관들이 투명성을 확보하고 인공지능이 콘텐츠를 생성할 경우 명확하게 경고하도록 요구했습니다.

한편, 베트남에서는 딥페이크 음성에 대한 구체적인 규정은 없지만, 관련 행위는 현행법에 따라 사기, 사생활 침해, 신원 사기 등의 범죄로 처리될 수 있습니다.

그러나 현실은 기술이 법의 감시 능력을 훨씬 뛰어넘는 속도로 발전하고 있어 나쁜 행위자가 악용할 수 있는 허점이 많이 남아 있다는 것입니다.

목소리가 더 이상 증거가 아닐 때

음성은 예전에는 친밀하고 신뢰할 수 있는 것이었지만, 딥페이크 음성으로 인해 더 이상 신뢰할 수 있는 증거가 될 수 없습니다. AI 시대에는 모든 사람이 디지털 보안에 대한 지식을 갖추고, 적극적으로 검증하며, 통화가 함정이 될 수 있으므로 항상 경계해야 합니다.

출처: https://tuoitre.vn/lua-dao-bang-deepfake-voice-ngay-cang-tinh-vi-phai-lam-sao-20250709105303634.htm

![[해양뉴스] 세계 컨테이너 운송량 80% 이상 MSC 및 주요 해운 동맹에 집중돼](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

댓글 (0)