Googleの親会社であるAlphabetは、AI原則の最新版を発表し、今後のAI活用計画を概説しました。特に注目すべきは、AIを武器、監視ツール、あるいは「広範囲に危害をもたらす可能性のある技術」の開発に利用しないという約束を削除したことです。

GoogleのAIに関するレッドライン

GoogleのAIにおける「レッドライン」という言葉が初めて登場したのは2018年、米国防総省との共同研究である同社のAIプロジェクト「Maven」に従業員が抗議した時でした。当時、4,000人以上のGoogle従業員が、プロジェクトを終了させ、同社が「戦争のための技術」を決して開発しないよう求める嘆願書に署名しました。

その後、Googleは国防総省向けのAIツール構築契約を更新しなかった。同社はまた、国際的に認められた規範に違反する監視目的で情報を収集または利用する兵器や技術を含む、AIの「非規範的用途」もGoogleは使用しないと宣言し、明確な線を引いた。公衆に危害をもたらす、または及ぼす可能性のある技術、あるいは広く受け入れられている国際法および人権の原則に違反する技術も使用しない。

iPhone上の一部のGoogleアプリ

AIと兵器の併用に一線を引くという決定により、グーグルはアマゾンやマイクロソフトなど他のテクノロジー大手が締結した軍事協定に参加できなくなった。

しかし、AI競争における大きな変化に直面し、Googleは約束を撤回することを決定しました。これはGoogle社内だけでなく、シリコンバレーのテクノロジー企業の防衛産業における重要な転換を示す大きな論争を引き起こしました。

Googleは内部で分裂している

Business Insiderによると、AIの原則と倫理に関するアップデートは、Google従業員から強い反発を引き起こした。従業員たちは社内掲示板で不満を表明している。CEOのサンダー・ピチャイがGoogleの検索エンジンに「兵器請負業者になるにはどうすればいいか?」と質問するミームは、大きな注目を集めている。

別の従業員は、「武器や監視のためのAIの解禁で、我々は悪者になるのか?」と問いかけるミームを作成しました。同社は18万人以上の従業員を抱えています。米国政府やその軍事・防衛分野の顧客とより緊密に連携するというGoogleの決定を支持する声はまだあるかもしれません。

Googleの推論

Googleの広報担当者は、「AIの約束」撤回に関するコメント要請にすぐには応じなかった。しかし、AI部門責任者のデミス・ハサビス氏は、ガイドラインは変化する世界の中で進化しており、AIは「国家安全保障を守る」ものだと述べた。

ハサビス氏とグーグルのテクノロジー・社会担当上級副社長のジェームズ・マニカ氏は、同社のブログ投稿で、AIにおけるリーダーシップをめぐる世界的な競争が激化する中、グーグルはAIが自由、平等、人権の尊重に基づいて推進されるべきだと信じていると述べた。

「企業、政府、組織は価値観を共有しており、人々を守り、世界の成長を促進し、国家安全保障を支えることができるAIを共同で開発すべきだと私たちは考えています」と両氏は付け加えた。

Googleの幹部2人は、数十億人が日常生活でAIを利用していると述べました。人工知能(AI)は汎用技術となり、無数の組織や個人がアプリケーションを構築するために利用するプラットフォームとなっています。AIは、研究室でのニッチな研究テーマから、携帯電話やインターネットと同じくらい遍在する技術へと進化しました。そのため、2018年に発表されたGoogleの「AIの誓い」も、それに合わせて更新される必要があります。

アルファベットは来年、主にAIの機能とインフラの構築に750億ドルを費やす計画だと述べた。

[広告2]

出典: https://thanhnien.vn/google-rut-lai-loi-hua-khong-dung-ai-cho-quan-su-185250206161804981.htm

![[写真] 政治局はダナン市党委員会常務委員会とクアンニン省党委員会と協力する](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/19/b1678391898c4d32a05132bec02dd6e1)

![[写真] ホーチミン市初の国際金融センタービルのクローズアップ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/19/3f06082e1b534742a13b7029b76c69b6)

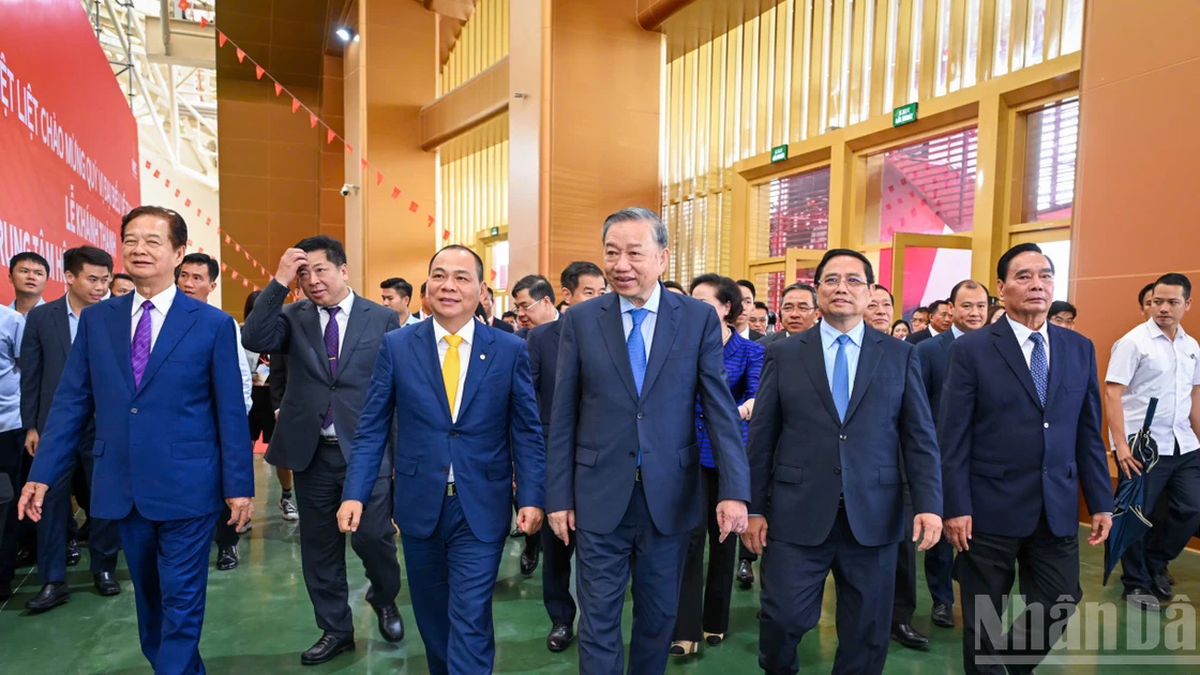

![[写真] ト・ラム事務総長が建国記念日を祝う250のプロジェクトの開所式と起工式に出席](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/19/3aa7478438a8470e9c63f4951a16248b)

コメント (0)