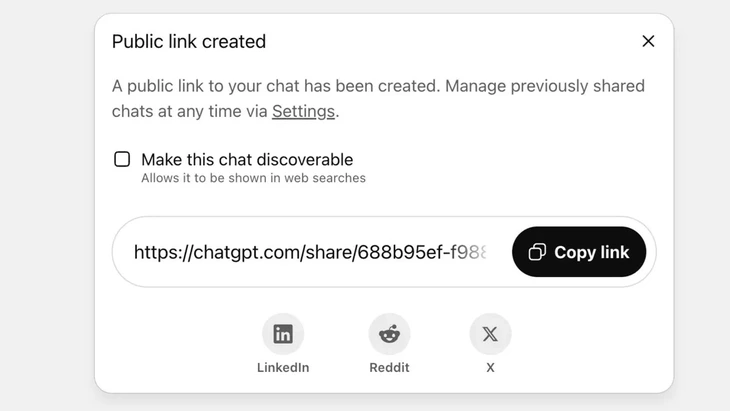

Funcție de partajare a chatului prin link public pe ChatGPT - Fotografie: Techradar

ChatGPT ajunge acum la peste 2,5 miliarde de interogări de la utilizatori la nivel global în fiecare zi, demonstrând popularitatea tot mai mare a acestui chatbot.

Totuși, acest instrument se confruntă cu reacții negative puternice din partea utilizatorilor, deoarece funcția de „partajare” a cauzat scurgerea de informații sensibile din mii de conversații către Google și mai multe motoare de căutare de pe internet.

Risc ridicat de securitate

Dl. Vu Ngoc Son - șeful departamentului tehnic al Asociației Naționale pentru Securitate Cibernetică (NCA) - a evaluat că incidentul menționat mai sus prezintă un nivel ridicat de risc de securitate pentru utilizatorii ChatGPT.

„Incidentul de mai sus nu este neapărat o eroare tehnică, deoarece există o anumită inițiativă din partea utilizatorului în a da clic pe butonul de partajare. Cu toate acestea, se poate spune că problema constă în designul produsului chatbot cu inteligență artificială, care a derutat utilizatorii și nu există măsuri de avertizare suficient de puternice cu privire la riscul scurgerii de date personale dacă utilizatorii partajează”, a analizat dl. Vu Ngoc Son.

Pe ChatGPT, această funcție este implementată după ce utilizatorul alege să partajeze chatul printr-un link public, conținutul urmând să fie stocat pe serverul OpenAI ca site web public (chatgpt.com/share/...), fără a fi necesare date de autentificare sau parolă pentru acces.

Crawlerele Google scanează și indexează automat aceste pagini, făcându-le să apară în rezultatele căutării, inclusiv text, imagini sau date sensibile din chat.

Mulți utilizatori nu erau conștienți de risc, crezând că partajau conversații cu prietenii sau contactele lor. Acest lucru a dus la expunerea a mii de conversații, unele conținând informații personale sensibile.

Deși OpenAI a eliminat rapid funcția la sfârșitul lunii iulie 2025, în urma unei reacții negative din partea comunității, a fost nevoie de timp pentru a se coordona cu Google pentru a elimina vechii indecși. Mai ales cu sistemul complex de stocare, care include serverele cache ale Google, acest lucru nu se poate face rapid.

Nu tratați chatboții cu inteligență artificială ca pe o „cutie neagră de siguranță”

Expert în securitatea datelor Vu Ngoc Son - șeful departamentului de tehnologie la Asociația Națională pentru Securitate Cibernetică (NCA) - Foto: CHI HIEU

Scurgerea de informații a mii de chat-uri poate prezenta riscuri pentru utilizatori, cum ar fi dezvăluirea secretelor personale, a secretelor de afaceri; afectarea reputației, riscuri financiare sau chiar pericole pentru siguranță atunci când se dezvăluie adresele de domiciliu.

„Chatboții bazați pe inteligență artificială sunt utili, dar nu sunt o «cutie neagră», deoarece datele partajate pot rămâne pe web pentru totdeauna dacă nu sunt controlate.”

Incidentul este cu siguranță o lecție atât pentru furnizori, cât și pentru utilizatori. Alți furnizori de servicii de inteligență artificială pot învăța din această experiență și pot proiecta caracteristici cu avertismente mai clare și mai transparente.

„În același timp, utilizatorii trebuie să limiteze în mod proactiv postarea necontrolată a informațiilor de identificare personală sau confidențiale pe platformele de inteligență artificială”, a recomandat expertul în securitate Vu Ngoc Son.

Potrivit experților în securitatea datelor, incidentul menționat mai sus demonstrează că există nevoie de coridoare legale și standarde de securitate cibernetică pentru IA. Furnizorii și dezvoltatorii de IA trebuie, de asemenea, să proiecteze sisteme care să asigure securitatea, evitând riscul scurgerilor de date, cum ar fi: scurgeri prin vulnerabilități grave; vulnerabilități software care duc la atacuri asupra bazelor de date; control deficitar care duce la otrăvire, abuz pentru a răspunde la întrebări înșelătoare și distorsionate.

De asemenea, utilizatorii trebuie să controleze partajarea informațiilor personale cu inteligența artificială și să nu partajeze informații sensibile. În cazurile în care este cu adevărat necesar, este recomandabil să se utilizeze modul anonim sau să se cripteze activ informațiile pentru a evita ca datele să fie legate direct de anumite persoane.

Sursă: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Foto] Maiestuosul „ochi al mării” din mijlocul oceanului orașului Da Nang](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/3/a2cdfcc4501140e6a6bc2ad767f64b36)

Comentariu (0)