"No lo puedo entender", dijo Andrew Wee, quien tiene 30 años de experiencia en la industria de centros de datos y hardware en Silicon Valley.

Lo que lo desconcertó, incluso lo enojó, fueron las demandas energéticas proyectadas de las futuras supercomputadoras de IA, las máquinas que se suponía impulsarían el gran salto adelante de la humanidad.

Wee, quien ha ocupado altos cargos en Apple y Meta y ahora es jefe de hardware del proveedor de la nube Cloudflare, cree que el crecimiento actual de la energía necesaria para la IA (que el Foro Económico Mundial estima que crecerá un 50% por año hasta 2030) es insostenible.

“Necesitamos encontrar soluciones técnicas, soluciones políticas y otras soluciones para abordar esto colectivamente”, dijo Wee.

Un nuevo camino para los chips de IA

Para ello, el equipo de Wee en Cloudflare está probando un tipo de chip completamente nuevo, de una startup fundada en 2023 llamada Positron, que acaba de anunciar una nueva ronda de inversión de 51,6 millones de dólares .

Estos chips tienen el potencial de ser mucho más eficientes energéticamente que los chips de Nvidia, el líder de la industria en tareas de inferencia.

Este es el proceso de generar respuestas de IA a partir de las solicitudes de los usuarios. Si bien los chips Nvidia seguirán utilizándose para entrenar a la IA en el futuro previsible, una inferencia más eficiente podría ahorrar a las empresas decenas de miles de millones de dólares y la correspondiente cantidad de energía.

Según el WSJ , hay al menos una docena de empresas emergentes de chips que compiten para vender a proveedores de computación en la nube chips de inferencia personalizados para el futuro.

|

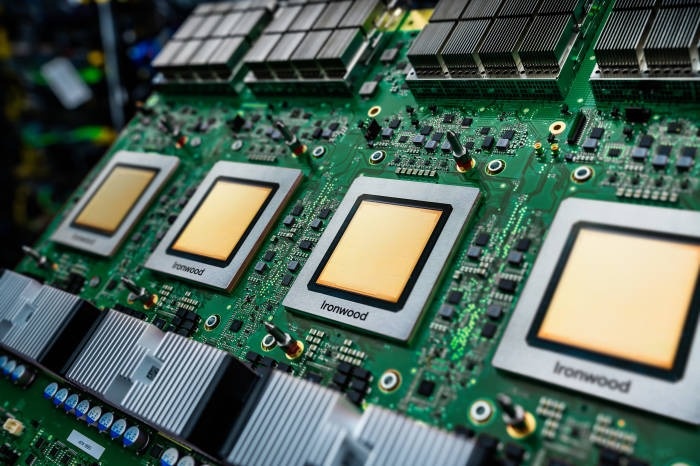

El chip Ironwood fue desarrollado por Google específicamente para tareas de inferencia. Foto: Google. |

Google, Amazon y Microsoft también están en el juego, construyendo chips centrados en la inferencia para potenciar sus propias herramientas de inteligencia artificial internas y venderlos a socios a través de servicios en la nube.

Para lograr sus objetivos, los fabricantes de nuevos chips de IA están utilizando una estrategia “clásica”: rediseñar los chips desde cero, específicamente para la nueva clase de tareas que de repente están adquiriendo importancia en la informática.

Esa era la fórmula de las tarjetas gráficas en el pasado, y así es como Nvidia construyó su éxito actual. Tomó tiempo adaptar los chips gráficos a la IA, pero la realidad es que nunca ha sido la solución perfecta.

"Embotellamiento"

Jonathan Ross, quien solía dirigir el programa de desarrollo de chips de IA de Google, dijo que fundó una startup llamada Groq porque creía que había una forma completamente diferente de diseñar chips, optimizada únicamente para ejecutar modelos de IA potentes.

Groq afirma que su chip también puede proporcionar potencia de IA mucho más rápido que el mejor chip de Nvidia y, fundamentalmente, con solo un tercio de la potencia.

Esto se debe a su diseño único, con memoria incorporada en el interior, en lugar de separada, y tiene sentido que la startup pueda ofrecer tareas de inferencia a un costo menor que los sistemas de Nvidia, según Jordan Nanos, analista de SemiAnalysis.

Mientras tanto, Positron está adoptando un enfoque diferente para ofrecer una inferencia más rápida. La startup, en colaboración con Cloudflare, ha creado un chip simplificado con un rango de capacidades más limitado, diseñado exclusivamente para realizar tareas con mayor rapidez.

Se espera que el sistema de próxima generación de Positron compita directamente con el chip de próxima generación de Nvidia, llamado Vera Rubin. Según la hoja de ruta de Nvidia, el chip de Positron será entre 2 y 3 veces más eficiente y ofrecerá entre 3 y 6 veces más potencia por unidad de entrada, según Mitesh Agrawal, director ejecutivo de Positron.

|

El chip de nueva generación de Positron se simplifica con un rango de capacidades más reducido, enfocado únicamente en realizar tareas con mayor rapidez. Foto: Positron. |

Es una verdad evidente en la historia de la informática que, siempre que los ingenieros de hardware descubren cómo hacer algo más rápido o de manera más eficiente, los programadores y los consumidores descubren cómo utilizar todas las nuevas mejoras en el rendimiento.

Mark Lohmeyer, vicepresidente de IA e infraestructura informática de Google Cloud, dijo que a medida que los consumidores y las empresas adoptan modelos de IA nuevos y más exigentes, significa que no importa cuánto más eficientemente pueda su equipo entregar IA, no hay fin para la demanda de esta.

Al igual que la mayoría de los principales proveedores de inteligencia artificial, Google está trabajando para encontrar formas nuevas y radicales de generar energía para alimentar sistemas, incluida la energía nuclear y de fusión.

Si bien los nuevos chips pueden ayudar a las empresas a implementar la IA de forma más eficiente, la industria en su conjunto sigue en camino de consumir cada vez más energía. Como señala un informe reciente de Anthropic, esto significa que la producción de energía, y no los centros de datos ni los chips, podría ser el verdadero obstáculo para el desarrollo futuro de la IA.

Fuente: https://znews.vn/chia-khoa-cho-van-de-cua-ai-post1572212.html

![[Foto] El Secretario General To Lam asiste al 80 aniversario de la diplomacia de Vietnam](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/25/3dc715efdbf74937b6fe8072bac5cb30)

Kommentar (0)