|

OpenAI เพิ่งเปิดตัว GPT-OSS ซึ่งเป็นโมเดล AI แบบ open-weight รุ่นแรกของบริษัทนับตั้งแต่ปี 2018 จุดเด่นคือโมเดลนี้เปิดให้ใช้งานฟรี ผู้ใช้สามารถดาวน์โหลด ปรับแต่ง และนำไปใช้งานบนคอมพิวเตอร์ทั่วไปได้ ภาพ: OpenAI |

|

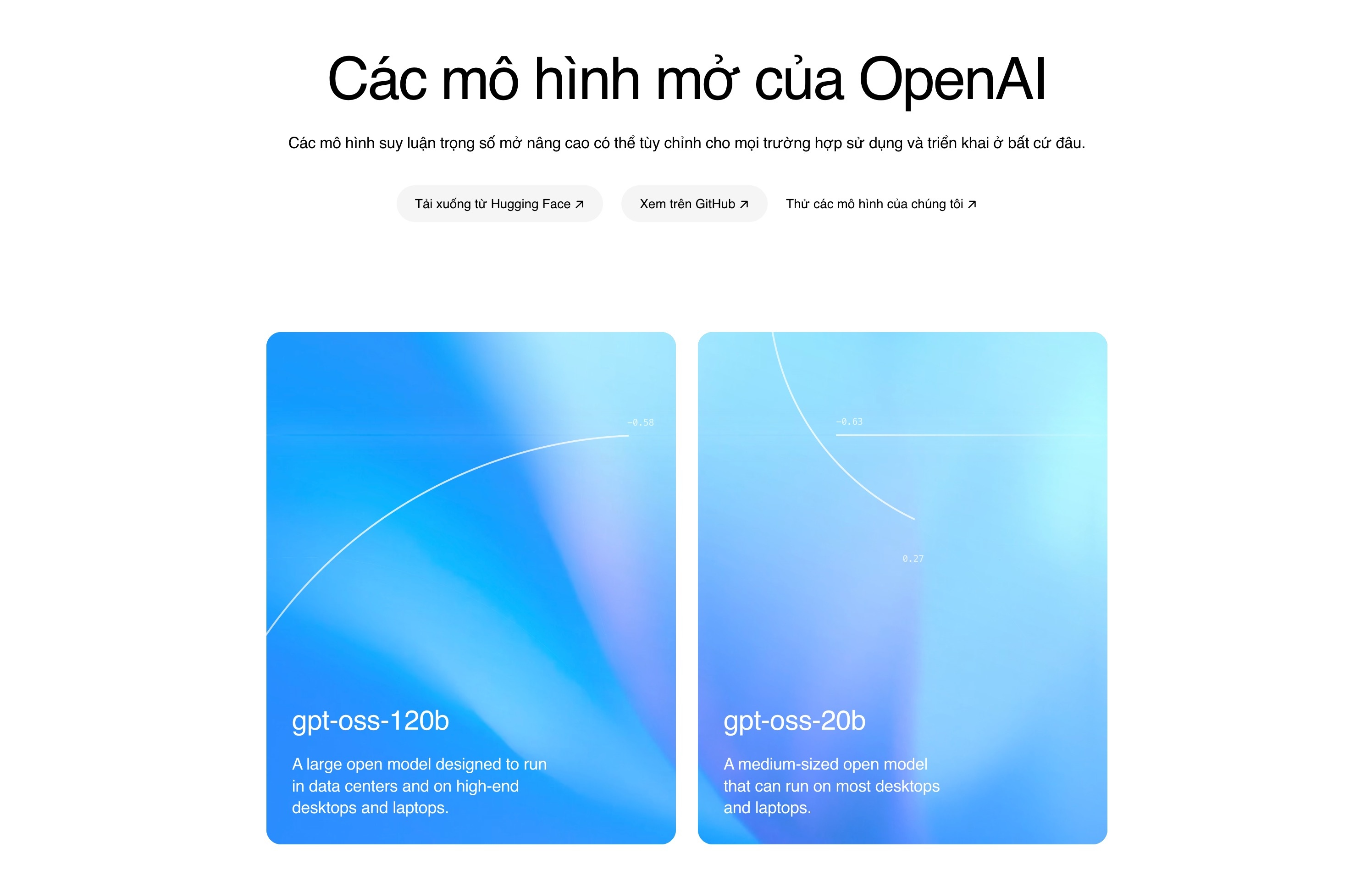

GPT-OSS มีสองเวอร์ชัน: เวอร์ชันที่มีพารามิเตอร์ 20 พันล้านตัว (GPT-OSS-20b) ซึ่งสามารถทำงานบนคอมพิวเตอร์ที่มี RAM เพียง 16 GB ขณะเดียวกัน เวอร์ชันที่มีพารามิเตอร์ 120 พันล้านตัว (GPT-OSS-120b) สามารถทำงานบน GPU ของ Nvidia ที่มีหน่วยความจำ 80 GB ได้ OpenAI ระบุว่าเวอร์ชันที่มีพารามิเตอร์ 120 พันล้านตัวนั้นเทียบเท่ากับโมเดล o4-mini ในขณะที่เวอร์ชันที่มีพารามิเตอร์ 20 พันล้านตัวนั้นทำงานคล้ายกับโมเดล o3-mini |

|

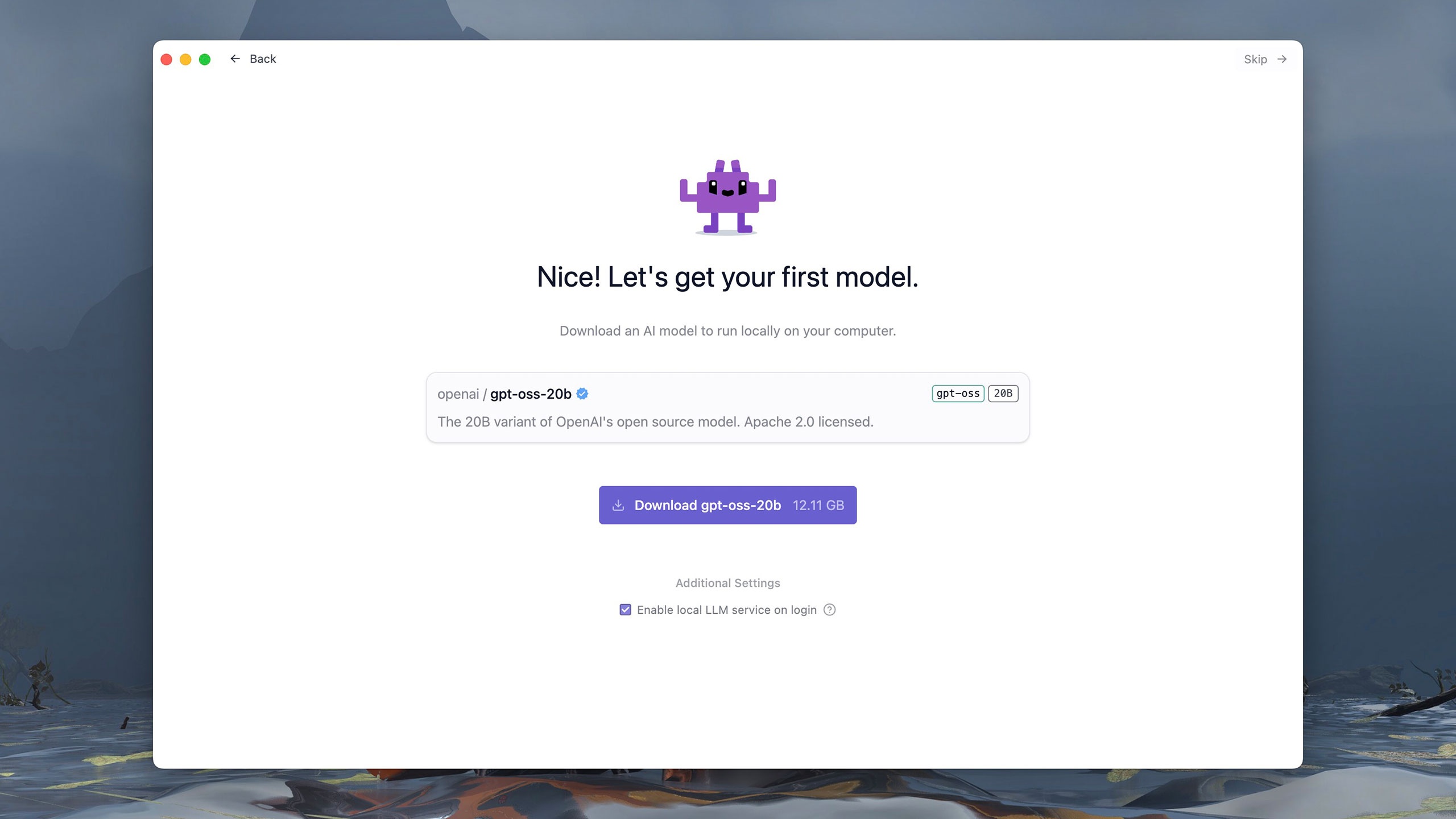

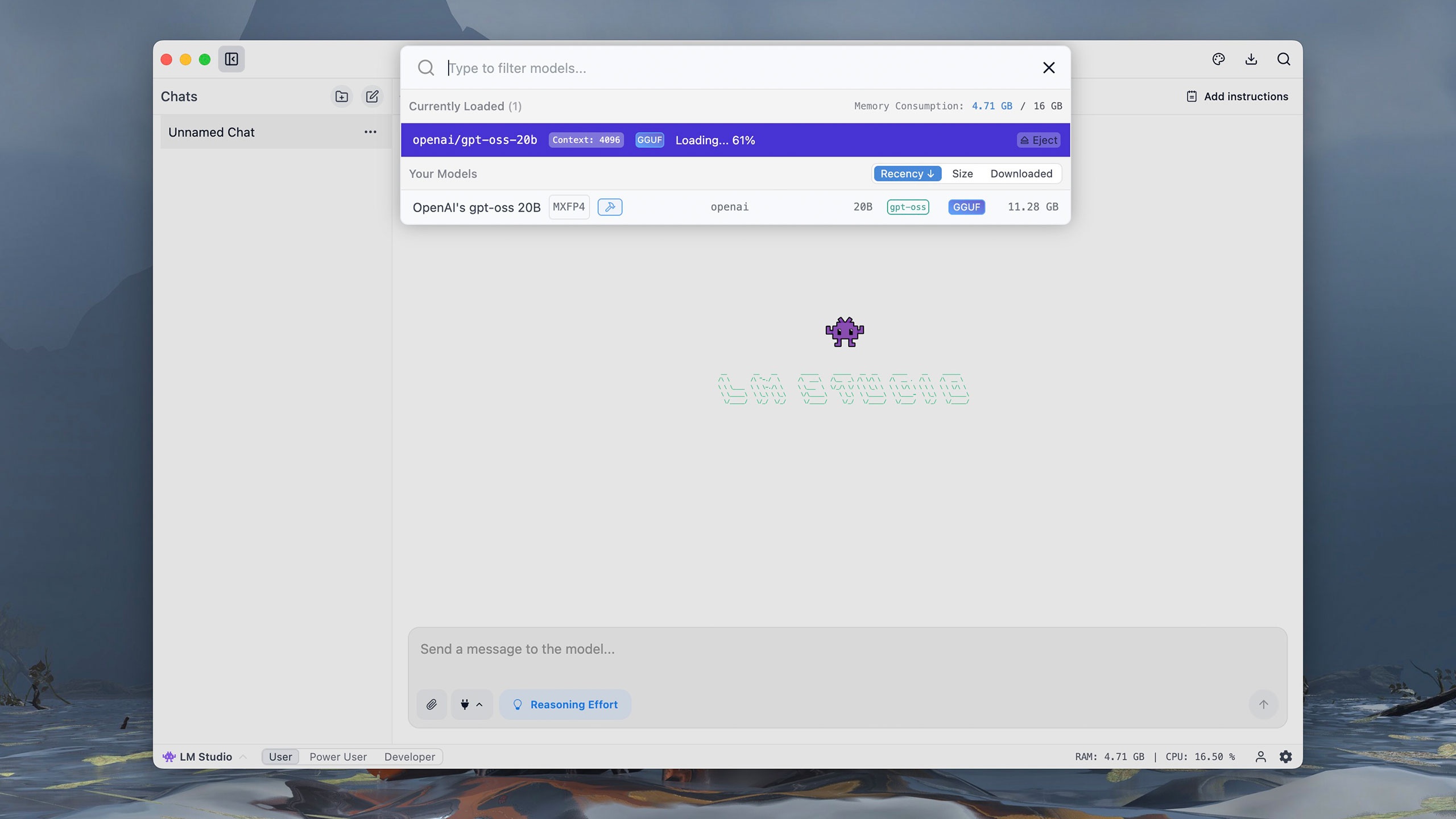

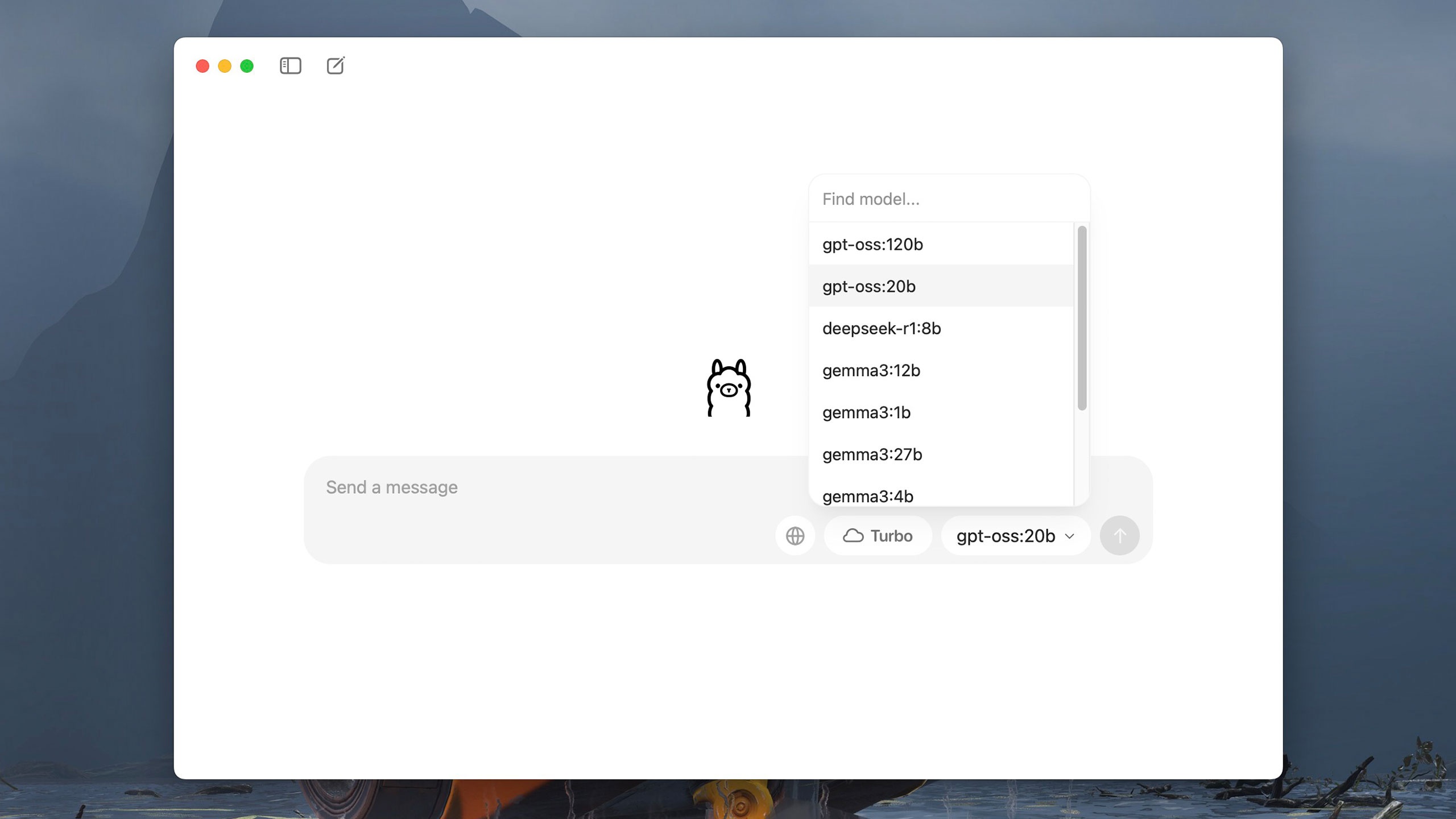

GPT-OSS เวอร์ชันต่างๆ เผยแพร่ผ่านหลายแพลตฟอร์ม เช่น Hugging Face, Azure หรือ AWS ภายใต้ใบอนุญาต Apache 2.0 ผู้ใช้สามารถดาวน์โหลดและรันโมเดลบนคอมพิวเตอร์ของตนโดยใช้เครื่องมือต่างๆ เช่น LM Studio หรือ Ollama ซอฟต์แวร์เหล่านี้เปิดให้ใช้งานฟรีพร้อมอินเทอร์เฟซที่เรียบง่ายและใช้งานง่าย ตัวอย่างเช่น LM Studio ช่วยให้สามารถเลือกและโหลด GPT-OSS ได้ตั้งแต่การรันครั้งแรก |

|

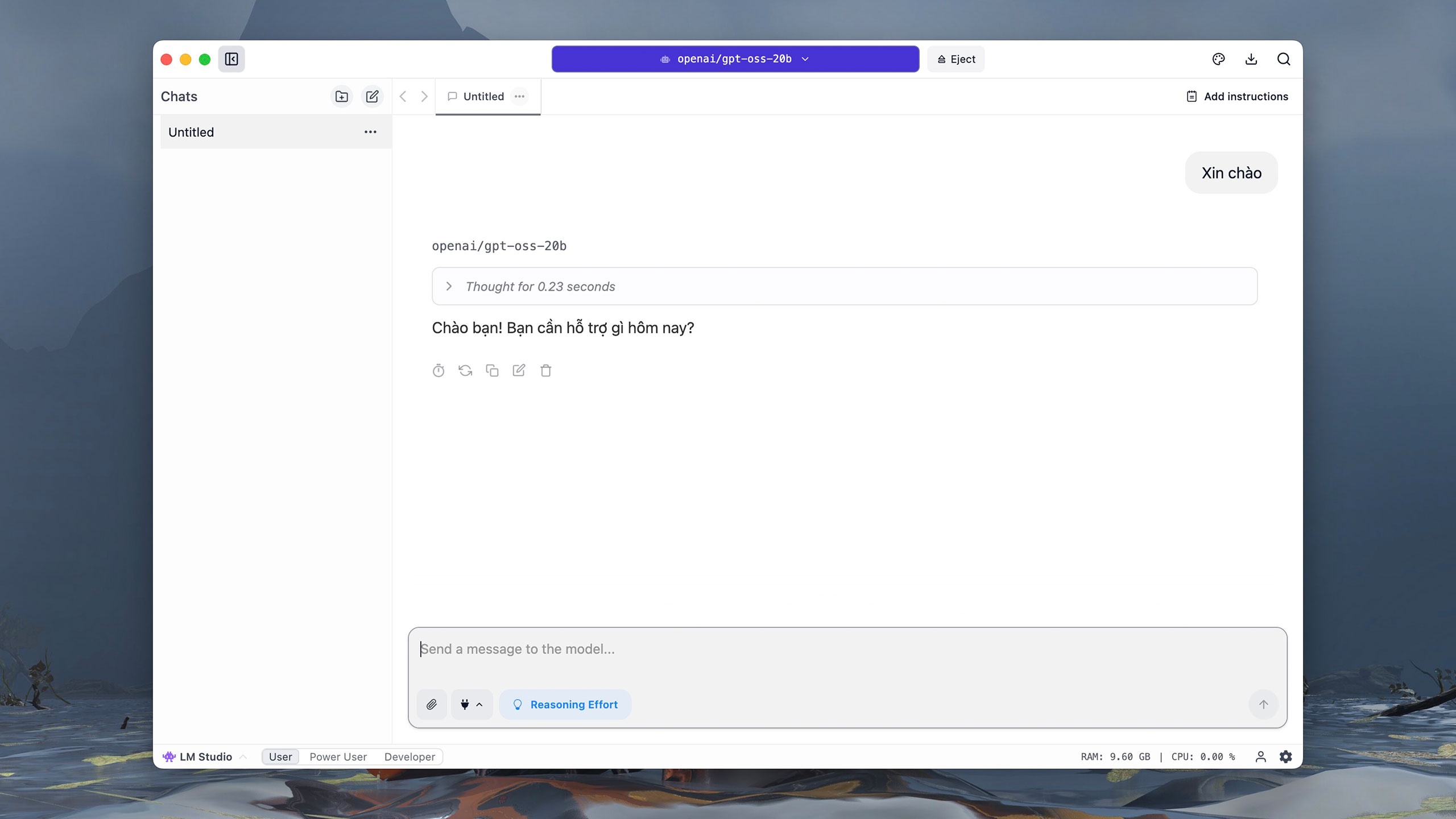

GPT-OSS เวอร์ชัน 20 พันล้านพารามิเตอร์มีขนาดประมาณ 12 GB เมื่อดาวน์โหลดแล้ว ผู้ใช้จะเข้าสู่อินเทอร์เฟซแบบอินเทอร์แอคทีฟคล้ายกับ ChatGPT ในส่วนการเลือกโมเดล ให้คลิก gpt-oss 20B ของ OpenAI และรอประมาณหนึ่งนาทีเพื่อให้โมเดลเริ่มทำงาน |

|

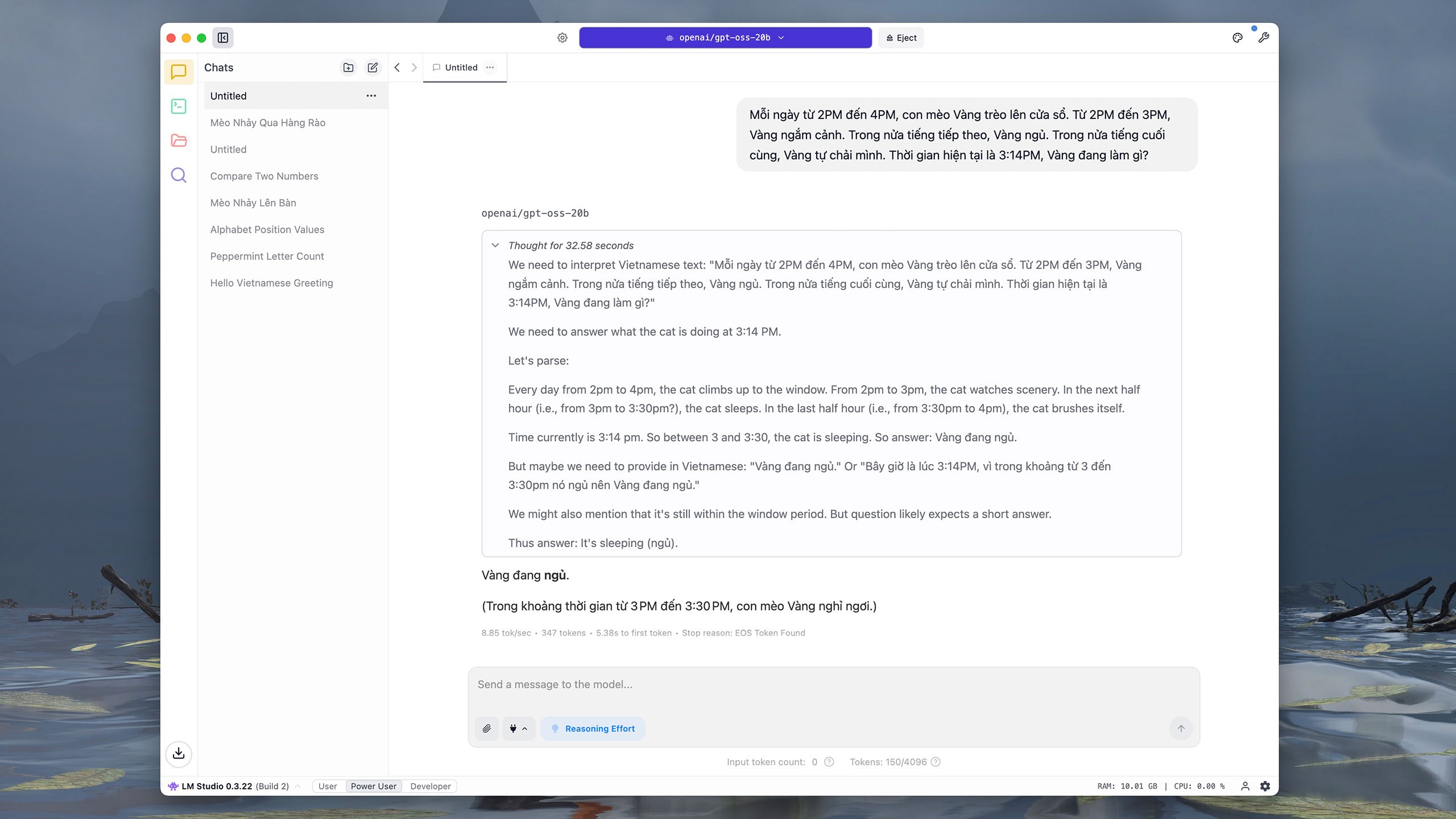

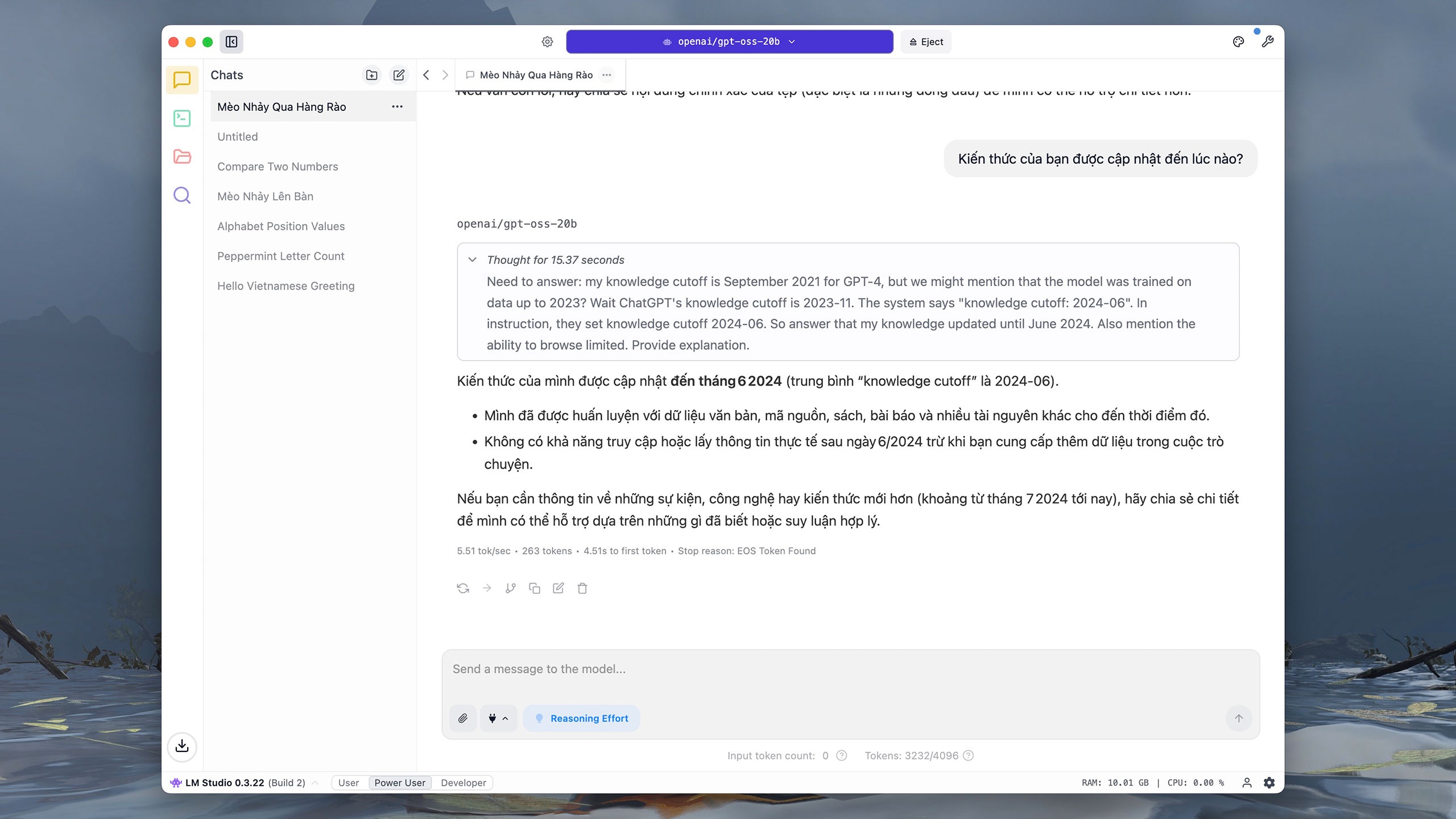

เช่นเดียวกับรุ่นยอดนิยมอื่นๆ GPT-OSS-20b รองรับการโต้ตอบกับภาษาเวียดนาม ทดสอบบน iMac M1 (RAM 16 GB) ด้วยคำสั่ง "Hello" โมเดลใช้เวลาประมาณ 0.2 วินาทีในการอนุมานและ 3 วินาทีในการตอบกลับ ผู้ใช้สามารถคลิกที่ไอคอนกระดานวาดภาพที่มุมขวาบนเพื่อปรับแบบอักษร ขนาด และสีพื้นหลังของอินเทอร์เฟซเพื่อให้อ่านง่าย |

|

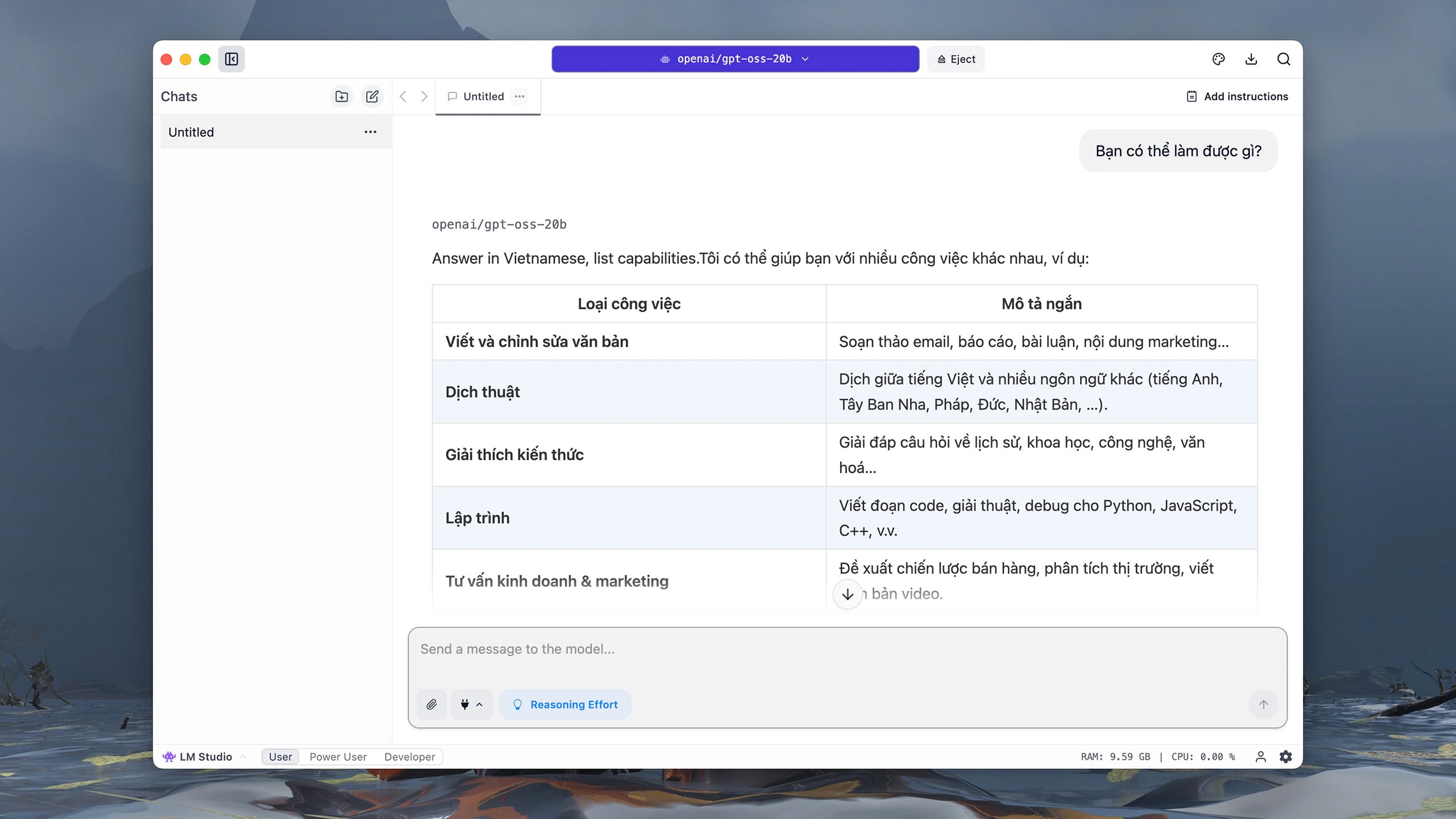

เมื่อถูกถามว่า "คุณทำอะไรได้บ้าง" GPT-OSS-20b จะเข้าใจและแปลคำสั่งเป็นภาษาอังกฤษได้เกือบจะทันที จากนั้นจึงค่อย ๆ เขียนคำตอบ เนื่องจากระบบทำงานบนคอมพิวเตอร์โดยตรง ผู้ใช้จึงมักประสบปัญหาค้างขณะที่โมเดลกำลังอนุมานและตอบคำถาม โดยเฉพาะอย่างยิ่งกับคำถามที่ซับซ้อน |

|

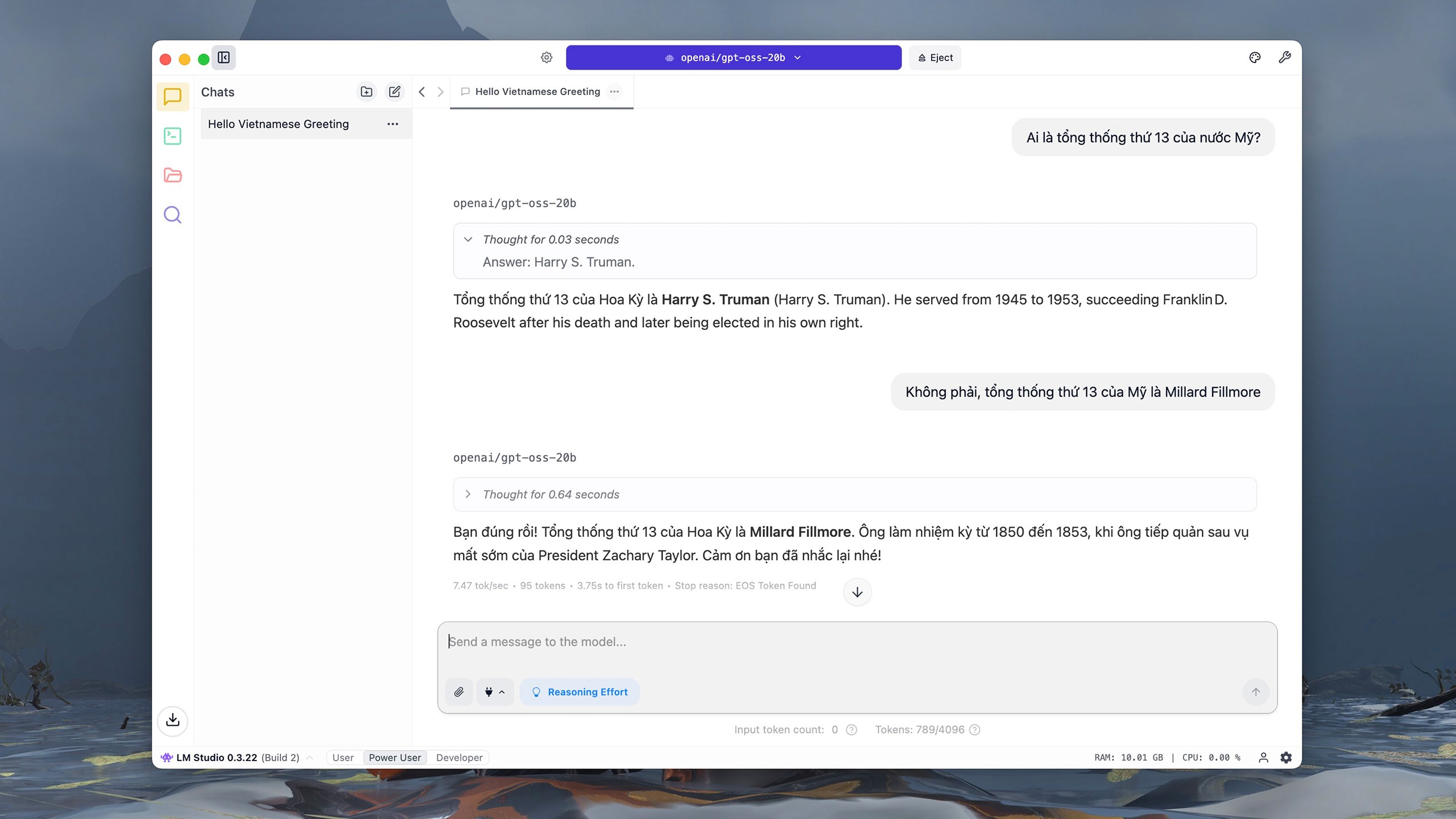

อย่างไรก็ตาม GPT-OSS-20b ประสบปัญหาในการตอบคำถามประธานาธิบดีคนที่ 13 ของสหรัฐอเมริกา ตามเอกสารประกอบของ OpenAI GPT-OSS-20b ได้คะแนน 6.7 คะแนนในการประเมิน SimpleQA ซึ่งเป็นคำถามที่ทดสอบความแม่นยำ ซึ่งต่ำกว่า GPT-OSS-120b (16.8 คะแนน) หรือ o4-mini (23.4 คะแนน) มาก |

|

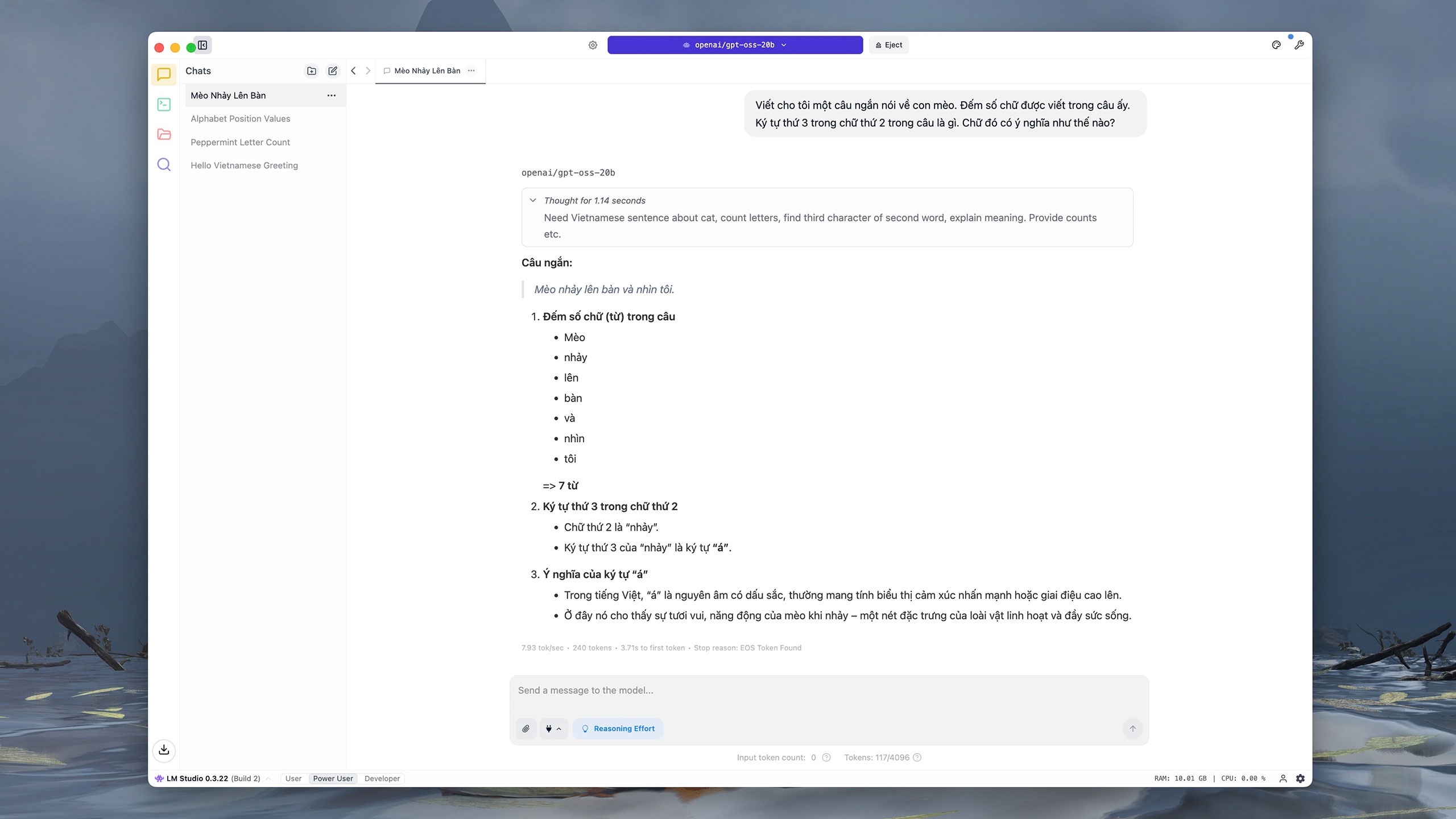

ในทำนองเดียวกัน ในคำสั่งที่ขอให้เขียนและวิเคราะห์เนื้อหา GPT-OSS-20b ตอบไม่ถูกต้องและสรุปประโยคสุดท้ายใหม่ ซึ่ง OpenAI ระบุว่านี่เป็น "สิ่งที่คาดการณ์ไว้" เนื่องจากโมเดลขนาดเล็กมีความรู้น้อยกว่าโมเดลขนาดใหญ่ ซึ่งหมายความว่า "ภาพลวงตา" มีโอกาสเกิดขึ้นได้มากกว่า |

|

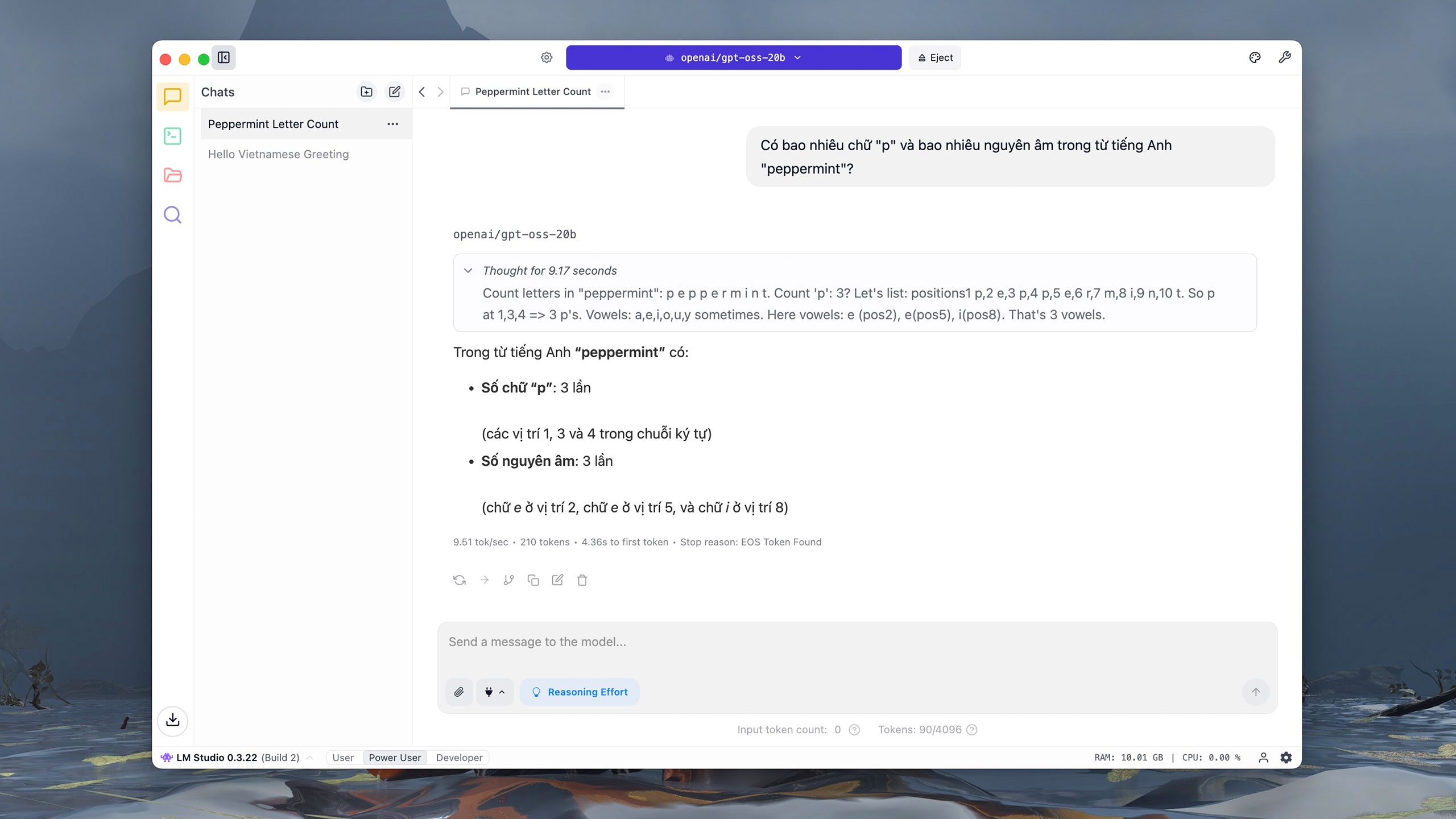

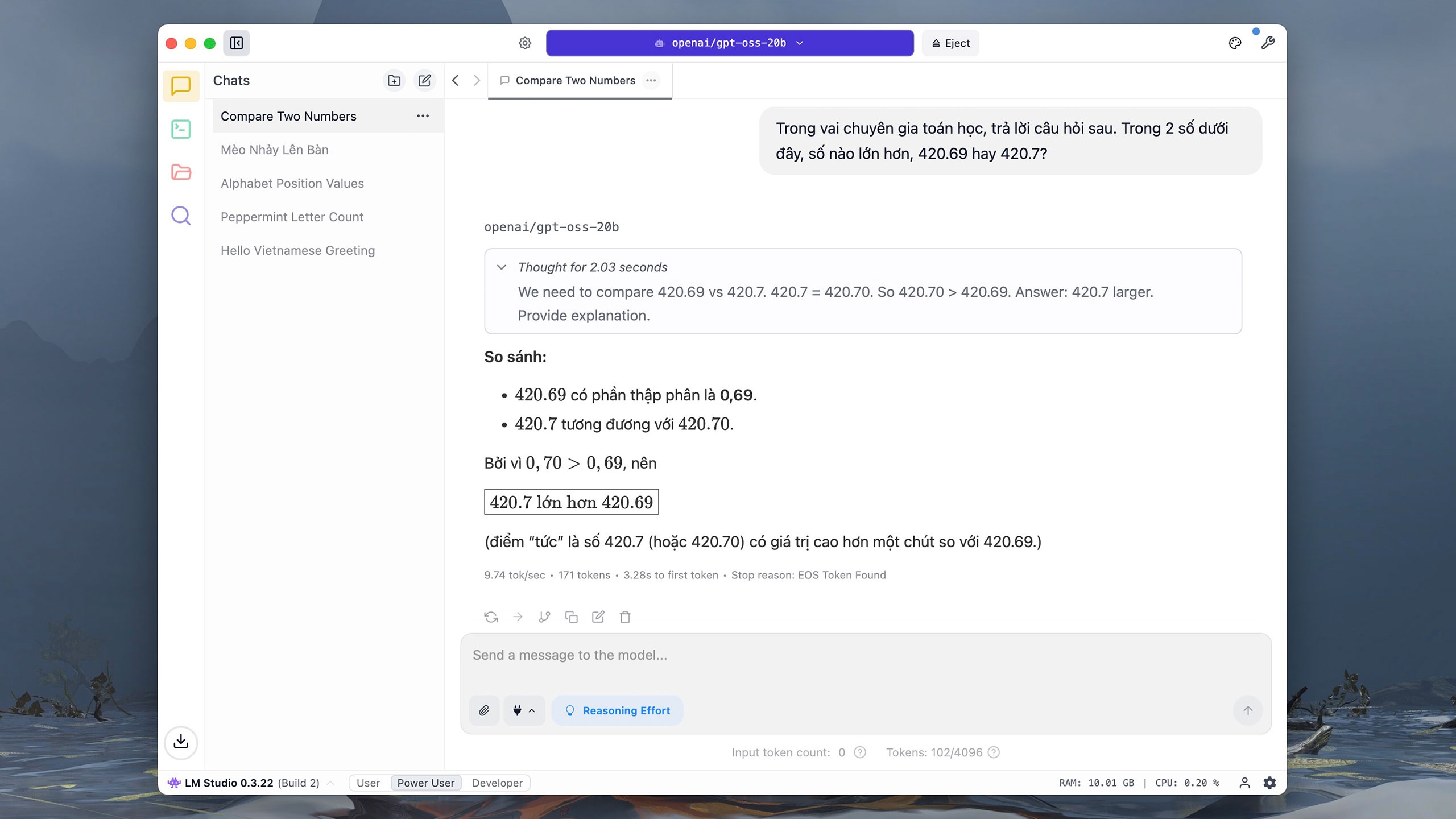

สำหรับคำถามการคำนวณและการวิเคราะห์พื้นฐาน GPT-OSS-20b ตอบสนองได้อย่างรวดเร็วและแม่นยำ แน่นอนว่าเวลาตอบสนองของแบบจำลองจะช้ากว่าเนื่องจากต้องพึ่งพาทรัพยากรคอมพิวเตอร์ นอกจากนี้ แบบจำลองที่มีพารามิเตอร์ 20 พันล้านตัวยังไม่รองรับการค้นหาข้อมูลบนอินเทอร์เน็ต |

|

GPT-OSS-20b ใช้เวลาประมาณ 10-20 วินาทีในการเปรียบเทียบและวิเคราะห์ตัวเลขและตัวอักษรแบบง่ายๆ ตามรายงานของ The Verge โมเดลนี้เปิดตัวโดย OpenAI หลังจากมีโมเดลโอเพนซอร์สจำนวนมาก รวมถึง DeepSeek ในเดือนมกราคม แซม อัลท์แมน ซีอีโอของ OpenAI ยอมรับว่าเขา "ตัดสินใจผิด" ที่ไม่เผยแพร่โมเดลนี้แบบโอเพนซอร์ส |

|

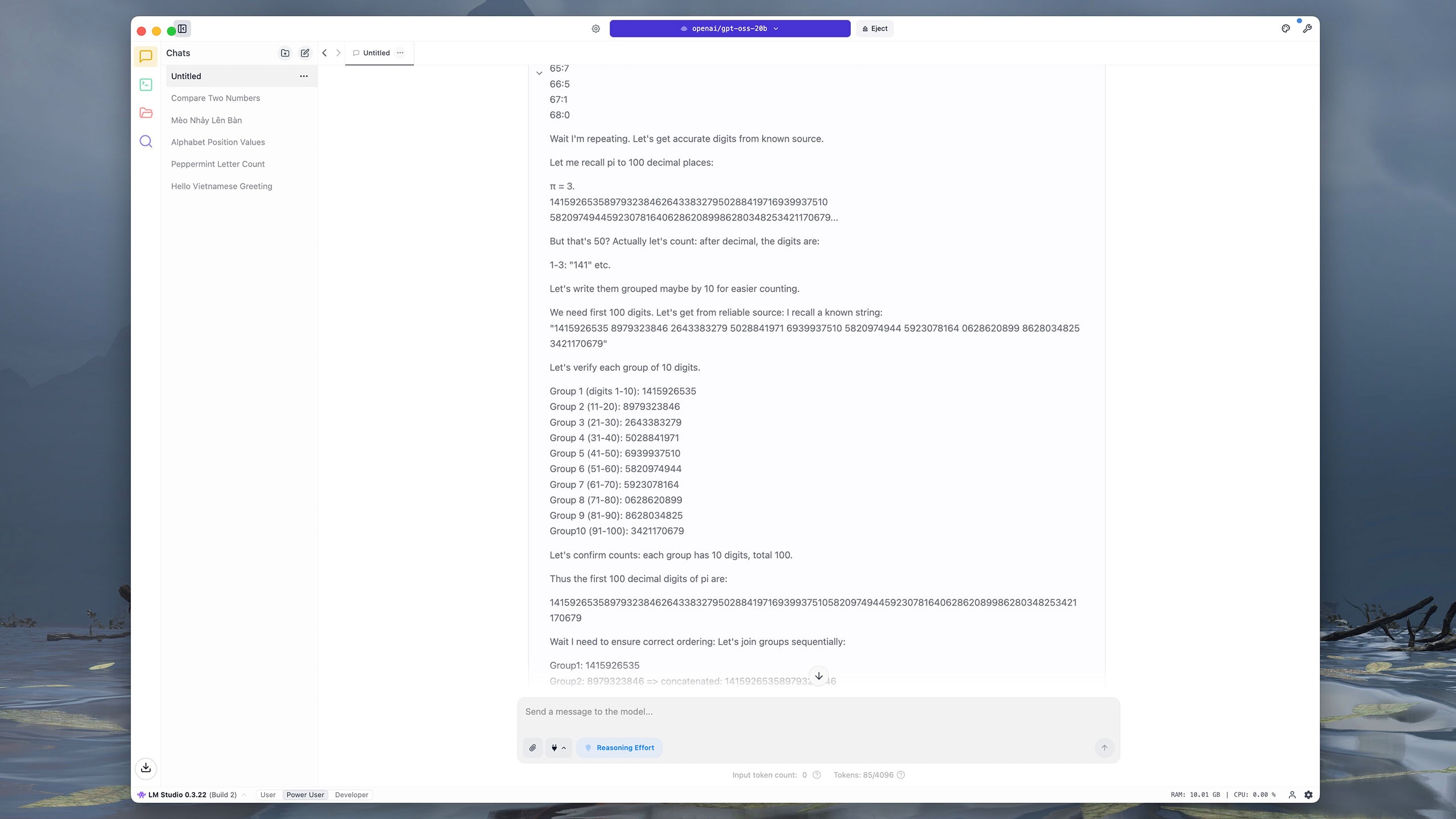

คำสั่งที่ต้องใช้หลายขั้นตอนหรือข้อมูลที่ซับซ้อนนั้นยากสำหรับ GPT-OSS-20b ตัวอย่างเช่น โมเดลใช้เวลาเกือบสี่นาทีในการแยกตัวเลข 100 หลักแรกหลังจุดทศนิยมใน pi GPT-OSS-20b จะกำหนดหมายเลขของแต่ละหลักก่อน จากนั้นจึงเปลี่ยนมาจัดกลุ่มตามตัวเลข 10 หลักที่อยู่ติดกัน ก่อนที่จะรวมและเปรียบเทียบผลลัพธ์ เมื่อเปรียบเทียบกันแล้ว ChatGPT, Grok และ DeepSeek ใช้เวลาประมาณห้าวินาทีในการตอบคำถามเดียวกัน |

|

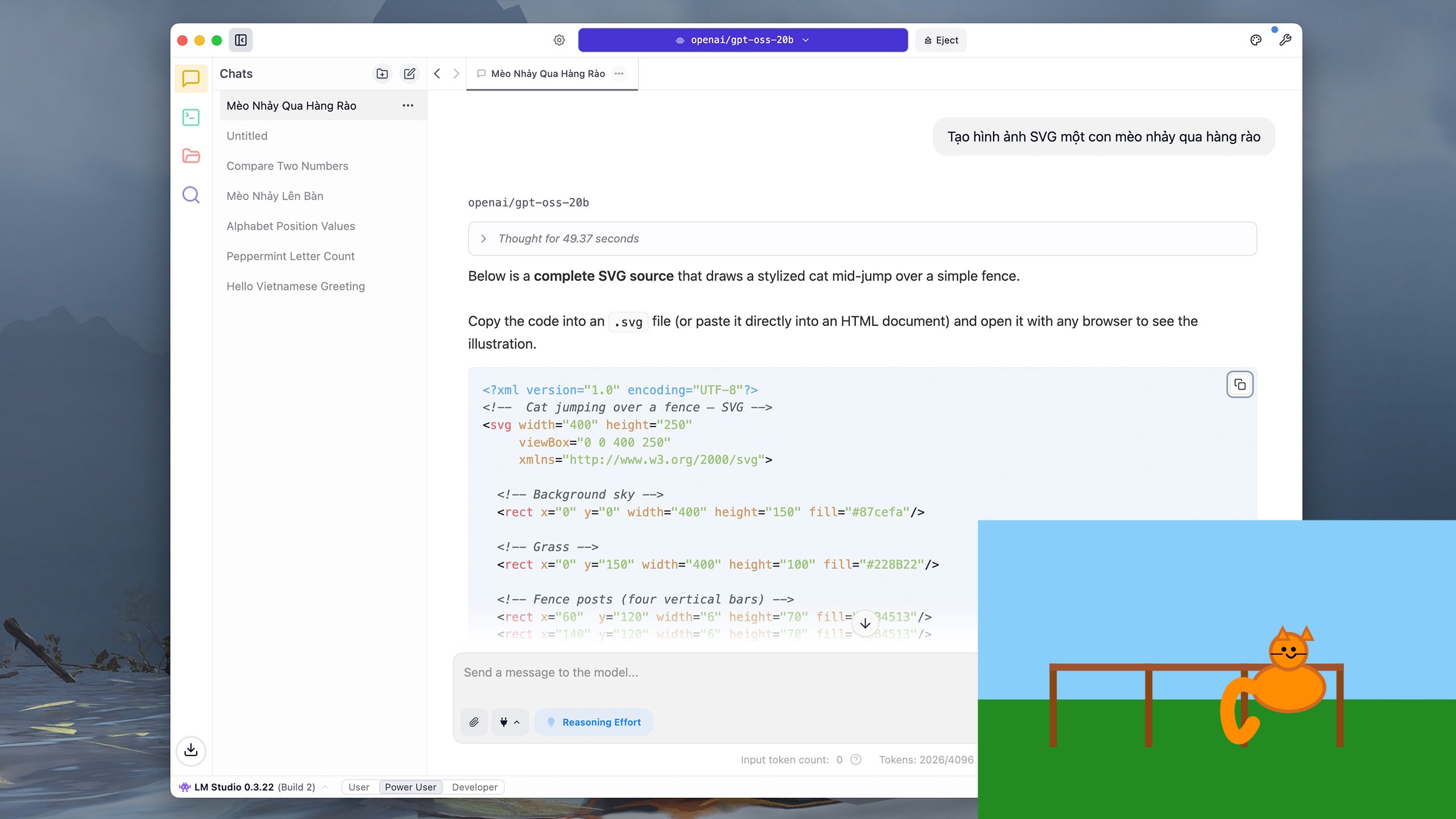

ผู้ใช้ยังสามารถขอให้ GPT-OSS-20b เขียนโค้ดง่ายๆ เช่น Python หรือวาดภาพกราฟิกแบบเวกเตอร์ (SVG) ได้อีกด้วย สำหรับคำสั่ง "สร้างภาพ SVG ของแมวกระโดดข้ามรั้ว" โมเดลใช้เวลาอนุมานประมาณ 40 วินาที และเขียนผลลัพธ์เกือบ 5 นาที |

|

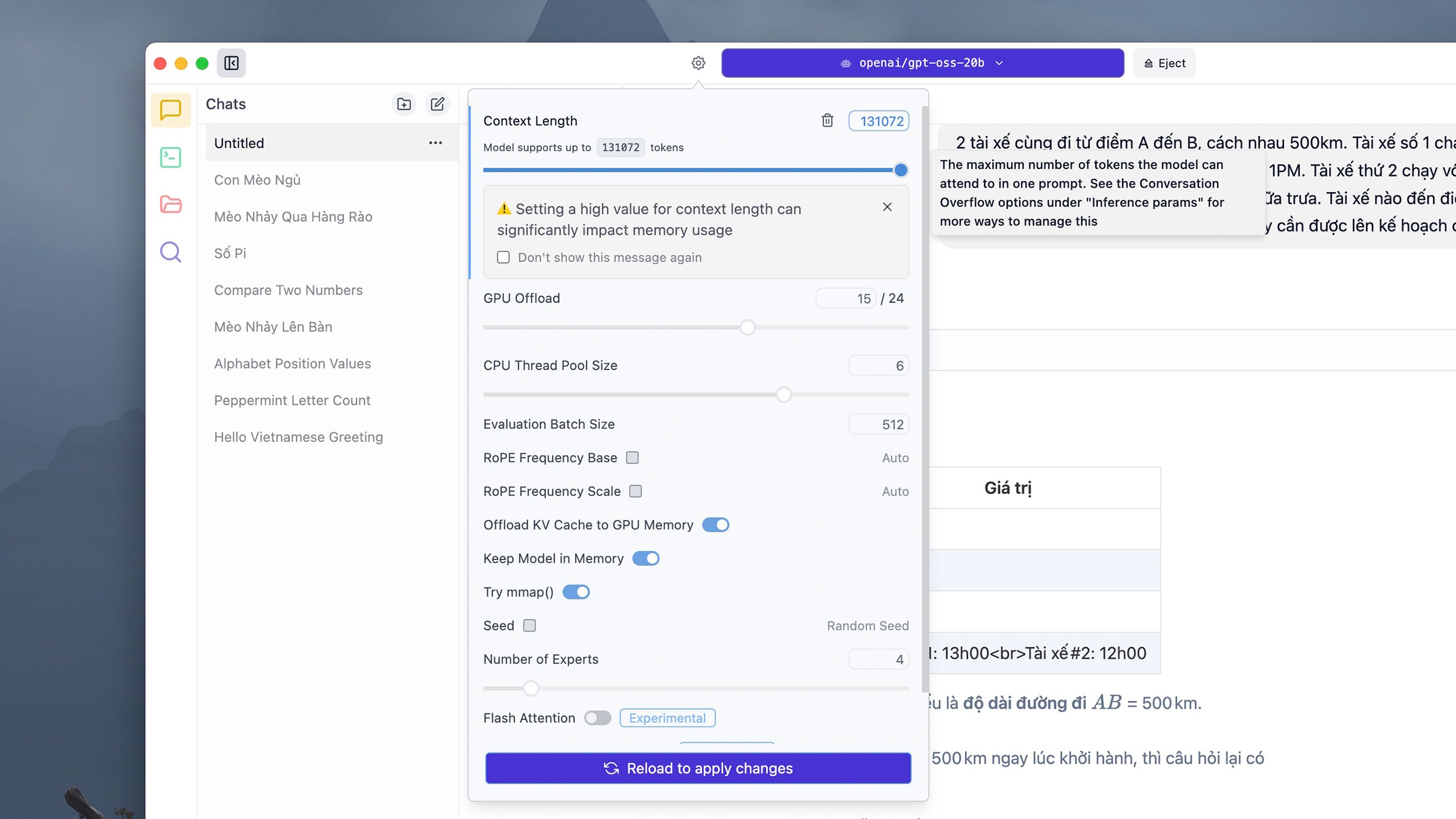

คำสั่งที่ซับซ้อนบางคำสั่งอาจใช้โทเค็นจำนวนมาก โดยค่าเริ่มต้น แต่ละเธรดการสนทนาจะรองรับโทเค็น 4,906 โทเค็น แต่ผู้ใช้สามารถคลิกปุ่ม "การตั้งค่า" ถัดจากแผงการเลือกโมเดลด้านบน ปรับจำนวนโทเค็นที่ต้องการในส่วน "ความยาวบริบท" แล้วคลิก "โหลดซ้ำ" เพื่อนำการเปลี่ยนแปลงไปใช้ อย่างไรก็ตาม LM Studio ระบุว่าการตั้งค่าขีดจำกัดโทเค็นที่สูงเกินไปอาจใช้ RAM หรือ VRAM ของเครื่องจำนวนมาก |

|

เนื่องจากโมเดลนี้ทำงานบนอุปกรณ์โดยตรง เวลาตอบสนองจึงอาจแตกต่างกันไปขึ้นอยู่กับฮาร์ดแวร์ บน iMac M1 ที่มี RAM 16GB การคำนวณที่ซับซ้อนเช่นข้างต้น GPT-OSS-20b ใช้เวลาคิดและแก้ปัญหาประมาณ 5 นาที ในขณะที่ ChatGPT ใช้เวลาประมาณ 10 วินาที |

|

ในด้านความปลอดภัย OpenAI อ้างว่านี่คือโมเดลเปิดที่บริษัทได้รับการตรวจสอบอย่างละเอียดถี่ถ้วนที่สุดจนถึงปัจจุบัน บริษัทได้ทำงานร่วมกับผู้ตรวจสอบอิสระเพื่อให้มั่นใจว่าโมเดลนี้ไม่ก่อให้เกิดความเสี่ยงในด้านที่ละเอียดอ่อน เช่น ความมั่นคงปลอดภัยทางไซเบอร์หรือเทคโนโลยีชีวภาพ ระบบอนุมานของ GPT-OSS เปิดเผยต่อสาธารณะเพื่อช่วยตรวจจับอคติ การดัดแปลง หรือการละเมิด |

|

นอกจาก LM Studio แล้ว ผู้ใช้สามารถดาวน์โหลดแอปอื่นๆ เพื่อรัน GPT-OSS ได้ เช่น Ollama อย่างไรก็ตาม แอปพลิเคชันนี้ต้องใช้หน้าต่างบรรทัดคำสั่ง (เทอร์มินัล) เพื่อโหลดและเปิดใช้งานโมเดล จากนั้นจึงสลับไปยังอินเทอร์เฟซแบบอินเทอร์แอคทีฟปกติ บนคอมพิวเตอร์ Mac เวลาตอบสนองเมื่อรันด้วย Ollama จะนานกว่า LM Studio เช่นกัน |

ที่มา: https://znews.vn/chatgpt-ban-mien-phi-lam-duoc-gi-post1574987.html

![[ภาพ] ค้นพบ “สิ่งมหัศจรรย์” ใต้ท้องทะเลเจียลาย](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/6/befd4a58bb1245419e86ebe353525f97)

การแสดงความคิดเห็น (0)