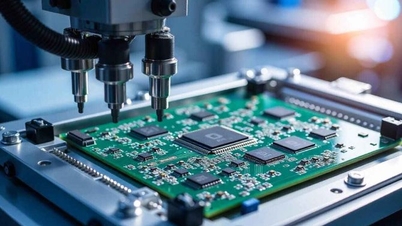

Αυστραλοί επιστήμονες ανέπτυξαν μια νέα τεχνική που θα μπορούσε να αποτρέψει τα συστήματα Τεχνητής Νοημοσύνης (AI) από το να μαθαίνουν παράνομα από εικόνες, έργα τέχνης και άλλο διαδικτυακό περιεχόμενο.

Σύμφωνα με την εθνική επιστημονική υπηρεσία της Αυστραλίας (CSIRO), η τεχνική αυτή τροποποιεί διακριτικά το περιεχόμενο των εικόνων, καθιστώντας τες μη αναγνώσιμες από τα μοντέλα τεχνητής νοημοσύνης, ενώ παραμένει αναλλοίωτη στο ανθρώπινο μάτι. Πρόκειται για ένα έργο που αναπτύχθηκε από το CSIRO, σε συνεργασία με το Κέντρο Συνεργατικής Έρευνας Κυβερνοασφάλειας (CSCRC) της Αυστραλίας και το Πανεπιστήμιο του Σικάγο (ΗΠΑ).

Οι συγγραφείς λένε ότι η ανακάλυψη αυτή θα μπορούσε να βοηθήσει καλλιτέχνες, οργανισμούς και χρήστες μέσων κοινωνικής δικτύωσης να προστατεύσουν το έργο και τα προσωπικά τους δεδομένα από τη χρήση για την εκπαίδευση συστημάτων τεχνητής νοημοσύνης ή τη δημιουργία deepfakes — απίστευτα ρεαλιστικών βίντεο , εικόνων ή ήχου που δημιουργούνται από την τεχνητή νοημοσύνη. Για παράδειγμα, οι χρήστες θα μπορούσαν να εφαρμόσουν αυτόματα ένα προστατευτικό στρώμα στις εικόνες πριν από την ανάρτηση, εμποδίζοντας την τεχνητή νοημοσύνη να μάθει χαρακτηριστικά του προσώπου για να δημιουργήσει deepfakes.

Ομοίως, οι αμυντικοί οργανισμοί ενδέχεται να προστατεύουν ευαίσθητες δορυφορικές εικόνες ή δεδομένα σχετικά με κυβερνοαπειλές.

Σύμφωνα με τον Δρ. Derui Wang, επιστήμονα στο CSIRO, αυτή η μέθοδος χρησιμοποιεί μια ισχυρή μαθηματική βάση για να διασφαλίσει ότι τα μοντέλα Τεχνητής Νοημοσύνης δεν μπορούν να μάθουν από αυτό το περιεχόμενο ή, με άλλα λόγια, αυτή η τεχνική καθιστά τα δεδομένα «μη εκμάθησιμα» για την Τεχνητή Νοημοσύνη σε επίπεδο που προστατεύει την ιδιωτικότητα και τα πνευματικά δικαιώματα, διατηρώντας παράλληλα τη χρησιμότητά τους για τον άνθρωπο.

Αυτή η προστασία παραμένει σε ισχύ ακόμη και αν η Τεχνητή Νοημοσύνη προσπαθήσει να προσαρμοστεί ή επανεκπαιδευτεί, πρόσθεσε.

Ο Δρ. Wang είπε ότι η τεχνική θα μπορούσε να εφαρμοστεί αυτόματα σε μεγάλη κλίμακα. Είπε ότι μια πλατφόρμα ή ιστότοπος κοινωνικής δικτύωσης θα μπορούσε να ενσωματώσει αυτό το προστατευτικό στρώμα σε όλες τις εικόνες που ανεβαίνουν. Αυτό θα μπορούσε να περιορίσει τον πολλαπλασιασμό των deepfakes, να μειώσει την κλοπή πνευματικής ιδιοκτησίας και να βοηθήσει τους χρήστες να διατηρήσουν τον έλεγχο του περιεχομένου τους.

Ενώ η μέθοδος εφαρμόζεται προς το παρόν μόνο σε εικόνες, οι ερευνητές σχεδιάζουν να την επεκτείνουν σε κείμενο, μουσική και βίντεο. Η τεχνολογία βρίσκεται ακόμη σε θεωρητικό στάδιο και έχει αποδειχθεί ότι λειτουργεί αποτελεσματικά μόνο σε εργαστηριακό περιβάλλον.

Η παραπάνω επιστημονική εργασία, με τίτλο «Παραδείγματα Δεδομένων που δεν μπορούν να μάθουν εύκολα», βραβεύτηκε με το Βραβείο Εξαιρετικής Έρευνας στο Συμπόσιο Ασφάλειας Δικτύων και Κατανεμημένων Συστημάτων (NDSS) του 2025./.

Πηγή: https://www.vietnamplus.vn/ky-thuat-moi-giup-ngan-chan-ai-hoc-hoi-tu-du-lieu-khong-duoc-phep-post1055216.vnp

![[Φωτογραφία] Ο Πρόεδρος Luong Cuong παραθέτει κρατική δεξίωση για τον Γενικό Κυβερνήτη της Αυστραλίας](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/10/a00546a3d7364bbc81ee51aae9ef8383)

![[Φωτογραφία] Ο Πρωθυπουργός Φαμ Μινχ Τσινχ προεδρεύει της 20ής συνεδρίασης της Συντονιστικής Επιτροπής για σημαντικά εθνικά έργα και έργα](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/10/e82d71fd36eb4bcd8529c8828d64f17c)

![[Φωτογραφία] Γιγάντιος αγωγός που οδηγεί νερό στη Δυτική Λίμνη, συμβάλλοντας στην αναζωογόνηση του ποταμού To Lich](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/10/887e1aab2cc643a0b2ef2ffac7cb00b4)

Σχόλιο (0)