أصدرت إدارة أمن المعلومات مؤخرًا تحذيرًا بشأن استمرار تكرار عمليات الاحتيال باستخدام مقاطع الفيديو والصور عالية التقنية.

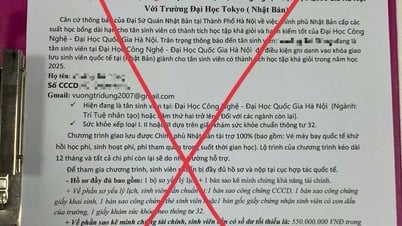

وبناء على ذلك، حذرت السلطات العامة على نطاق واسع من قيام مجرمي الإنترنت باستغلال الصور ومقاطع الفيديو العامة للأشخاص لتحريرها وتقطيعها وتهديدهم بالابتزاز بمقاطع فيديو مزيفة.

وباستخدام تقنية Deepfake التي تسمح بإعادة إنتاج صوت وصورة الشخص بدقة عالية، يمكن للمجرمين انتحال شخصية القادة في الاجتماعات عبر الإنترنت، أو إنشاء مقاطع فيديو ومكالمات لارتكاب الاحتيال المالي.

علاوة على ذلك، تستغل عمليات الاحتيال هذه في كثير من الأحيان العوامل النفسية مثل الإلحاح أو الخوف أو القوة، مما يدفع الضحايا إلى التصرف على عجل دون التحقق بعناية من صحة الأمر.

لا تقتصر عمليات التزييف العميق على عمليات الاحتيال في الاستثمارات المالية. ومن الأمثلة الأخرى عمليات الاحتيال العاطفية، حيث تُستخدم عمليات التزييف العميق لخلق شخصيات خيالية تتفاعل مع الضحايا عبر مكالمات الفيديو. بعد كسب ثقة الضحية، يطلب المحتال تحويلات مالية لحل حالات الطوارئ أو نفقات السفر أو القروض.

وفي ضوء الوضع المذكور أعلاه، توصي إدارة أمن المعلومات بأن يكون الناس حذرين من النصائح الاستثمارية التي يقدمها المشاهير على مواقع التواصل الاجتماعي؛ والحذر من الرسائل أو رسائل البريد الإلكتروني أو المكالمات المجهولة الهوية؛ ومراقبة تعبيرات الوجه غير الطبيعية في مقاطع الفيديو بعناية.

ويحتاج الأشخاص أيضًا إلى الحد من نشر المحتوى المتعلق بالمعلومات الشخصية على الشبكات الاجتماعية لتجنب سرقة المعلومات مثل الصور أو مقاطع الفيديو أو الأصوات من قبل الأشرار؛ وفي الوقت نفسه، تعيين الحسابات على الوضع الخاص لحماية المعلومات الشخصية.

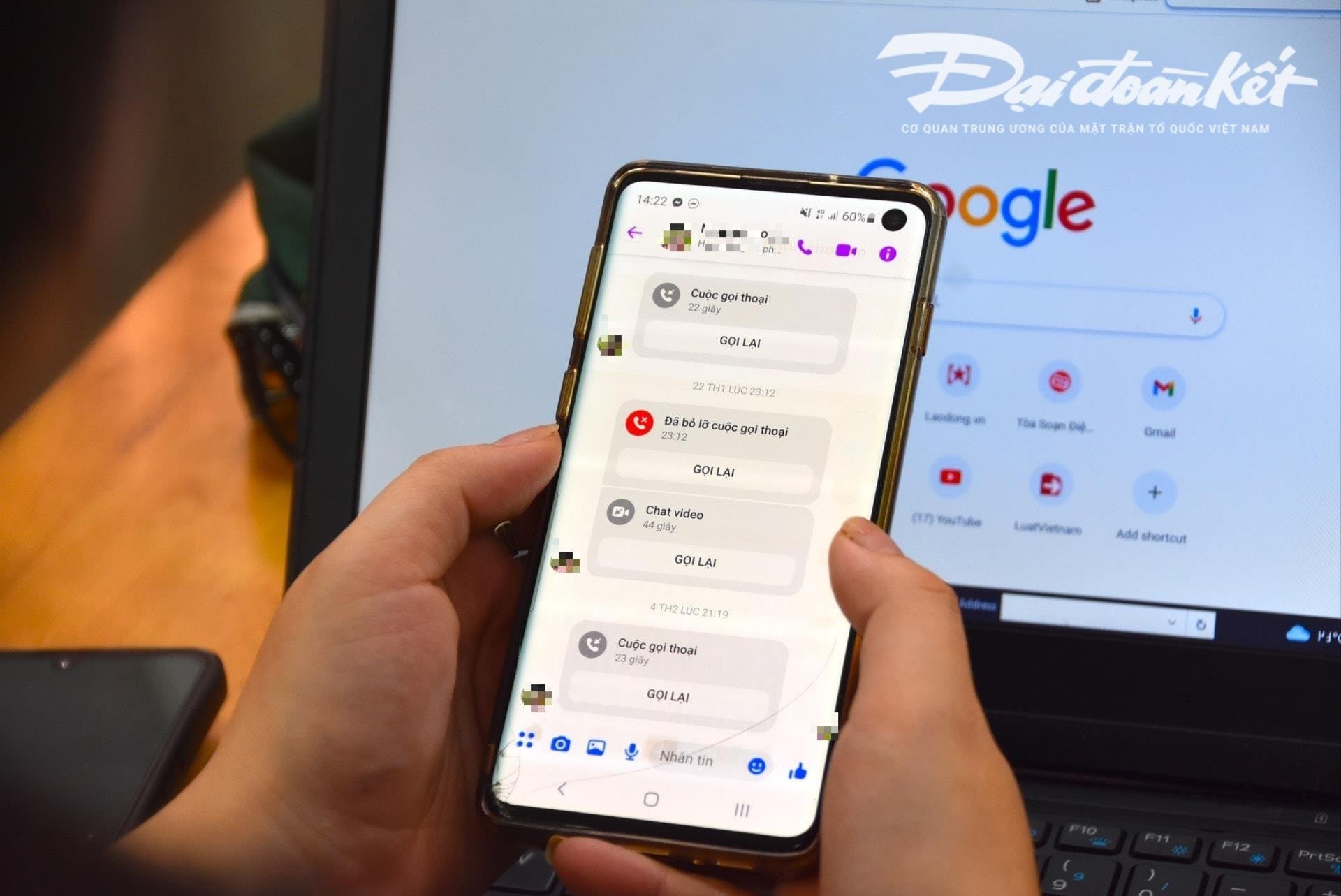

في حديثه لمراسلي صحيفة داي دوان كيت، قال خبير الأمن السيبراني نغو مينه هيو، المؤسس المشارك لمشروع فيتنام للوقاية من الاحتيال السيبراني (Chongluadao.vn)، إن استخدام تقنية التزييف العميق في الذكاء الاصطناعي لتزييف مكالمات الفيديو لأغراض الاحتيال لا يزال معقدًا. يستغل الضحايا هذه التقنية لتعزيز مصداقية "ضحيتهم".

على وجه التحديد، سيقوم الأشخاص بشكل استباقي بإجراء مكالمات فيديو مع الضحايا من صور ومقاطع فيديو "مسروقة" سابقًا ومعالجتها تقنيًا وتشويه الصوت أو مشاكل الصورة المزيفة لكسب ثقة الضحايا.

عادةً ما تكون هذه المكالمات قصيرة جدًا، وتستغرق بضع ثوانٍ فقط، ثم يستخدم المحتال عذر عدم استقرار الشبكة، أو التواجد في الشارع، وما إلى ذلك ليطلب من الضحية تلبية طلبات المحتال.

يحذر الخبراء من أن استخدام الذكاء الاصطناعي في الاحتيال الإلكتروني سيزداد بشكل ملحوظ في المستقبل القريب. لذلك، يجب على الناس رفع مستوى وعيهم بشكل استباقي، خاصةً عند تلقي رسائل غريبة، ومكالمات فيديو، وروابط.

وبحسب تحليل هذا الخبير، فإن خوارزمية الذكاء الاصطناعي الحالية Deepfake أثناء المكالمات في الوقت الفعلي لن تكون قادرة على التعامل معها إذا انعطف المتصل إلى اليسار أو اليمين أو وقف...

من نقاط الضعف التي يجب الانتباه إليها عند تلقي هذه المكالمات هي الأسنان. ولذلك، لا تستطيع خوارزميات الذكاء الاصطناعي الحالية إعادة إنتاج أسنان الشخص المُنتحل.

عند استخدام تقنية Deepfake، قد لا تحتوي صورة الشخص الذي يفتح فمه على أسنان، فبعض الأشخاص لديهم ثلاثة فكوك، أو حتى أربعة فكوك. لذا، تُعدّ سمة الأسنان العنصر الأبرز في المكالمات المزيفة باستخدام Deepfake.

يُعدّ "التريث" وعدم الاستجابة الفورية للطلب شرطًا أساسيًا لتجنب الوقوع في فخ الاحتيال. عند تلقي أي رسالة أو مكالمة عبر منصات التواصل الاجتماعي، يجب على الأشخاص الاتصال بأقاربهم مباشرةً للتحقق من هوية المتصل بدقة، وذلك خلال مدة لا تقل عن 30 ثانية، أو مقابلتهم شخصيًا.

في حالة الاشتباه في انتحال شخصية أحد الأقارب على مواقع التواصل الاجتماعي بهدف الاحتيال أو الاستيلاء على الممتلكات، فمن الضروري الإبلاغ فورًا إلى أقرب وكالة شرطة للحصول على الدعم والمعالجة في الوقت المناسب.

[إعلان 2]

المصدر: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

تعليق (0)