CEO Truepic, Jeffrey McGregor, mengatakan insiden ini hanyalah puncak dari "gunung es". McGregor mengatakan akan ada lebih banyak konten yang dihasilkan AI di media sosial, dan kita belum siap untuk itu.

Menurut CNN, Truepic ingin mengatasi masalah ini dengan menyediakan teknologi yang diklaim dapat mengautentikasi media pada saat pembuatannya melalui Truepic Lens. Aplikasi pengumpul data ini akan memberi tahu pengguna tanggal, waktu, lokasi, dan perangkat yang digunakan untuk membuat gambar, serta menerapkan tanda tangan digital untuk memverifikasi apakah gambar tersebut alami atau hasil rekayasa AI.

Foto palsu ledakan Pentagon viral di Twitter

Truepic, perusahaan yang didukung Microsoft dan didirikan pada tahun 2015, mengatakan perusahaan melihat minat dari LSM hingga perusahaan media, bahkan perusahaan asuransi yang ingin memastikan klaim tersebut sah.

McGregor mengatakan bahwa ketika segalanya dapat dipalsukan, ketika kecerdasan buatan telah mencapai puncaknya dalam kualitas dan aksesibilitas, kita tidak lagi tahu apa realitas yang ada secara daring.

Perusahaan teknologi seperti Truepic telah berupaya memerangi misinformasi daring selama bertahun-tahun. Namun, munculnya perangkat AI jenis baru yang dapat menghasilkan gambar dan teks dari perintah pengguna telah meningkatkan urgensinya. Awal tahun ini, foto palsu Paus Fransiskus yang mengenakan jaket Balenciaga dan mantan Presiden AS Donald Trump yang sedang ditangkap telah tersebar luas. Kedua insiden tersebut telah membuat jutaan orang khawatir akan potensi bahaya AI.

Beberapa anggota parlemen kini mendesak perusahaan teknologi untuk mengatasi masalah ini dengan memberi label pada konten yang dihasilkan AI. Wakil Presiden Komisi Eropa, Vera Jourova, mengatakan perusahaan-perusahaan termasuk Google, Meta, Microsoft, dan TikTok telah bergabung dengan kode praktik sukarela Uni Eropa tentang pemberantasan disinformasi.

Semakin banyak perusahaan rintisan dan raksasa teknologi, termasuk beberapa yang menerapkan AI generatif dalam produk mereka, mencoba menerapkan standar dan solusi untuk membantu orang menentukan apakah suatu gambar atau video dibuat dengan AI.

Namun, seiring perkembangan teknologi AI yang lebih cepat daripada kemampuan manusia, masih belum jelas apakah solusi ini dapat sepenuhnya menyelesaikan masalah. Bahkan OpenAI, perusahaan di balik Dall-E dan ChatGPT, telah mengakui bahwa upaya mereka sendiri untuk membantu mendeteksi tulisan yang dihasilkan AI masih belum sempurna.

Perusahaan yang mengembangkan solusi menggunakan dua pendekatan untuk memecahkan masalah ini. Pendekatan pertama mengandalkan pengembangan program untuk mengidentifikasi gambar yang dihasilkan AI setelah diproduksi dan dibagikan secara daring. Pendekatan kedua berfokus pada penandaan gambar sebagai asli atau hasil AI dengan semacam tanda tangan digital.

Reality Defender dan Hive Moderation sedang mengembangkan yang pertama. Melalui platform mereka, pengguna dapat mengunggah gambar untuk dipindai, lalu menerima analisis yang menunjukkan persentase keaslian foto atau hasil rekayasa AI.

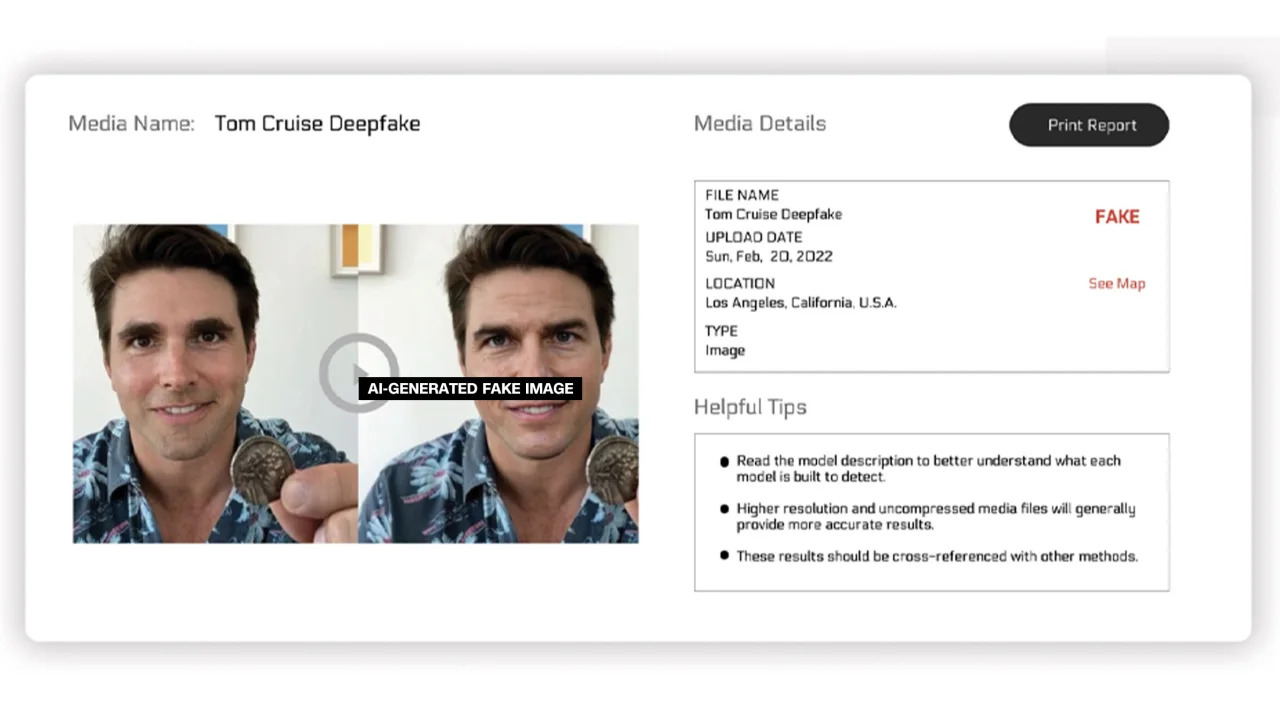

Reality Defender menyatakan bahwa mereka menggunakan teknologi deepfake dan sidik jari konten generatif yang telah dipatenkan untuk mendeteksi video, audio, dan gambar yang dihasilkan AI. Dalam contoh yang diberikan oleh perusahaan, Reality Defender menunjukkan gambar deepfake Tom Cruise yang 53% "mencurigakan" karena orang dalam gambar tersebut memiliki wajah terdistorsi yang umum ditemukan pada foto-foto yang dimanipulasi.

Gambar berlabel yang dihasilkan AI

Layanan ini menawarkan versi gratis dan berbayar. Hive Moderation mengatakan mereka mengenakan biaya $1,50 per 1.000 gambar. Realty Defender mengatakan harganya dapat bervariasi berdasarkan berbagai faktor, jika klien membutuhkan keahlian dan dukungan perusahaan. CEO Reality Defender, Ben Colman, mengatakan risikonya berlipat ganda setiap bulan karena siapa pun dapat membuat foto palsu menggunakan alat AI.

Beberapa perusahaan lain sedang berupaya menambahkan semacam label pada gambar untuk memastikan keasliannya atau hasil rekayasa AI. Sejauh ini, upaya ini sebagian besar didorong oleh Content Authenticity and Origination Alliance (C2PA).

C2PA didirikan pada tahun 2021 untuk menciptakan standar teknis sertifikasi asal dan sejarah media digital, menggabungkan Inisiatif Autentikasi Konten (CAI) Adobe dan Project Origin, yang dipimpin oleh Microsoft dan BBC, dengan fokus memerangi misinformasi dalam berita digital. Perusahaan lain yang terlibat dalam C2PA antara lain Truepic, Intel, dan Sony.

Berdasarkan prinsip C2PA, CAI akan merilis perangkat sumber terbuka bagi perusahaan untuk membuat kredensial konten atau metadata yang berisi informasi tentang gambar. Menurut situs web CAI, hal ini akan memungkinkan kreator untuk membagikan detail tentang cara mereka membuat gambar secara transparan. Dengan demikian, pengguna akhir dapat mengakses konteks seputar siapa, apa, dan bagaimana gambar tersebut diubah — lalu menilai sendiri keaslian gambar tersebut.

Banyak perusahaan telah mengintegrasikan standar C2PA dan perangkat CAI ke dalam aplikasi mereka. Firefly dari Adobe, perangkat pencitraan AI baru yang ditambahkan ke Photoshop, mematuhi standar C2PA melalui fitur Kredensial Kontennya. Microsoft juga mengumumkan bahwa gambar dan video yang dibuat dengan Bing Image Creator dan Microsoft Designer akan memiliki tanda tangan kriptografi dalam beberapa bulan mendatang.

Pada bulan Mei, Google mengumumkan fitur "Tentang Gambar Ini" yang memungkinkan pengguna melihat kapan sebuah gambar pertama kali muncul di Google dan di mana gambar tersebut dapat dilihat. Raksasa pencarian ini juga mengumumkan bahwa setiap gambar yang dihasilkan oleh Google AI akan memiliki markup di berkas aslinya untuk "menambahkan konteks" jika gambar tersebut ditemukan di situs web atau platform lain.

Sementara perusahaan-perusahaan teknologi berupaya mengatasi kekhawatiran tentang citra yang dihasilkan AI dan integritas media digital, para ahli di bidang ini menekankan bahwa bisnis perlu bekerja sama dan dengan pemerintah untuk mengatasi masalah ini. Namun, perusahaan-perusahaan teknologi berlomba-lomba mengembangkan AI meskipun ada risikonya.

[iklan_2]

Tautan sumber

![[Foto] Program seni khusus "Da Nang - Menghubungkan masa depan"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/2/efdd7e7142fd45fabc2b751d238f2f08)

![[Foto] Warga Kota Ho Chi Minh menunjukkan rasa cinta mereka untuk merayakan ulang tahun ke-80 Revolusi Agustus dan Hari Nasional 2 September](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/3/55d860cbb63a40808e1e74ad9289b132)

Komentar (0)