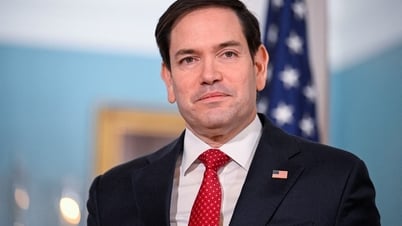

Dalam pembaruan prinsip-prinsip AI yang baru dirilis, perusahaan induk Google, Alphabet, telah menguraikan rencana mereka untuk menggunakan AI di masa mendatang. Yang paling menonjol, mereka telah menghapus janji untuk tidak menggunakan AI untuk membuat senjata, alat pengawasan, atau "teknologi yang dapat menyebabkan kerusakan luas."

Garis Merah Google pada AI

Istilah "garis merah" AI Google pertama kali muncul pada tahun 2018, ketika para karyawan memprotes proyek AI perusahaan, Maven, yang merupakan hasil kolaborasi dengan Departemen Pertahanan AS. Saat itu, lebih dari 4.000 karyawan Google menandatangani petisi untuk mengakhiri proyek tersebut dan menuntut agar perusahaan tidak pernah "membangun teknologi untuk perang".

Google kemudian tidak memperbarui kontraknya untuk membangun perangkat AI bagi Pentagon. Perusahaan tersebut juga menetapkan batas merah, menyatakan bahwa "aplikasi AI yang tidak sesuai dengan hukum", termasuk senjata dan teknologi yang mengumpulkan atau menggunakan informasi untuk pengawasan yang melanggar norma-norma yang diterima secara internasional, juga tidak akan digunakan oleh Google. Teknologi yang menyebabkan atau berpotensi menyebabkan kerugian publik, atau melanggar prinsip-prinsip hukum internasional dan hak asasi manusia yang diterima secara luas, juga tidak akan digunakan.

Beberapa aplikasi Google di iPhone

Keputusan untuk menarik garis merah pada AI dengan senjata telah menghalangi Google berpartisipasi dalam kesepakatan militer yang ditandatangani oleh raksasa teknologi lainnya, termasuk Amazon dan Microsoft.

Namun, menghadapi perubahan besar dalam persaingan AI, Google memutuskan untuk menarik kembali janjinya. Hal ini menimbulkan banyak kontroversi, tidak hanya di Google, tetapi juga menunjukkan pergeseran penting perusahaan teknologi Silicon Valley ke industri pertahanan.

Google terbagi secara internal

Menurut Business Insider , pembaruan tentang prinsip dan etika AI telah memicu reaksi keras dari karyawan Google. Karyawan telah mengungkapkan rasa frustrasi mereka di forum internal. Sebuah meme yang menunjukkan CEO Sundar Pichai bertanya kepada mesin pencari Google dengan pertanyaan "bagaimana cara menjadi kontraktor senjata?" telah mendapat banyak perhatian.

Karyawan lain membuat meme yang bertanya, "Apakah kami orang jahat karena mencabut larangan AI untuk senjata dan pengawasan?" Perusahaan ini memiliki lebih dari 180.000 karyawan. Mungkin masih ada suara-suara yang mendukung keputusan Google untuk bekerja sama lebih erat dengan pemerintah AS dan pelanggan militer serta pertahanannya.

Alasan Google

Juru bicara Google tidak segera menanggapi permintaan komentar terkait pencabutan "janji AI". Namun, kepala AI, Demis Hassabis, mengatakan pedoman tersebut terus berkembang seiring dunia yang terus berubah dan bahwa AI akan "melindungi keamanan nasional".

Dalam postingan blog perusahaan, Hassabis dan James Manyika, wakil presiden senior teknologi dan masyarakat Google, mengatakan bahwa seiring meningkatnya persaingan global untuk kepemimpinan dalam AI, Google percaya AI harus dipandu oleh kebebasan, kesetaraan, dan penghormatan terhadap hak asasi manusia.

"Kami percaya bahwa perusahaan, pemerintah, dan organisasi memiliki nilai-nilai yang sama dan harus bekerja sama untuk menciptakan AI yang dapat melindungi masyarakat, mendorong pertumbuhan global, dan mendukung keamanan nasional," tambah mereka.

Dua eksekutif Google mengatakan bahwa miliaran orang menggunakan AI dalam kehidupan sehari-hari. Kecerdasan buatan telah menjadi teknologi serbaguna, sebuah platform yang digunakan oleh banyak organisasi dan individu untuk membangun aplikasi. AI telah bertransformasi dari topik penelitian khusus di laboratorium menjadi teknologi yang tersebar luas seperti ponsel dan internet. Oleh karena itu, "sumpah AI" Google dari tahun 2018 perlu diperbarui.

Alphabet mengatakan pihaknya berencana untuk menghabiskan $75 miliar tahun depan, sebagian besar untuk membangun kemampuan dan infrastruktur AI.

[iklan_2]

Sumber: https://thanhnien.vn/google-rut-lai-loi-hua-khong-dung-ai-cho-quan-su-185250206161804981.htm

![[Foto] Ketua Majelis Nasional Tran Thanh Man bertemu dengan Sekretaris Pertama dan Presiden Kuba Miguel Diaz-Canel Bermudez](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/2/c6a0120a426e415b897096f1112fac5a)

![[Foto] Program seni khusus "Da Nang - Menghubungkan masa depan"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/2/efdd7e7142fd45fabc2b751d238f2f08)

![[Foto] Warga Kota Ho Chi Minh menunjukkan rasa cinta mereka untuk merayakan ulang tahun ke-80 Revolusi Agustus dan Hari Nasional 2 September](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/3/55d860cbb63a40808e1e74ad9289b132)

![[Foto] Presiden Laos Thongloun Sisoulith dan Presiden Partai Rakyat Kamboja serta Presiden Senat Kamboja Hun Sen mengunjungi Pameran Ulang Tahun ke-95 Bendera Partai yang Menyinari Jalan](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/2/3c1a640aa3c3495db1654d937d1471c8)

Komentar (0)