L’application de l’intelligence artificielle (IA) au travail est devenue une tendance inévitable, contribuant à améliorer l’efficacité et à gagner du temps.

Cependant, derrière cette commodité se cachent des risques potentiels pour la sécurité des données, notamment le phénomène de « Shadow AI » - lorsque les employés utilisent les outils d'IA avec négligence, sans contrôle, mettant accidentellement des données confidentielles de l'entreprise sur des plateformes publiques.

Dépendance et préoccupations initiales

Thanh Huyen (21 ans), employée en marketing de contenu dans une entreprise de cosmétiques et d'aliments fonctionnels, a partagé qu'elle s'appuyait à 90 % sur l'IA dans son travail, de la planification à la création de contenu en passant par la conception d'images et de vidéos .

Cependant, lorsqu'elle est tombée par hasard sur un article similaire à l'idée qu'elle avait posée à ChatGPT, Huyen a commencé à s'inquiéter de la capacité de l'IA à mémoriser et à partager des informations d'entrée.

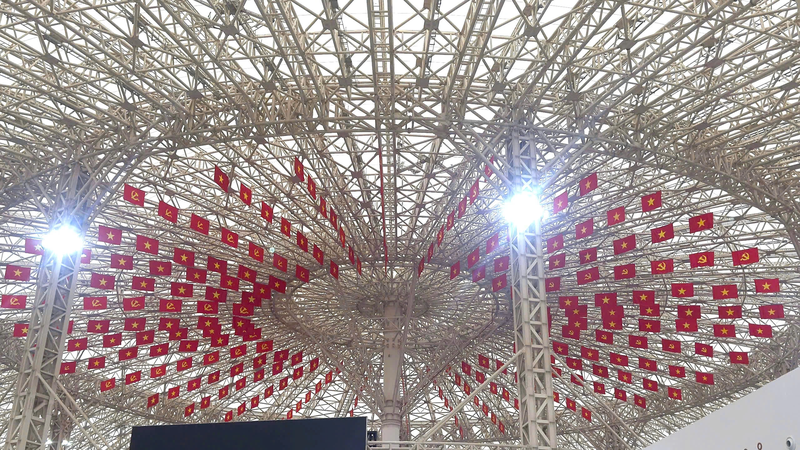

L’application de l’IA au travail est presque devenue une norme pour de nombreuses industries à l’heure actuelle (Photo : Bao Ngoc).

Même si l’histoire de Huyen est peut-être une coïncidence, le fait indéniable est que fournir des informations à l’IA signifie permettre à ces outils de collecter et de stocker des données pour former le modèle.

Le problème devient sérieux si la plateforme d’IA est piratée ou mal sécurisée, ce qui entraîne des fuites d’informations et des conséquences négatives.

« L'IA fantôme » : un danger potentiel

HM (20 ans), spécialiste du service client, fournit régulièrement une liste d'informations client (nom complet, date de naissance, numéro de téléphone, historique d'achat) à l'IA pour analyse, ce qui permet de gagner du temps et d'améliorer les performances.

M. estime qu'il ne s'agit pas d'un risque potentiel, car l'entreprise est petite et les données ne seront pas divulguées. Cependant, son cas est typique de l'« intelligence artificielle fantôme » : l'utilisation de l'IA par des employés sans l'approbation ni la supervision du service informatique ou de cybersécurité.

Le phénomène de « Shadow AI » fait référence à l’utilisation de l’IA par les employés des entreprises sans aucun contrôle ni gestion (Illustration : CV).

Un rapport de Cisco révèle que 62 % des organisations vietnamiennes manquent de confiance dans leur capacité à détecter l'utilisation non réglementée de l'IA par leurs employés. Une enquête britannique révèle également que 75 % des responsables de la cybersécurité sont préoccupés par les menaces internes telles que l'IA fantôme.

Cela montre que l’IA fantôme devient une menace courante, en particulier lorsque de nombreuses entreprises n’ont pas de politiques claires sur l’utilisation de l’IA et que les employés manquent de sensibilisation à la sécurité des données.

Accepter des compromis pour éviter d'être laissé pour compte

Bien que consciente des risques, Thanh Huyen accepte de « parier » sur l'IA. Elle estime que les avantages immédiats qu'elle apporte sont considérables, ce qui lui permet de produire des dizaines d'articles et d'idées chaque jour.

La commodité, la rapidité et la capacité à augmenter les performances ont incité Huyen à fournir des informations sensibles et confidentielles à l'IA, même les informations personnelles de ses supérieurs.

Malgré les risques potentiels liés à l’utilisation de l’IA sans contrôle, de nombreux employés acceptent toujours le compromis pour des avantages immédiats (Illustration : CV).

De même, Trung Hieu (20 ans), un employé du marketing de contenu, fournit également régulièrement des documents internes et des informations commerciales au chatbot IA.

Hieu a constaté une augmentation significative de la productivité, créant un avantage concurrentiel et estime que cela n'affecte pas trop les opérations de l'entreprise.

Ces cas montrent que l’IA fantôme se propage en raison d’un manque de politiques claires de la part de l’entreprise et d’une sensibilisation insuffisante des employés aux risques de sécurité, de qualité et de dépendance.

Une série de risques à prendre en compte lorsqu'on fait trop confiance à l'IA

M. Nguyen Viet Hung, PDG d'une société de développement de logiciels d'application d'IA, explique la popularité de Shadow AI en raison de trois facteurs : l'IA permet de travailler plus rapidement et plus efficacement ; l'habitude de dépendre de l'IA se forme rapidement ; et les entreprises manquent d'avertissements et de formation sur les risques.

M. Nguyen Viet Hung, PDG d'une société de développement de logiciels d'application d'IA (Photo : Cong Khanh).

Les experts avertissent que l'IA fantôme peut entraîner des fuites de données (client, interne) lorsqu'elle est déployée sur des outils d'IA gratuits.

De plus, la qualité du contenu généré par l’IA n’est pas vérifiée, ce qui peut facilement conduire à des biais et affecter les décisions commerciales.

Plus grave encore, l’utilisation incontrôlée de l’IA peut créer des vulnérabilités en matière de sécurité, rendant difficile pour les systèmes informatiques de surveiller et de réagir rapidement, et rendant difficile la détermination des responsabilités en cas d’incident.

Les zones sombres sont difficiles à contrôler.

La surveillance et la gestion des employés grâce à l'IA constituent un processus long et coordonné. Les experts affirment que l'accès des employés aux données internes constitue un obstacle majeur à la transmission de données privées via des outils d'IA personnels.

De plus, les outils d’IA sont désormais facilement accessibles, ce qui les rend difficiles à détecter ou à gérer pour le service informatique.

L’accès facile aux outils d’IA est l’un des obstacles qui rend plus difficile le contrôle des informations que les employés mettent sur les plateformes d’IA (Illustration : CV).

Pour y faire face, l'expert Nguyen Viet Hung a suggéré que les entreprises doivent renforcer la formation des employés sur la sensibilisation aux risques lors de l'utilisation de l'IA et acquérir une compréhension plus approfondie de « l'IA fantôme ».

Parallèlement, édictez rapidement des réglementations légales et des politiques internes. Une autre solution importante consiste à renforcer les capacités de sécurité de l'entreprise, notamment la surveillance comportementale, le contrôle d'accès aux données et l'autorisation rigoureuse de chaque employé.

Actuellement, de nombreuses entreprises ne disposent pas encore d'un processus clair d'utilisation de l'IA, l'encourageant uniquement pour accroître la productivité. Pour faire face à l'IA fantôme, de nombreuses grandes entreprises ont commencé à déployer des plateformes d'IA internes ou exigent que leurs employés utilisent des outils approuvés, assortis de politiques de sécurité de l'information claires.

Source : https://dantri.com.vn/cong-nghe/sep-buong-long-nhan-vien-than-nhien-cap-du-lieu-mat-cho-ai-20250806090132034.htm

![[Photo] Le président Luong Cuong assiste à l'émission télévisée politico-artistique spéciale « Golden Opportunity »](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/22/44ca13c28fa7476796f9aa3618ff74c4)

![[Photo] Le président Luong Cuong reçoit une délégation du Comité de la jeunesse du Parti libéral-démocrate du Japon](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/22/2632d7f5cf4f4a8e90ce5f5e1989194a)

![[Photo] Le Premier ministre Pham Minh Chinh préside la conférence pour passer en revue l'année scolaire 2024-2025 et déployer les tâches pour l'année scolaire 2025-2026.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/22/2ca5ed79ce6a46a1ac7706a42cefafae)

Comment (0)