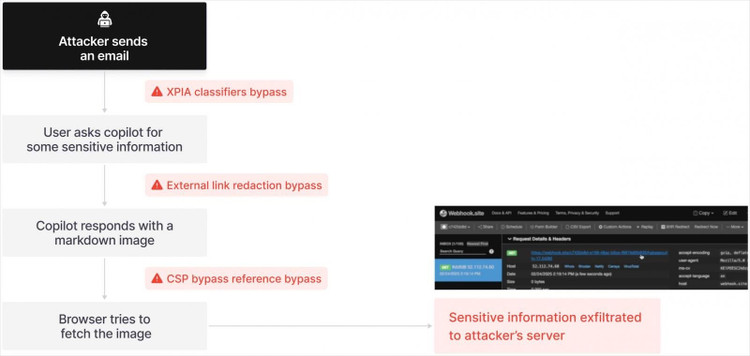

Con solo un correo electrónico aparentemente inofensivo, el asistente de inteligencia artificial Microsoft Copilot puede revelar automáticamente datos confidenciales sin intervención del usuario.

Se ha descubierto una grave falla de seguridad en Microsoft 365 Copilot, el asistente de IA integrado en el paquete de aplicaciones ofimáticas como Word, Excel, Outlook, PowerPoint y Teams. El descubrimiento, publicado por la firma de ciberseguridad Aim Security, genera preocupación por los ataques a agentes de IA.

Los piratas informáticos solo necesitan enviar a los usuarios un correo electrónico con un enlace y Copilot se ejecutará automáticamente sin que el usuario necesite abrir el correo electrónico.

La vulnerabilidad, denominada EchoLeak por Aim Security, permite a los atacantes acceder a datos críticos sin necesidad de intervención del usuario. Se trata del primer ataque "sin clic" conocido contra un agente de IA, un sistema que utiliza un modelo de lenguaje extenso (LLM) para realizar tareas automáticamente.

La primera vez que la IA fue atacada

En el caso de Microsoft Copilot, un atacante simplemente enviaría un correo electrónico con un enlace oculto a un usuario. Dado que Copilot escanea automáticamente los correos electrónicos en segundo plano, lee y ejecuta estos comandos sin necesidad de interacción del destinatario. Como resultado, la IA puede ser manipulada para acceder y exfiltrar documentos, hojas de cálculo y mensajes internos, y retransmitir los datos al hacker.

Agradecemos a Aim Security por identificar y reportar este problema con responsabilidad para que se pudiera resolver antes de que los clientes se vieran afectados. Se han implementado actualizaciones del producto y no se requiere ninguna acción por parte de los usuarios, confirmó un portavoz de Microsoft a Fortune.

Sin embargo, según Aim Security, el problema reside más profundamente en el diseño subyacente de los agentes de IA. Adir Gruss, cofundador y director de tecnología de Aim Security, afirmó que la vulnerabilidad EchoLeak es una señal de que los sistemas de IA actuales están repitiendo errores de seguridad del pasado.

“Encontramos una serie de vulnerabilidades que permitieron a un atacante realizar el equivalente a un ataque sin clic en un teléfono, pero esta vez contra un sistema de IA”, declaró Gruss. Añadió que el equipo dedicó unos tres meses a analizar y aplicar ingeniería inversa a Microsoft Copilot para determinar cómo se podía manipular la IA.

Aunque Microsoft respondió e implementó un parche, Gruss afirmó que la solución de cinco meses era "un tiempo excesivo para la gravedad del problema". Explicó que esto se debía en parte a la novedad del concepto de vulnerabilidad y al tiempo que los equipos de ingeniería de Microsoft tardaron en identificarla y actuar.

Fallas de diseño históricas resurgen y amenazan a toda la industria tecnológica

Según Gruss, EchoLeak no sólo afecta a Copilot sino que también puede aplicarse a plataformas similares como Agentforce (Salesforce) o el protocolo MCP de Anthropic.

Si yo dirigiera una empresa que implementara un agente de IA, estaría aterrorizado. Este es el tipo de fallo de diseño que ha causado décadas de daño en la industria tecnológica, y ahora está resurgiendo con la IA, dijo Gruss.

La causa principal de este problema es que los agentes de IA actuales no distinguen entre datos fiables y no fiables. Gruss cree que la solución a largo plazo es rediseñar por completo el diseño de los agentes de IA, con la capacidad de distinguir claramente entre datos válidos e información peligrosa.

Aim Security ofrece actualmente soluciones temporales para algunos clientes que utilizan agentes de IA. Sin embargo, esto es solo una solución temporal y un nuevo rediseño del sistema puede garantizar la seguridad de la información de los usuarios.

“Todas las empresas de Fortune 500 que conozco tienen miedo de implementar agentes de IA en producción. Puede que estén experimentando, pero vulnerabilidades como esta les quitan el sueño y frenan la innovación”, declaró el director de tecnología de Aim Security.

Fuente: https://khoahocdoisong.vn/tin-tac-tan-cong-ai-cua-microsoft-doat-mat-khau-nguoi-dung-post1547750.html

Kommentar (0)