Dementsprechend erreichte sogar die von ihnen getestete Konfiguration eines künstlichen Intelligenzmodells mit der besten Leistung, GPT-4-Turbo von OpenAI, trotz des Lesens des gesamten Profils nur eine richtige Antwortrate von 79 % und erlebte häufig „Halluzinationen“ von unwirklichen Zahlen oder Ereignissen.

„Diese Leistungsrate ist völlig inakzeptabel“, sagte Anand Kannappan, Mitbegründer von Patronus AI. „Die richtige Antwortrate muss viel höher sein, um automatisiert und produktionsreif zu sein.“

Die Ergebnisse verdeutlichen einige der Herausforderungen, vor denen KI-Modelle stehen, da große Unternehmen, insbesondere in stark regulierten Branchen wie dem Finanzwesen, versuchen, fortschrittliche Technologien in ihre Betriebsabläufe zu integrieren, sei es im Kundenservice oder in der Forschung.

Finanzdaten-"Illusion"

Die Fähigkeit, schnell wichtige Zahlen zu extrahieren und Bilanzanalysen durchzuführen, gilt seit der Veröffentlichung von ChatGPT Ende letzten Jahres als eine der vielversprechendsten Anwendungen für Chatbots.

SEC-Anmeldungen enthalten wichtige Daten. Wenn ein Bot deren Inhalt präzise zusammenfassen oder Fragen dazu schnell beantworten kann, könnte dies den Benutzern einen Vorteil in der wettbewerbsintensiven Finanzbranche verschaffen.

Im vergangenen Jahr hat Bloomberg LP ein eigenes KI-Modell für Finanzdaten entwickelt und Professoren von Wirtschaftshochschulen haben untersucht, ob ChatGPT Finanzschlagzeilen analysieren kann.

JPMorgan entwickelt derzeit ein KI-gestütztes automatisiertes Anlagetool. Einer aktuellen McKinsey-Prognose zufolge könnte generative KI dem Bankensektor jährlich Billionen von Dollar einbringen.

Doch bis dahin ist es noch ein weiter Weg. Als Microsoft Bing Chat mit OpenAIs GPT startete, nutzte es den Chatbot, um Pressemitteilungen zu den Unternehmensergebnissen schnell zusammenzufassen. Beobachter bemerkten schnell, dass die von der KI ausgespuckten Zahlen verzerrt oder sogar gefälscht waren.

Gleiche Daten, unterschiedliche Antworten

Eine der Herausforderungen bei der Integration von LLM in reale Produkte besteht darin, dass Algorithmen nicht deterministisch sind. Das bedeutet, dass sie bei gleichen Eingaben nicht garantiert die gleichen Ergebnisse liefern. Unternehmen müssen daher strengere Tests durchführen, um sicherzustellen, dass KI korrekt funktioniert, nicht vom Thema abweicht und zuverlässige Ergebnisse liefert.

Patronus AI hat einen Satz von über 10.000 Fragen und Antworten aus SEC-Anmeldungen großer börsennotierter Unternehmen erstellt, genannt FinanceBench. Der Datensatz enthält die richtigen Antworten sowie die genaue Position in der jeweiligen Datei, an der diese gefunden werden können.

Nicht alle Antworten können direkt aus dem Text entnommen werden und einige Fragen erfordern Berechnungen oder leichtes Denken.

Der 150 Fragen umfassende Teilmengentest umfasste vier LLM-Modelle: GPT-4 und GPT-4-Turbo von OpenAI, Claude 2 von Anthropics und Llama 2 von Meta.

Infolgedessen erreichte GPT-4-Turbo, als ihm Zugriff auf die zugrunde liegenden Unterlagen der SEC gewährt wurde, nur eine Genauigkeitsrate von 85 % (im Vergleich zu 88 %, wenn es keinen Zugriff auf die Daten hatte), obwohl ein Mensch mit der Maus auf den genauen Text zeigte, damit die KI die Antwort finden konnte.

Llama 2, ein von Meta entwickeltes Open-Source-KI-Modell, hatte die höchste Anzahl an „Halluzinationen“: 70 % der Antworten waren falsch und nur 19 % richtig, als man ihm Zugriff auf einen Teil der zugrunde liegenden Dokumente gewährte.

Claude 2 von Anthropic schnitt in einem „langen Kontext“ gut ab, in dem neben der Frage auch fast die gesamte relevante SEC-Anmeldung enthalten war. Es konnte 75 % der gestellten Fragen beantworten, 21 % falsch und 3 % verweigerte die Antwort. GPT-4-Turbo schnitt in einem langen Kontext ebenfalls gut ab und beantwortete 79 % der Fragen richtig und 17 % falsch.

(Laut CNBC)

Der Wettlauf der großen Technologieunternehmen um Investitionen in KI-Startups

KI-Technologie revolutioniert E-Commerce-Startups

KI gelingt es erstmals, menschliche Gedanken in realistische Bilder umzuwandeln

[Anzeige_2]

Quelle

![[Foto] Leuchtendes Rot der Ausstellung 95 Jahre Parteifahne leuchtet den Weg vor der Eröffnung](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/27/e19d957d17f649648ca14ce6cc4d8dd4)

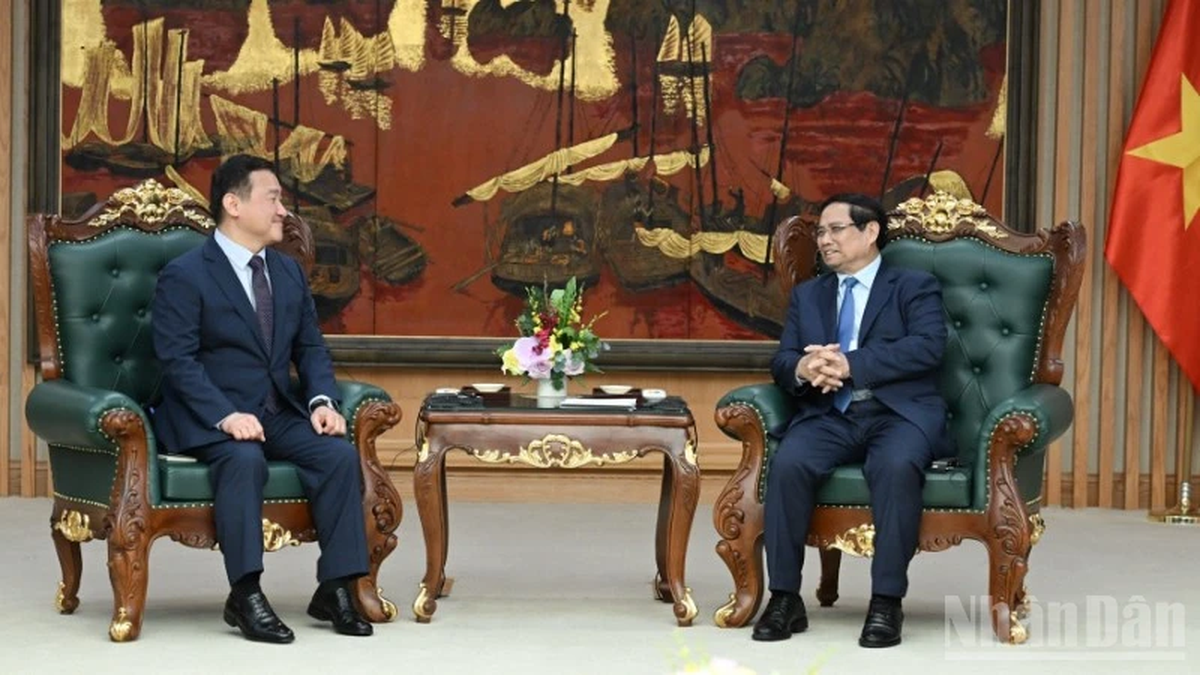

![[Foto] Premierminister Pham Minh Chinh empfängt den CEO von Samsung Electronics](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/26/373f5db99f704e6eb1321c787485c3c2)

![[Foto] Premierminister Pham Minh Chinh leitet die Sitzung des Nationalen Lenkungsausschusses für internationale Integration](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/26/9d34a506f9fb42ac90a48179fc89abb3)

Kommentar (0)