Odbor informační bezpečnosti nedávno vydal varování ohledně pokračujícího opakování podvodů s high-tech videi a obrázky.

Úřady proto veřejnost široce varovaly před situací, kdy kyberzločinci zneužívají veřejné fotografie a videa lidí k úpravám, stříhání a vyhrožování vydíráním falešnými videi.

Pomocí technologie Deepfake, která umožňuje reprodukci zvuku a obrazu osoby s vysokou přesností, se zločinci mohou vydávat za vůdce na online schůzkách nebo vytvářet videa a hovory za účelem spáchání finančních podvodů.

Tyto podvody navíc často zneužívají psychologické faktory, jako je naléhavost, strach nebo moc, což nutí oběti jednat ukvapeně, aniž by pečlivě ověřily pravost informací.

Deepfake se neomezují pouze na podvody s finančními investicemi. Dalším příkladem jsou romantické podvody, kde se Deepfakes používají k vytváření fiktivních postav, které interagují s oběťmi prostřednictvím videohovorů. Poté, co si podvodník získá důvěru oběti, požádá o převod peněz na řešení nouzových situací, cestovních výdajů nebo půjček.

Vzhledem k výše uvedené situaci odbor informační bezpečnosti doporučuje, aby si lidé dávali pozor na investiční rady od celebrit na sociálních sítích, aby si dávali pozor na neidentifikované zprávy, e-maily nebo hovory a aby si pečlivě všímali nepřirozených výrazů obličeje ve videích.

Lidé by také měli omezit zveřejňování obsahu souvisejícího s osobními údaji na sociálních sítích, aby se vyhnuli krádeži informací, jako jsou obrázky, videa nebo hlasy, ze strany zločinců; zároveň by si měli nastavit soukromý režim účtů, aby chránili osobní údaje.

V rozhovoru s reportéry deníku Dai Doan Ket uvedl expert na kybernetickou bezpečnost Ngo Minh Hieu, spoluzakladatel Vietnamského projektu pro prevenci kybernetických podvodů (Chongluadao.vn), že využití technologie Deepfake v umělé inteligenci k falešným videohovorům za účelem podvodu je stále komplikované. Subjekty tuto technologii zneužívají ke zvýšení důvěryhodnosti své „kořisti“.

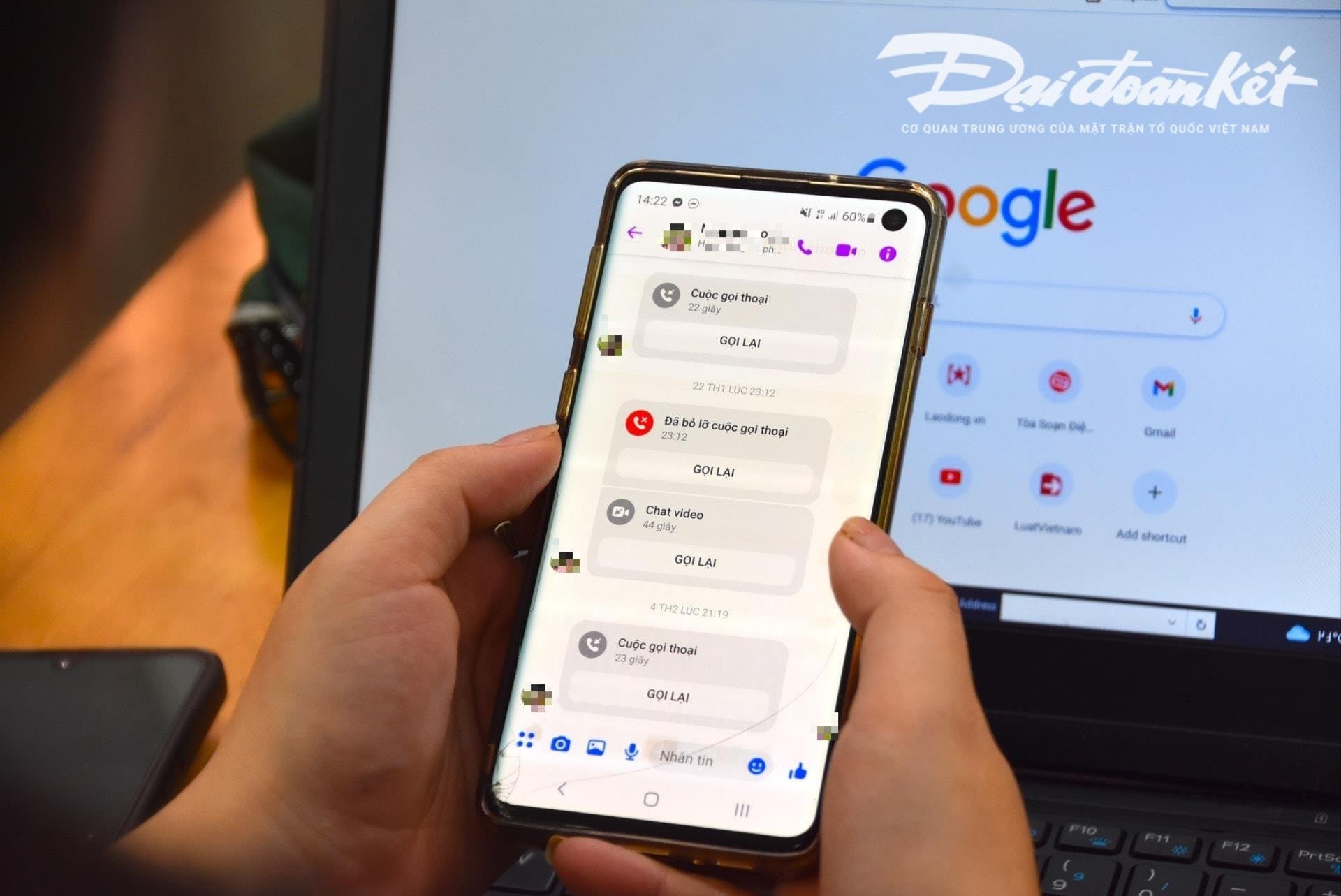

Konkrétně subjekty proaktivně uskutečňují videohovory s oběťmi z dříve „ukradených“ obrázků a videí a technicky je zpracovávají, zkreslují zvuk nebo falešně vytvářejí problémy s obrazem, aby si získaly důvěru obětí.

Tyto hovory jsou obvykle velmi krátké, trvají jen několik sekund, a poté podvodník použije výmluvu nestabilní sítě, pobytu na ulici atd., aby oběť požádal o splnění podvodníkovy žádosti.

Odborníci varují, že používání umělé inteligence pro kybernetické podvody se v blízké budoucnosti pravděpodobně výrazně zvýší. Lidé si proto musí proaktivně zvyšovat povědomí, zejména když dostávají podivné zprávy, videohovory a odkazy.

Podle analýzy tohoto experta si současný algoritmus umělé inteligence (AI) Deepfake během hovorů v reálném čase neporadí, pokud se volající otočí doleva, doprava nebo vstane...

Jednou z konkrétních slabin, na kterou by si lidé měli dát při přijímání těchto hovorů pozor, jsou zuby. Současné algoritmy umělé inteligence proto nedokážou reprodukovat zuby osoby, za kterou je vydáván.

Při použití Deepfake nemusí být na obrázku osoby otevírající ústa zuby, někteří lidé mají 3, dokonce 4 čelisti. Proto je charakteristika zubů nejrozpoznatelnějším prvkem falešného hovoru provedeného pomocí Deepfake.

„Zpomalení“ a nereagování na žádost okamžitě je nezbytným předpokladem, aby se zabránilo pádu do podvodné pasti. Při přijímání jakékoli zprávy nebo hovoru prostřednictvím sociálních sítí je nutné zavolat přímo svým příbuzným, aby si ověřili, kdo je kontaktuje, s minimální dobou kontaktu delší než 30 sekund, nebo se setkat osobně.

V případě podezření z vydávání se za příbuzné na sociálních sítích za účelem podvodu nebo přivlastnění si majetku je nutné neprodleně nahlásit situaci nejbližšímu policejnímu sboru, který včas podpoří a vyřídí případ.

Zdroj: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

![[Foto] Úžasné úplné zatmění Měsíce na mnoha místech po celém světě](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/8/7f695f794f1849639ff82b64909a6e3d)

Komentář (0)