Департамент информационной безопасности недавно выпустил предупреждение в связи с продолжающимися случаями мошенничества с использованием высокотехнологичных видео- и фотоматериалов.

Соответственно, власти широко предупреждали общественность о ситуации, когда киберпреступники используют публичные изображения и видеозаписи людей для редактирования, вырезания и шантажа с помощью поддельных видеороликов.

Используя технологию Deepfake, которая позволяет воспроизводить звук и изображение человека с высокой точностью, преступники могут выдавать себя за лидеров на онлайн-встречах или создавать видеоролики и звонки для совершения финансовых мошенничеств.

Более того, подобные мошенничества часто эксплуатируют психологические факторы, такие как срочность, страх или власть, заставляя жертв действовать поспешно, не проверяя тщательно подлинность.

Дипфейки не ограничиваются финансовыми инвестиционными аферами. Другой пример — аферы с романтическими отношениями, где дипфейки используются для создания вымышленных персонажей, которые взаимодействуют с жертвами посредством видеозвонков. Завоевав доверие жертвы, мошенник запрашивает денежные переводы на покрытие непредвиденных расходов, дорожных расходов или кредитов.

В свете вышеизложенной ситуации Департамент информационной безопасности рекомендует гражданам с осторожностью относиться к инвестиционным советам от знаменитостей в социальных сетях; с осторожностью относиться к неопознанным сообщениям, электронным письмам или звонкам; а также внимательно следить за неестественной мимикой на видео.

Людям также необходимо ограничить публикацию в социальных сетях контента, связанного с личной информацией, чтобы избежать кражи такой информации, как изображения, видео или голоса, злоумышленниками; в то же время следует перевести учетные записи в приватный режим, чтобы защитить личную информацию.

В беседе с журналистами газеты Dai Doan Ket эксперт по кибербезопасности Нго Минь Хьеу, соучредитель проекта Vietnam Cyber Fraud Prevention Project (Chongluadao.vn), заявил, что использование технологии Deepfake в ИИ для подделки видеозвонков в целях мошенничества по-прежнему представляет собой сложную задачу. Субъекты используют эту технологию для повышения доверия к своей «жертве».

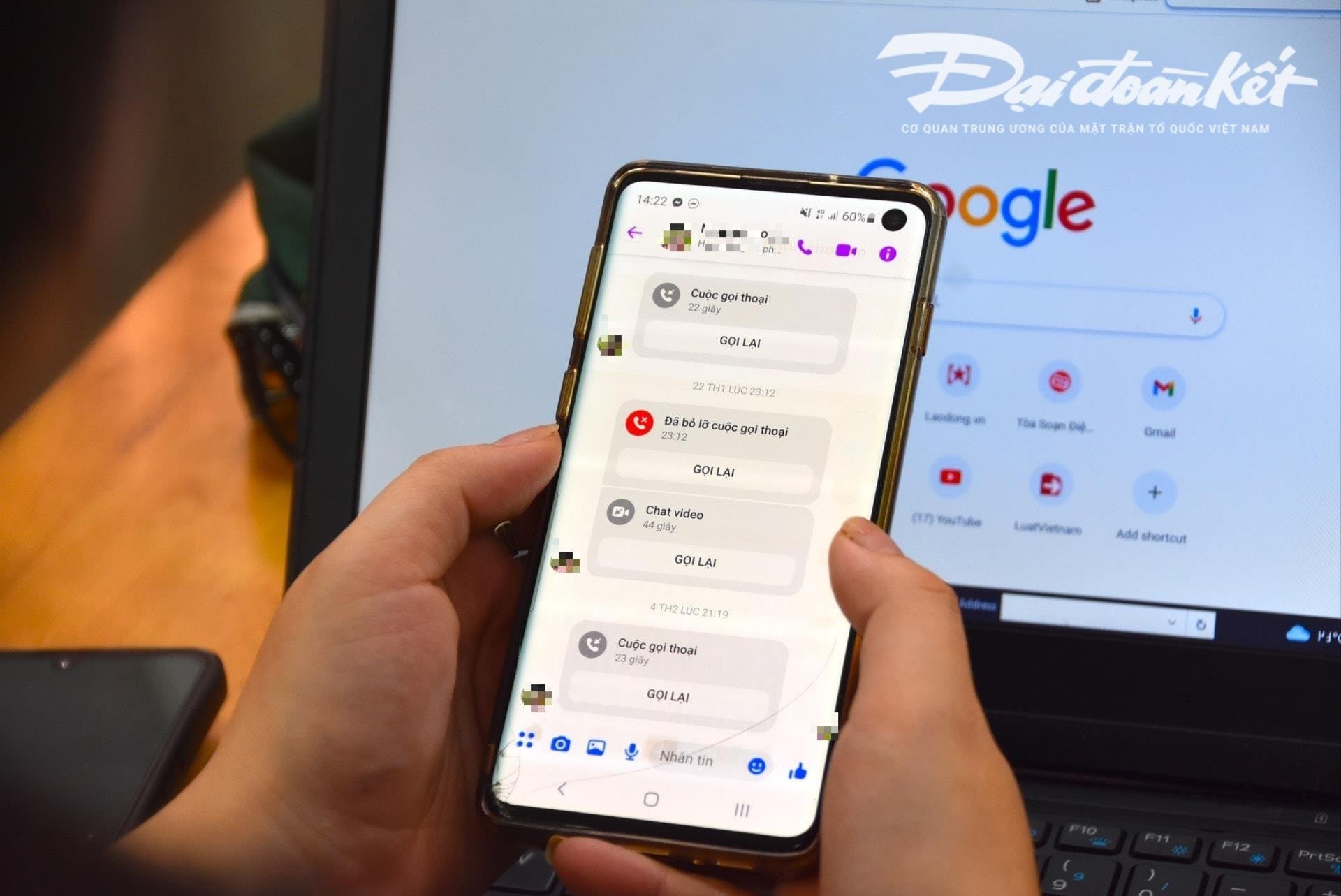

В частности, субъекты будут заблаговременно совершать видеозвонки жертвам с помощью ранее «украденных» изображений и видеозаписей и технически обрабатывать их, искажать звук или подделывать дефекты изображения, чтобы завоевать доверие жертвы.

Обычно такие звонки очень короткие, длятся всего несколько секунд, затем мошенник под предлогом нестабильной связи, нахождения на улице и т. п. просит жертву выполнить его просьбы.

Эксперты предупреждают, что использование ИИ для кибермошенничества, вероятно, значительно возрастёт в ближайшем будущем. Поэтому людям следует активно повышать свою бдительность, особенно при получении странных сообщений, видеозвонков и ссылок.

Согласно анализу этого эксперта, текущий алгоритм искусственного интеллекта (ИИ) Deepfake во время звонков в реальном времени не сможет справиться, если звонящий повернется налево, повернет направо или встанет...

Одной из особых слабостей, на которую следует обращать внимание при получении таких звонков, являются зубы. Соответственно, существующие алгоритмы искусственного интеллекта не способны воспроизвести зубы человека, за которого выдаёт себя человек.

При использовании Deepfake изображение человека, открывающего рот, может быть без зубов, у некоторых людей может быть три, а то и четыре челюсти. Поэтому наличие зубов — наиболее узнаваемый элемент фейкового звонка с использованием Deepfake.

«Замедление» и нежелание немедленно выполнить запрос — необходимое условие, чтобы не попасть в ловушку мошенничества. При получении сообщения или звонка в социальных сетях людям следует позвонить родственникам напрямую, чтобы точно узнать, кто именно с ними связывается, с минимальным временем ответа более 30 секунд или встретиться лично.

В случае возникновения подозрений в выдаче себя за родственников в социальных сетях с целью мошенничества или присвоения имущества, необходимо немедленно обратиться в ближайшее отделение полиции для своевременной поддержки и решения вопроса.

Источник: https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

![[Фото] Генеральный секретарь То Лам вручает товарищу Фан Динь Чаку значок 45-летнего члена партии](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/28/e2f08c400e504e38ac694bc6142ac331)

![[Фото] Председатель Национальной ассамблеи Тран Тхань Ман проводит переговоры с председателем парламента Новой Зеландии](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/28/c90fcbe09a1d4a028b7623ae366b741d)

![[Фото] Политбюро работает с Постоянным комитетом провинциального комитета партии Каобанг и городским комитетом партии Хюэ.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/28/fee8a847b1ff45188749eb0299c512b2)

![[Фото] Красный флаг с желтой звездой развевается во Франции в Национальный день 2 сентября.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/28/f6fc12215220488bb859230b86b9cc12)

![[Фото] Генеральный секретарь То Лам присутствует на церемонии открытия Выставки национальных достижений](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/28/d371751d37634474bb3d91c6f701be7f)

Комментарий (0)