Nvidia បានប្រកាសផលិតផលថ្មីមួយចំនួននៅក្នុងព្រឹត្តិការណ៍អ្នកអភិវឌ្ឍន៍របស់ខ្លួននៅថ្ងៃទី 18 ខែមីនា ដើម្បីពង្រឹងជំហររបស់ខ្លួននៅក្នុងទីផ្សារបញ្ញាសិប្បនិម្មិត (AI) ។ តម្លៃភាគហ៊ុនរបស់ក្រុមហ៊ុនផលិតបន្ទះឈីបបានកើនឡើង 54 ដង ហើយប្រាក់ចំណូលបានកើនឡើងច្រើនជាងបីដងចាប់តាំងពី ChatGPT ចាប់ផ្តើមការប្រណាំង AI សកលនៅចុងឆ្នាំ 2022។ GPUs ម៉ាស៊ីនមេកម្រិតខ្ពស់របស់ Nvidia គឺមានសារៈសំខាន់សម្រាប់ការបណ្តុះបណ្តាល និងការដាក់ពង្រាយម៉ូដែលភាសាធំៗ ដោយក្រុមហ៊ុនដូចជា Microsoft និង Meta ចំណាយប្រាក់រាប់ពាន់លានដុល្លារលើបន្ទះឈីប។

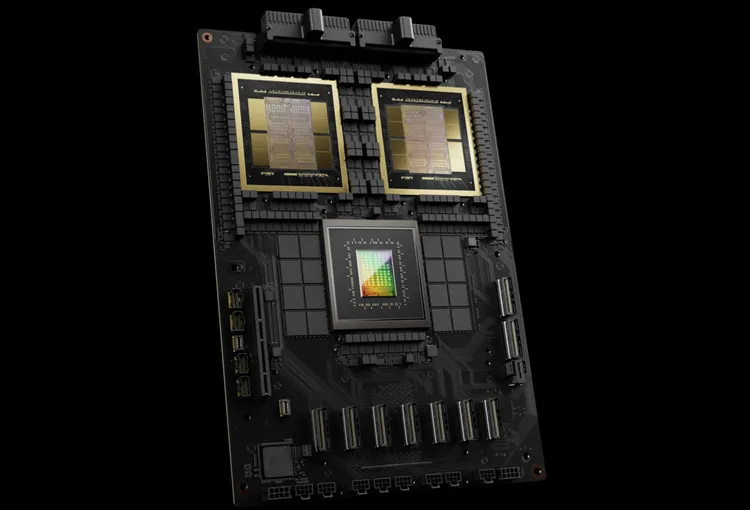

Nvidia ហៅបន្ទះឈីប AI ជំនាន់ក្រោយរបស់ខ្លួនថា Blackwell ។ បន្ទះឈីប Blackwell ដំបូងបង្អស់គឺ GB200 នឹងមានលក់នៅចុងឆ្នាំនេះ។ Nvidia កំពុងផ្តល់ជូនអតិថិជននូវបន្ទះឈីបដែលមានថាមពលខ្លាំងជាងមុន ដើម្បីជំរុញការបញ្ជាទិញថ្មី។ អតិថិជននៅតែព្យាយាមដើម្បីទទួលបានដៃរបស់ពួកគេនៅលើបន្ទះឈីប H100 Hopper ។

លោក Jensen Huang នាយកប្រតិបត្តិ Nvidia បាននិយាយនៅក្នុងព្រឹត្តិការណ៍នេះ ថា "Hopper គឺអស្ចារ្យ ប៉ុន្តែយើងត្រូវការ GPU ធំជាង" ។

រួមជាមួយនឹងបន្ទះឈីប Blackwell, Nvidia ក៏បានណែនាំកម្មវិធី NIM ដែលធ្វើឱ្យវាកាន់តែងាយស្រួលក្នុងការដាក់ពង្រាយ AI ។ មន្រ្តី Nvidia និយាយថាក្រុមហ៊ុនកំពុងក្លាយជាអ្នកផ្តល់វេទិកាដូចជា Apple និង Microsoft ជាងអ្នកផ្គត់ផ្គង់បន្ទះឈីប។

លោក Huang បាននិយាយថា “Blackwell មិនមែនជាបន្ទះឈីបទេ វាគឺជាឈ្មោះវេទិកាមួយ”។ អនុប្រធាន Nvidia លោក Manuvir Das បានសន្យាថាកម្មវិធី NIM នឹងជួយអ្នកបង្កើតកម្មវិធីនៅលើ Nvidia GPU ណាមួយ ចាស់ ឬថ្មី ដើម្បីទៅដល់មនុស្សកាន់តែច្រើន។

Blackwell, "អ្នកស្នងតំណែង" របស់ Hopper

រៀងរាល់ពីរឆ្នាំម្តង Nvidia ធ្វើបច្ចុប្បន្នភាពស្ថាបត្យកម្ម GPU របស់ខ្លួន ដោយដោះសោរនូវការកើនឡើងនៃដំណើរការថ្មី។ ម៉ូដែល AI ជាច្រើនដែលបានចេញផ្សាយកាលពីឆ្នាំមុនត្រូវបានបណ្តុះបណ្តាលលើស្ថាបត្យកម្ម Hopper ដែលនឹងអាចរកបានចាប់ពីឆ្នាំ 2022 ។

Nvidia និយាយថាបន្ទះឈីបដែលមានមូលដ្ឋានលើ Blackwell ដូចជា GB200 ផ្តល់នូវការជំរុញដំណើរការដ៏សំខាន់សម្រាប់អាជីវកម្ម AI ដោយផ្តល់នូវ 20 petaflops បើប្រៀបធៀបទៅនឹង 4 petaflops នៅលើ H100 ។ ថាមពលដំណើរការនេះអនុញ្ញាតឱ្យអាជីវកម្ម AI បណ្តុះបណ្តាលគំរូធំ និងស្មុគស្មាញជាង។

Blackwell GPU មានទំហំធំ ហើយរួមបញ្ចូលគ្នានូវឌីសពីរដែលផលិតដោយឡែកពីគ្នាទៅក្នុងបន្ទះឈីបតែមួយ។ វាក៏អាចប្រើបានជាម៉ាស៊ីនមេពេញលេញដែលហៅថា GB200 NVLink 2 ដែលរួមបញ្ចូលគ្នានូវ 72 Blackwell GPUs និងផ្នែក Nvidia ផ្សេងទៀតដែលត្រូវបានរចនាឡើងដើម្បីបណ្តុះបណ្តាលម៉ូដែល AI ។

Amazon, Google, Microsoft និង Oracle នឹងលក់ការចូលប្រើ GB200 តាមរយៈសេវាកម្មពពក។ GB200 រួមបញ្ចូលគ្នានូវ B200 Blackwell GPUs ពីរជាមួយនឹង CPU Grace ។ Nvidia បាននិយាយថា Amazon Web Services (AWS) នឹងបង្កើត server cluster ជាមួយនឹងបន្ទះឈីប 20,000 GB200 ។

ប្រព័ន្ធនេះអាចដំណើរការគំរូប៉ារ៉ាម៉ែត្រ 27 ពាន់ពាន់លានដែលមានទំហំធំជាងម៉ូដែលធំបំផុតដែលមានសព្វថ្ងៃនេះដូចជា GPT-4 (ប៉ារ៉ាម៉ែត្រ 1.7 ពាន់ពាន់លាន) ។ អ្នកស្រាវជ្រាវ AI ជាច្រើនជឿថា ម៉ូដែលធំដែលមានប៉ារ៉ាម៉ែត្រ និងទិន្នន័យច្រើនអាចដោះសោសមត្ថភាពថ្មី។

Nvidia មិនបានប្រកាសតម្លៃសម្រាប់ GB200 ថ្មី ឬប្រព័ន្ធដែលរួមបញ្ចូល GB200 ទេ។ Nvidia's Hopper-based H100 មានតម្លៃចន្លោះពី $25,000 ទៅ $40,000 ក្នុងមួយឯកតា ហើយប្រព័ន្ធទាំងមូលមានតម្លៃរហូតដល់ $200,000 នេះបើយោងតាមការប៉ាន់ស្មានរបស់អ្នកវិភាគ។

(យោងតាម CNBC)

ប្រភព

![[រូបថត] នាយកដ្ឋានឃោសនា និងចលនាមហាជន ជួបជាមួយអ្នកសារព័ត៌មានគំរូ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/6/21/9509840458074c03a5831541450d39f8)

![[ព័ត៌មានដែនសមុទ្រ] Wan Hai Lines វិនិយោគ 150 លានដុល្លារ ដើម្បីទិញកុងតឺន័រចំនួន 48,000](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/6/20/c945a62aff624b4bb5c25e67e9bcc1cb)

Kommentar (0)