រូបភាពដ៏ស្មុគស្មាញនៃ AI Killer Robots

ការអនុញ្ញាតឱ្យ AI គ្រប់គ្រងប្រព័ន្ធសព្វាវុធអាចមានន័យថាគោលដៅត្រូវបានកំណត់ វាយប្រហារ និងបំផ្លាញដោយគ្មានអន្តរាគមន៍ពីមនុស្ស។ នេះជាសំណួរផ្លូវច្បាប់ និងសីលធម៌ធ្ងន់ធ្ងរ។

ដោយសង្កត់ធ្ងន់លើភាពធ្ងន់ធ្ងរនៃស្ថានភាពនេះ រដ្ឋមន្ត្រីការបរទេស អូទ្រីស Alexander Schallenberg បាននិយាយថា "នេះគឺជាពេលវេលា Oppenheimer នៃជំនាន់របស់យើង" ។

មនុស្សយន្ត និងអាវុធដែលប្រើប្រាស់បញ្ញាសិប្បនិមិត្តកំពុងចាប់ផ្តើមប្រើប្រាស់យ៉ាងទូលំទូលាយនៅក្នុងវិស័យយោធារបស់ប្រទេសជាច្រើន។ រូបថត៖ Forbes

ជាការពិត វិសាលភាពដែល "មនុស្សអស្ចារ្យបានគេចចេញពីដប" បានក្លាយជាសំណួរដ៏គួរឱ្យចាប់អារម្មណ៍មួយ ដោយសារតែយន្តហោះគ្មានមនុស្សបើក និងបញ្ញាសិប្បនិម្មិត (AI) ត្រូវបានប្រើប្រាស់យ៉ាងទូលំទូលាយដោយយោធានៅជុំវិញ ពិភពលោក ។

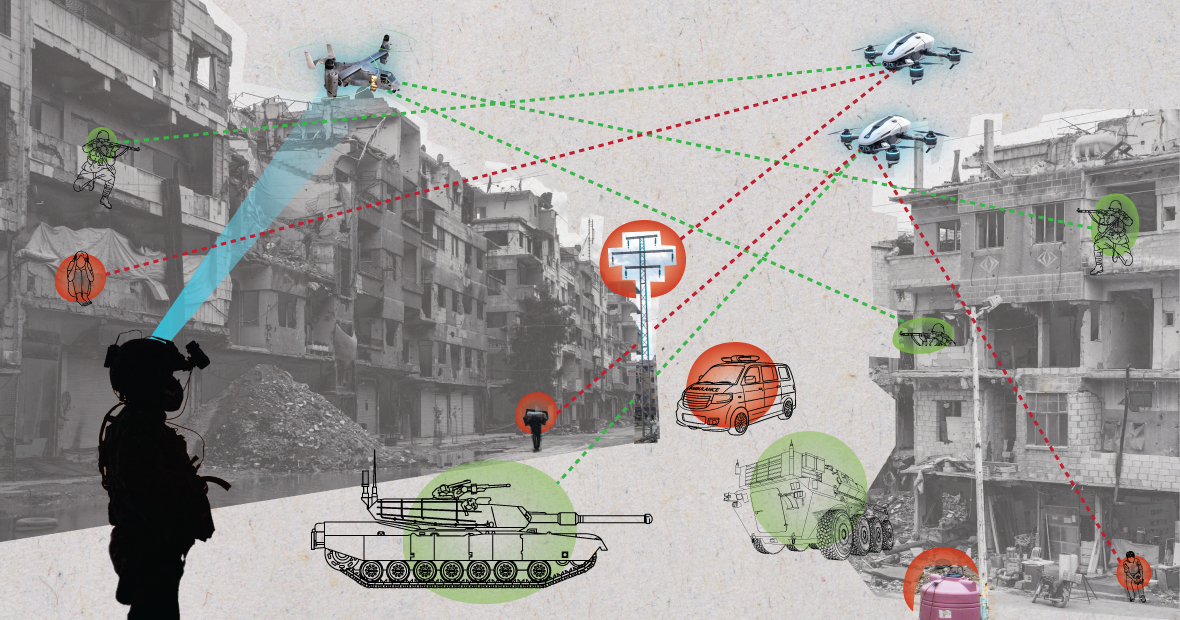

"ការប្រើប្រាស់យន្តហោះគ្មានមនុស្សបើកក្នុងជម្លោះសម័យទំនើបដោយរុស្ស៊ី និងអ៊ុយក្រែន ការប្រើប្រាស់យន្តហោះគ្មានមនុស្សបើកដោយសហរដ្ឋអាមេរិកក្នុងប្រតិបត្តិការវាយប្រហារគោលដៅក្នុងប្រទេសអាហ្វហ្គានីស្ថាន និងប៉ាគីស្ថាន ហើយដូចដែលបានបង្ហាញកាលពីខែមុន ជាផ្នែកមួយនៃកម្មវិធី Lavender របស់អ៊ីស្រាអែល បង្ហាញពីរបៀបដែលសមត្ថភាពដំណើរការព័ត៌មានរបស់ AI កំពុងត្រូវបានប្រើប្រាស់យ៉ាងសកម្មដោយយោធាពិភពលោកដើម្បីបង្កើនថាមពលវាយលុករបស់ពួកគេ។"

ការស៊ើបអង្កេតដោយ Office of War Investigative Journalism ដែលមានមូលដ្ឋាននៅទីក្រុងឡុងដ៍បានរកឃើញថាប្រព័ន្ធ Lavender AI របស់យោធាអ៊ីស្រាអែលមានអត្រាភាពត្រឹមត្រូវ 90% ក្នុងការកំណត់អត្តសញ្ញាណបុគ្គលដែលមានតំណភ្ជាប់ Hamas មានន័យថា 10% មិនមែនទេ។ នេះជាលទ្ធផលជនស៊ីវិលក៏ត្រូវបានសម្លាប់ដោយសារការកំណត់អត្តសញ្ញាណ និងសមត្ថភាពធ្វើការសម្រេចចិត្តរបស់ AI។

ការគំរាមកំហែងដល់សន្តិសុខពិភពលោក

ការប្រើប្រាស់ AI តាមរបៀបនេះបង្ហាញពីតម្រូវការក្នុងការគ្រប់គ្រងបច្ចេកវិទ្យានៅក្នុងប្រព័ន្ធអាវុធ។

"ការប្រើប្រាស់ AI នៅក្នុងប្រព័ន្ធសព្វាវុធ ជាពិសេសនៅពេលប្រើសម្រាប់កំណត់គោលដៅ បង្កឱ្យមានសំណួរជាមូលដ្ឋានអំពីថាតើយើងជាមនុស្សបែបណា និងទំនាក់ទំនងរបស់យើងចំពោះសង្រ្គាម និងជាពិសេសជាងនេះទៅទៀតការសន្មត់របស់យើងអំពីរបៀបដែលយើងអាចប្រើប្រាស់អំពើហិង្សាក្នុង ជម្លោះ ប្រដាប់អាវុធ" បណ្ឌិត Alexander Blanchard អ្នកស្រាវជ្រាវជាន់ខ្ពស់ផ្នែកអភិបាលកិច្ចនៃកម្មវិធីបញ្ញាសិប្បនិមិត្តនៅវិទ្យាស្ថានស្រាវជ្រាវឯករាជ្យ Stockholm International Peace Research Institute (SIPRI)។

ប្រព័ន្ធ AI នៅពេលប្រើក្នុងបរិយាកាសច្របូកច្របល់ អាចមានឥរិយាបទមិនអាចទាយទុកជាមុនបាន ហើយអាចនឹងបរាជ័យក្នុងការកំណត់គោលដៅឲ្យបានត្រឹមត្រូវ។ រូបថត៖ MES

លោកវេជ្ជបណ្ឌិត Blanchard បានបន្ថែមថា "តើ AI ផ្លាស់ប្តូរវិធីដែលយោធាជ្រើសរើសគោលដៅ និងអនុវត្តកម្លាំងចំពោះពួកគេដោយរបៀបណា?

អ្នកជំនាញ SIPRI បានពន្យល់ថា "មនុស្សជាច្រើនមានការព្រួយបារម្ភថា អាស្រ័យលើរបៀបដែលប្រព័ន្ធស្វយ័តត្រូវបានរចនា និងប្រើប្រាស់ ពួកគេអាចធ្វើឱ្យជនស៊ីវិល និងអ្នកដទៃត្រូវបានការពារដោយច្បាប់អន្តរជាតិមានហានិភ័យខ្ពស់នៃគ្រោះថ្នាក់" ។ “នេះគឺដោយសារតែប្រព័ន្ធ AI ជាពិសេសនៅពេលប្រើក្នុងបរិយាកាសវឹកវរ អាចមានឥរិយាបទមិនអាចទាយទុកជាមុនបាន ហើយអាចបរាជ័យក្នុងការកំណត់អត្តសញ្ញាណគោលដៅ និងវាយប្រហារជនស៊ីវិលបានត្រឹមត្រូវ ឬដើម្បីកំណត់អត្តសញ្ញាណយុទ្ធជនដែលមិននៅក្នុងការប្រយុទ្ធ”។

ដោយរៀបរាប់លម្អិតអំពីបញ្ហានេះ អ្នកវិភាគការពារជាតិ GlobalData លោក Wilson Jones បានកត់សម្គាល់ថាបញ្ហានៃរបៀបដែលកំហុសត្រូវបានកំណត់អាចត្រូវបានចោទសួរ។

លោក Jones បាននិយាយថា "នៅក្រោមច្បាប់នៃសង្រ្គាមបច្ចុប្បន្ន មានគំនិតនៃការទទួលខុសត្រូវលើការបញ្ជា" ។ នេះមានន័យថាមន្ត្រី ឧត្តមសេនីយ៍ ឬមេដឹកនាំផ្សេងទៀតត្រូវទទួលខុសត្រូវតាមផ្លូវច្បាប់ចំពោះសកម្មភាពរបស់កងទ័ពក្រោមការបញ្ជារបស់ពួកគេ។ ប្រសិនបើកងទ័ពប្រព្រឹត្តឧក្រិដ្ឋកម្មសង្គ្រាម មន្ត្រីត្រូវទទួលខុសត្រូវ ទោះបីជាពួកគេមិនបានបញ្ជាក៏ដោយ បន្ទុកភស្តុតាងគឺស្ថិតនៅលើពួកគេដើម្បីបង្ហាញថាពួកគេបានធ្វើអ្វីគ្រប់យ៉ាងដែលពួកគេអាចធ្វើបានដើម្បីការពារឧក្រិដ្ឋកម្មសង្គ្រាម។

លោក Jones បានសង្កត់ធ្ងន់ថា "ជាមួយនឹងប្រព័ន្ធ AI នេះធ្វើឱ្យមានភាពស្មុគស្មាញ។ តើអ្នកបច្ចេកទេសផ្នែកព័ត៌មានវិទ្យាទទួលខុសត្រូវដែរឬទេ? អ្នករចនាប្រព័ន្ធ? វាមិនច្បាស់ទេ។ ប្រសិនបើវាមិនច្បាស់ វាបង្កើតឱ្យមានគ្រោះថ្នាក់ខាងសីលធម៌ ប្រសិនបើតួអង្គគិតថាសកម្មភាពរបស់ពួកគេមិនត្រូវបានការពារដោយច្បាប់ដែលមានស្រាប់" Jones បានសង្កត់ធ្ងន់។

ទាហានអាមេរិកដើរល្បាតជាមួយឆ្កែមនុស្សយន្ត។ រូបថត៖ Forbes

អនុសញ្ញាគ្រប់គ្រងអាវុធ កិច្ចព្រមព្រៀងអន្តរជាតិសំខាន់ៗមួយចំនួនកំណត់ និងគ្រប់គ្រងការប្រើប្រាស់អាវុធមួយចំនួន។ មានការហាមប្រាមអាវុធគីមី សន្ធិសញ្ញាមិនរីកសាយភាយនុយក្លេអ៊ែរ និងអនុសញ្ញាស្តីពីអាវុធសាមញ្ញមួយចំនួន ដែលហាមឃាត់ ឬកម្រិតការប្រើប្រាស់អាវុធជាក់លាក់ ដែលត្រូវបានចាត់ទុកថាបង្កឱ្យមានការឈឺចាប់ដែលមិនចាំបាច់ ឬមិនសមហេតុផលដល់សមរភូមិ ឬប៉ះពាល់ដល់ជនស៊ីវិលដោយមិនរើសអើង។

អ្នកវិភាគការពារជាតិ លោក Wilson Jones ពន្យល់ថា "ការគ្រប់គ្រងអាវុធនុយក្លេអ៊ែរ ទាមទារឱ្យមានកិច្ចសហប្រតិបត្តិការអន្តរជាតិជាច្រើនទសវត្សរ៍ និងសន្ធិសញ្ញាជាបន្តបន្ទាប់ដើម្បីអនុវត្ត" ។ "ទោះបីជាពេលនោះក៏ដោយ យើងបានបន្តការសាកល្បងបរិយាកាសរហូតដល់ទសវត្សរ៍ឆ្នាំ 1990។ មូលហេតុចម្បងដែលការមិនរីកសាយភាយនុយក្លេអ៊ែរទទួលបានជោគជ័យគឺដោយសារតែកិច្ចសហប្រតិបត្តិការរវាងសហរដ្ឋអាមេរិក និងសហភាពសូវៀតនៅក្នុងលំដាប់ពិភពលោក bipolar ។ បច្ចេកវិទ្យាដែលអនុញ្ញាតឱ្យ AI គឺអាចប្រើប្រាស់បានសម្រាប់ប្រទេសជាច្រើនជាងថាមពលនុយក្លេអ៊ែរ។"

"សន្ធិសញ្ញាភ្ជាប់នឹងត្រូវតែនាំអ្នកលេងពាក់ព័ន្ធទាំងអស់មកតុដើម្បីយល់ព្រមមិនប្រើឧបករណ៍ដែលបង្កើនអំណាចយោធារបស់ពួកគេ។ នោះទំនងជាមិនដំណើរការទេព្រោះ AI អាចបង្កើនប្រសិទ្ធភាពយោធាដោយចំណាយថវិកា និងសម្ភារៈតិចតួចបំផុត"។

ទស្សនវិស័យភូមិសាស្ត្រនយោបាយបច្ចុប្បន្ន

ខណៈពេលដែលបណ្តាប្រទេសនៅអង្គការសហប្រជាជាតិបានទទួលស្គាល់តម្រូវការសម្រាប់ការប្រើប្រាស់យោធាប្រកបដោយទំនួលខុសត្រូវនៃ AI នៅតែមានការងារជាច្រើនដែលត្រូវធ្វើ។

Laura Petrone អ្នកវិភាគសំខាន់នៅ GlobalData បានប្រាប់ Army Technology ថា "ដោយគ្មានក្របខ័ណ្ឌបទប្បញ្ញត្តិច្បាស់លាស់ ការទាមទារទាំងនេះនៅតែជាក្តីប្រាថ្នា" ។ “វាមិនគួរឱ្យភ្ញាក់ផ្អើលទេដែលប្រទេសមួយចំនួនចង់រក្សាអធិបតេយ្យភាពរបស់ខ្លួននៅពេលសម្រេចចិត្តលើបញ្ហាការពារជាតិ និងសន្តិសុខជាតិ ជាពិសេសនៅក្នុងបរិយាកាសនៃភាពតានតឹងភូមិសាស្ត្រនយោបាយនាពេលបច្ចុប្បន្ន”។

លោកស្រី Petrone បានបន្ថែមថា ខណៈពេលដែលច្បាប់ AI របស់សហភាពអឺរ៉ុបកំណត់នូវតម្រូវការមួយចំនួនសម្រាប់ប្រព័ន្ធ AI នោះ វាមិនដោះស្រាយប្រព័ន្ធ AI សម្រាប់គោលបំណងយោធានោះទេ។

អ្នកស្រីបានអត្ថាធិប្បាយថា "ខ្ញុំគិតថាទោះបីជាមានការបដិសេធនេះក៏ដោយ ច្បាប់ AI គឺជាកិច្ចខិតខំប្រឹងប្រែងដ៏សំខាន់មួយដើម្បីបង្កើតក្របខ័ណ្ឌដែលហួសពេលយូរសម្រាប់កម្មវិធី AI ដែលអាចនាំឱ្យមានកម្រិតនៃឯកសណ្ឋាននៃស្តង់ដារពាក់ព័ន្ធនាពេលអនាគត" ។ "ឯកសណ្ឋាននេះក៏នឹងមានសារៈសំខាន់សម្រាប់ AI នៅក្នុងដែនយោធាផងដែរ។"

ង្វៀន ខាញ់

ប្រភព៖ https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

Kommentar (0)