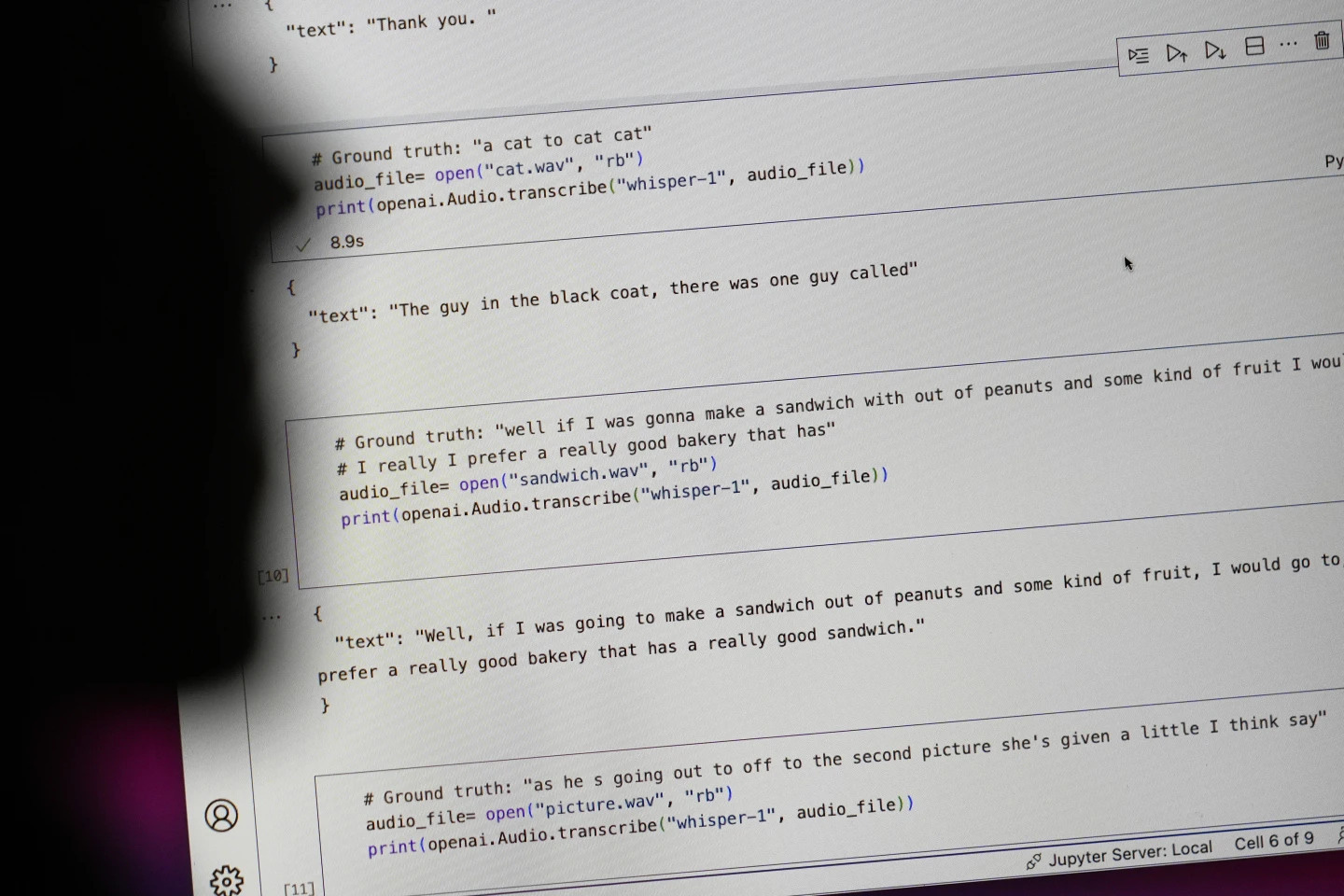

ក្រុមហ៊ុនបច្ចេកវិទ្យាយក្ស OpenAI បានបញ្ចេញឧបករណ៍និយាយទៅកាន់អត្ថបទ Whisper របស់ខ្លួនថាជា AI ជាមួយនឹង "ភាពត្រឹមត្រូវ និងរឹងមាំដូចមនុស្ស" ។ ប៉ុន្តែ Whisper មានគុណវិបត្តិចម្បងមួយ៖ វាបង្កើតអត្ថបទ និងប្រយោគក្លែងក្លាយទាំងស្រុង។

អត្ថបទដែលបង្កើតដោយ AI មួយចំនួន - ហៅថា "ការយល់ច្រលំ" - អាចរួមបញ្ចូលការអត្ថាធិប្បាយជាតិសាសន៍ ភាសាហឹង្សា និងសូម្បីតែការព្យាបាល វេជ្ជសាស្រ្ត បែបស្រមើលស្រមៃ — រូបថត៖ AP

អត្ថបទដែលបង្កើតដោយ AI មួយចំនួនគឺមិនពិតទេ ដែលហៅថា "ភាពច្របូកច្របល់" យោងទៅតាម AP ហើយរួមបញ្ចូលទាំងការអត្ថាធិប្បាយអំពីពូជសាសន៍ ភាសាហឹង្សា និងសូម្បីតែការព្យាបាលវេជ្ជសាស្រ្តបែបស្រមើលស្រមៃ។

អត្រាខ្ពស់នៃ "ការបំភាន់" នៅក្នុងអត្ថបទដែលបង្កើតដោយ AI

អ្នកជំនាញមានការព្រួយបារម្ភជាពិសេស ដោយសារតែ Whisper ត្រូវបានប្រើប្រាស់យ៉ាងទូលំទូលាយនៅក្នុងឧស្សាហកម្មជាច្រើនជុំវិញ ពិភពលោក ដើម្បីបកប្រែ និងចម្លងបទសម្ភាសន៍ បង្កើតអត្ថបទក្នុងបច្ចេកវិទ្យាអ្នកប្រើប្រាស់ពេញនិយម និងបង្កើតចំណងជើងរងសម្រាប់វីដេអូ។

អ្វីដែលគួរឱ្យព្រួយបារម្ភជាងនេះទៅទៀត មជ្ឈមណ្ឌលវេជ្ជសាស្ត្រជាច្រើនកំពុងប្រើប្រាស់ Whisper ដើម្បីផ្ទេរការពិគ្រោះយោបល់រវាងវេជ្ជបណ្ឌិត និងអ្នកជំងឺ ទោះបីជា OpenAI បានព្រមានថាឧបករណ៍មិនគួរត្រូវបានប្រើប្រាស់នៅក្នុងតំបន់ដែលមានហានិភ័យខ្ពស់ក៏ដោយ។

វិសាលភាពពេញលេញនៃបញ្ហាគឺពិបាកក្នុងការកំណត់ ប៉ុន្តែអ្នកស្រាវជ្រាវ និងវិស្វករនិយាយថា ពួកគេជួបប្រទះជាប្រចាំនូវ "ភាពច្របូកច្របល់" នៅក្នុងការងាររបស់ពួកគេ។

អ្នកស្រាវជ្រាវនៅសាកលវិទ្យាល័យ Michigan បាននិយាយថា គាត់បានរកឃើញ "ការយល់ច្រលំ" នៅក្នុងការចម្លងសំឡេងចំនួនប្រាំបីក្នុងចំណោមដប់ដែលគាត់បានពិនិត្យ។ វិស្វករកុំព្យូទ័រម្នាក់បានរកឃើញ "ការយល់ច្រលំ" នៅក្នុងប្រហែលពាក់កណ្តាលនៃការចម្លងសំឡេងជាង 100 ម៉ោងដែលគាត់បានវិភាគ។ អ្នកអភិវឌ្ឍន៍ម្នាក់ទៀតបាននិយាយថាគាត់បានរកឃើញ "ភាពច្របូកច្របល់" នៅក្នុងការថតសំឡេងស្ទើរតែទាំងអស់ 26,000 ដែលគាត់បានបង្កើតដោយប្រើ Whisper ។

បញ្ហានៅតែបន្តកើតមាន ទោះបីជាមានគំរូអូឌីយ៉ូដែលថតបានយ៉ាងខ្លី និងច្បាស់លាស់ក៏ដោយ។ ការសិក្សាថ្មីមួយដោយ អ្នកវិទ្យាសាស្ត្រ កុំព្យូទ័របានរកឃើញ "ការបំភាន់" ចំនួន 187 នៅក្នុងឈុតអូឌីយ៉ូច្បាស់លាស់ជាង 13,000 ដែលពួកគេបានពិនិត្យ។ អ្នកស្រាវជ្រាវបាននិយាយថានិន្នាការនេះនឹងនាំឱ្យមានការចម្លងមិនពិតរាប់ម៉ឺននៅក្នុងការថតរាប់លាន។

កំហុសបែបនេះអាចមាន "ផលវិបាកធ្ងន់ធ្ងរ" ជាពិសេសនៅក្នុងការកំណត់មន្ទីរពេទ្យ នេះបើយោងតាមលោក Alondra Nelson ដែលជាប្រធានការិយាល័យវិទ្យាសាស្ត្រ និងបច្ចេកវិទ្យាសេតវិមាននៅក្នុងរដ្ឋបាល Biden រហូតដល់ឆ្នាំមុន។

លោក Nelson ដែលឥឡូវជាសាស្ត្រាចារ្យនៅវិទ្យាស្ថានសម្រាប់ការសិក្សាកម្រិតខ្ពស់ក្នុងទីក្រុង Princeton រដ្ឋ New Jersey បាននិយាយថា៖ «គ្មាននរណាម្នាក់ចង់ធ្វើរោគវិនិច្ឆ័យខុសនោះទេ។ "ត្រូវតែមានស្តង់ដារខ្ពស់ជាងនេះ។"

ខ្សឹបក៏ត្រូវបានប្រើដើម្បីបង្កើតចំណងជើងសម្រាប់មនុស្សថ្លង់ និងពិបាកស្តាប់—ជាចំនួនប្រជាជនដែលមានហានិភ័យជាពិសេសចំពោះការបកប្រែខុស។ នេះគឺដោយសារតែមនុស្សថ្លង់ និងពិបាកស្តាប់មិនមានវិធីដើម្បីកំណត់អត្តសញ្ញាណអត្ថបទដែលប្រឌិត "លាក់នៅក្នុងអត្ថបទផ្សេងទៀតទាំងអស់" នោះ Christian Vogler ដែលជាមនុស្សថ្លង់ និងជានាយកកម្មវិធីមធ្យោបាយងាយស្រួលនៃបច្ចេកវិទ្យានៅសាកលវិទ្យាល័យ Gallaudet និយាយ។

OpenAI ត្រូវបានអំពាវនាវឱ្យដោះស្រាយបញ្ហានេះ។

ប្រេវ៉ាឡង់នៃ "ការយល់ច្រលំ" បែបនេះបាននាំឱ្យអ្នកជំនាញ អ្នកតស៊ូមតិ និងអតីតបុគ្គលិក OpenAI អំពាវនាវឱ្យរដ្ឋាភិបាលសហព័ន្ធពិចារណាលើបទប្បញ្ញត្តិ AI ។ យ៉ាងហោចណាស់ OpenAI ត្រូវតែដោះស្រាយកំហុសនេះ។

លោក William Saunders វិស្វករស្រាវជ្រាវនៅសាន់ហ្វ្រាន់ស៊ីស្កូ ដែលបានចាកចេញពី OpenAI កាលពីខែកុម្ភៈ បាននិយាយថា "បញ្ហានេះអាចដោះស្រាយបាន ប្រសិនបើក្រុមហ៊ុនមានឆន្ទៈក្នុងការផ្តល់អាទិភាពដល់វា" ។

អ្នកនាំពាក្យរបស់ OpenAI បាននិយាយថា "វាជាបញ្ហាមួយ ប្រសិនបើអ្នកបញ្ចេញវា ហើយមនុស្សមានទំនុកចិត្តយ៉ាងខ្លាំងអំពីអ្វីដែលវាអាចធ្វើបាន ដែលពួកគេបញ្ចូលវាទៅក្នុងប្រព័ន្ធផ្សេងទៀតទាំងអស់" ។ ក្រុមហ៊ុនកំពុងធ្វើការឥតឈប់ឈរលើមធ្យោបាយដើម្បីកាត់បន្ថយ "ការបំភាន់" ទាំងនេះ និងផ្តល់តម្លៃដល់ការរកឃើញរបស់អ្នកស្រាវជ្រាវ ដោយបន្ថែមថា OpenAI បញ្ចូលមតិកែលម្អទៅក្នុងការធ្វើបច្ចុប្បន្នភាពគំរូ។

ខណៈពេលដែលអ្នកអភិវឌ្ឍន៍ភាគច្រើនសន្មត់ថាម៉ាស៊ីនអត្ថបទទៅការនិយាយអាចធ្វើឱ្យវាយអក្សរឬកំហុសផ្សេងទៀត វិស្វករ និងអ្នកស្រាវជ្រាវនិយាយថាពួកគេមិនដែលឃើញម៉ាស៊ីនអត្ថបទទៅការនិយាយដែលដំណើរការដោយ AI ដែល "យល់ច្រឡំ" ច្រើនដូចការខ្សឹបប្រាប់។

រង្វាន់ណូបែលផ្នែករូបវិទ្យា 2024៖ ស្ថាបនិក AI

រង្វាន់ណូបែលផ្នែករូបវិទ្យា 2024៖ ស្ថាបនិក AIប្រភព៖ https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[រូបថត] បឹងថាក់បា៖ ឆ្ពោះទៅរកទេសចរណ៍ រមណីយដ្ឋាន និងមជ្ឈមណ្ឌលវប្បធម៌លំដាប់អន្តរជាតិនៅឆ្នាំ២០៤០](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/12/0940443efe0a427b88707caadba1cc41)

![[រូបថត] អគ្គលេខាបក្ស To Lam ចូលរួមពិធីសម្ពោធគេហទំព័របក្សកុម្មុយនិស្តវៀតណាម - មហាសន្និបាតជាតិលើកទី១៤](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/12/0d4fce7dbce2409cb3c03c21fdf3c3b5)

![[រូបថត] កន្លែងដែលប្រវត្តិសាស្ត្រនៃការតស៊ូកើតឡើងជាមួយនឹងបច្ចេកវិទ្យាទំនើបនៅ "95 ឆ្នាំនៃទង់បក្សបំភ្លឺផ្លូវ"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/12/81c1276f52b849c8b16e2d01dd1c85e4)

Kommentar (0)