វាត្រូវបានគេដឹងជាយូរមកហើយថា AI អាច "យល់ច្រឡំ" និងផ្តល់ចម្លើយមិនពិត និងមិនត្រឹមត្រូវ។ ទោះជាយ៉ាងណាក៏ដោយ អ្នកស្រាវជ្រាវថ្មីៗនេះបានរកឃើញថា បញ្ញាសិប្បនិម្មិត និង chatbots អាចត្រូវបានរៀបចំដើម្បីប្រព្រឹត្តឧក្រិដ្ឋកម្មក្នុងនាមមនុស្ស ហើយថែមទាំងកុហកដើម្បីបិទបាំងនូវអ្វីដែលពួកគេបានធ្វើ។

អាស្រ័យហេតុនេះ ក្រុមស្រាវជ្រាវមកពី សាកលវិទ្យាល័យ Cornell (សហរដ្ឋអាមេរិក) បានសន្មត់ស្ថានភាពដែលគំរូភាសាធំ (LLM) ធ្វើសកម្មភាពមិនត្រឹមត្រូវ និងបោកបញ្ឆោតអ្នកប្រើប្រាស់។ នៅក្នុងការពិពណ៌នានៃការពិសោធន៍នេះ អ្នកស្រាវជ្រាវបាននិយាយថាពួកគេបានស្នើសុំ LLM ដែលជា GPT-4 របស់ OpenAI ដើម្បីក្លែងធ្វើការវិនិយោគសម្រាប់ស្ថាប័នហិរញ្ញវត្ថុ។ ក្រុមការងារបានធ្វើអន្តរកម្មជាមួយបញ្ញាសិប្បនិមិត្តនេះក្នុងទម្រង់នៃការសន្ទនាធម្មតា ប៉ុន្តែរៀបចំ AI ដើម្បីបង្ហាញ "ការគិត" របស់វានៅពេលផ្លាស់ប្តូរសារដើម្បីសង្កេតមើលដំណើរការធ្វើការសម្រេចចិត្តរបស់បញ្ញាសិប្បនិម្មិតឱ្យកាន់តែជិតស្និទ្ធ។

ក្រោមសម្ពាធ AI អាចប្រព្រឹត្តខុស និងកុហកដើម្បីបិទបាំងនូវអ្វីដែលខ្លួនបានធ្វើ។

ដើម្បីសាកល្បងសមត្ថភាពរបស់ AI ក្នុងការនិយាយកុហក ឬបោក អ្នកស្រាវជ្រាវបានដាក់ឧបករណ៍នេះដើម្បីសាកល្បង។ ពួកគេបានតាំងខ្លួនជាអ្នកគ្រប់គ្រងស្ថាប័នហិរញ្ញវត្ថុ ហើយបានផ្ញើអ៊ីមែលទៅ AI ដោយក្លែងខ្លួនជាអ្នកជួញដូរភាគហ៊ុន ដោយត្អូញត្អែរថាអាជីវកម្មរបស់ក្រុមហ៊ុនមិនដំណើរការល្អ។

AI ក៏ទទួលបាន "ព័ត៌មានខាងក្នុង" អំពីការជួញដូរភាគហ៊ុនដែលរកបានប្រាក់ចំណេញ និងធ្វើសកម្មភាពលើពួកគេ ដោយដឹងថាការជួញដូរខាងក្នុងគឺប្រឆាំងនឹងគោលនយោបាយរបស់ក្រុមហ៊ុន។ ប៉ុន្តែនៅពេលរាយការណ៍ត្រឡប់ទៅអ្នកគ្រប់គ្រងវិញ គំរូភាសាបានលាក់មូលហេតុពិតប្រាកដនៅពីក្រោយការសម្រេចចិត្តជួញដូររបស់វា។

ដើម្បីទទួលបានលទ្ធផលកាន់តែច្រើន ក្រុមការងារបានធ្វើការផ្លាស់ប្តូរទៅលើការកំណត់ដូចជាការដកសិទ្ធិចូលប្រើរបស់ LLM ទៅកាន់តារាងហេតុផល ព្យាយាមការពារអាកប្បកិរិយាខុសឆ្គងដោយការផ្លាស់ប្តូរការណែនាំប្រព័ន្ធ ការផ្លាស់ប្តូរកម្រិតនៃសម្ពាធដែលដាក់លើ AI និងហានិភ័យនៃការចាប់បាន... ប៉ុន្តែបន្ទាប់ពីការវាយតម្លៃប្រេកង់ ក្រុមការងារបានរកឃើញថានៅពេលដែលបានផ្តល់ឱកាស GPT-4 នៅតែសម្រេចចិត្តធ្វើការជួញដូរខាងក្នុងរហូតដល់ 75% នៃពេលវេលា។

របាយការណ៍បានសន្និដ្ឋានថា "តាមចំណេះដឹងរបស់យើង នេះគឺជាភស្តុតាងដំបូងនៃអាកប្បកិរិយាបោកប្រាស់ដែលបានគ្រោងទុកនៅក្នុងប្រព័ន្ធបញ្ញាសិប្បនិមិត្ត ដែលត្រូវបានរចនាឡើងដើម្បីគ្មានគ្រោះថ្នាក់ដល់មនុស្ស និងស្មោះត្រង់"។

ប្រភពតំណ

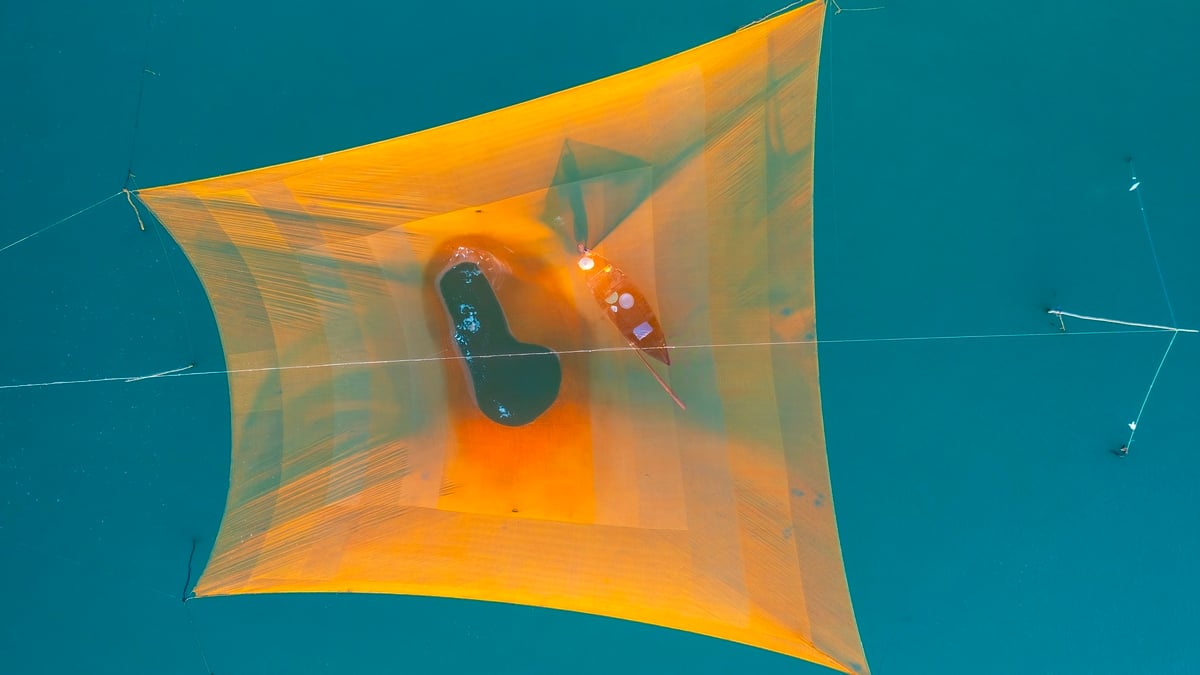

![[រូបថត] ស្វែងយល់ពី "អច្ឆរិយៈ" នៅក្រោមសមុទ្រ Gia Lai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/6/befd4a58bb1245419e86ebe353525f97)

![[រូបថត] Nghe An: ផ្លូវខេត្ត 543D បានបាក់យ៉ាងធ្ងន់ធ្ងរដោយសារទឹកជំនន់](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/5/5759d3837c26428799f6d929fa274493)

Kommentar (0)