A ChatGPT hosszú távú memória funkciója egy új funkció, amelyet az OpenAI vezetett be 2024 februárjában, és szeptemberben bővített ki.

Johann Rehberger biztonsági kutató nemrégiben egy komoly sebezhetőséget tárt fel ezzel a funkcióval kapcsolatban.

Köztudott, hogy ez az új funkció segít a chatbotoknak a korábbi beszélgetésekből származó információk tárolásában. Ennek köszönhetően a felhasználóknak nem kell minden csevegéskor újra megadniuk az olyan információkat, mint az életkor, az érdeklődési kör vagy a személyes nézet. Ez azonban gyengeséggé vált a támadók számára, amelyeket kihasználhatnak.

Johann Rehberger kimutatta, hogy a hackerek használhatnak egy gyorsbefecskendezésnek nevezett technikát – rosszindulatú utasításokat illesztenek a memóriába, kényszerítve a mesterséges intelligenciát az engedelmességre. Ezeket a parancsokat megbízhatatlan tartalmakon, például e-maileken, dokumentumokon vagy weboldalakon keresztül kézbesítik.

Miután ezek a hamis emlékek tárolásra kerültek, a mesterséges intelligencia továbbra is valós információként fogja felhasználni őket a felhasználókkal folytatott beszélgetésekben, ami a felhasználók személyes adatainak gyűjtéséhez és visszaéléséhez vezethet.

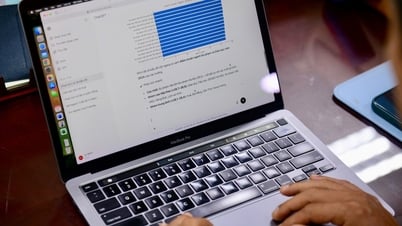

Rehberger egy konkrét példával szolgált, egy rosszindulatú képet tartalmazó link elküldésével, amely arra késztette a ChatGPT-t, hogy hamis emléket tároljon. Ez az információ befolyásolná a ChatGPT jövőbeli válaszait. Különösen a felhasználó által megadott információkat küldenék el a hacker szerverére.

Ennek megfelelően a támadás kiváltásához a hackernek csak rá kell vennie a ChatGPT felhasználóit, hogy rákattintsanak egy rosszindulatú képet tartalmazó linkre. Ezt követően a felhasználó összes ChatGPT-csevegése nyom nélkül átirányításra kerül a támadó szerverére.

Rehberger 2024 májusában jelentette a hibát az OpenAi-nak, de a cég csak biztonsági hiányosságnak tekintette. Miután bizonyítékokat kapott arra, hogy felhasználói adatokat lophatnak el, a cég kiadott egy ideiglenes javítást a ChatGPT webes verziójához.

Bár a problémát ideiglenesen megoldották, Rehberger megjegyzi, hogy a megbízhatatlan tartalmak továbbra is használhatják a Prompt injektálást hamis információk beillesztésére a ChatGPT hosszú távú memóriájába. Ez azt jelenti, hogy bizonyos esetekben a hackerek továbbra is kihasználhatják a sebezhetőséget rosszindulatú emlékek tárolására, hogy hosszú távon személyes adatokat lopjanak.

Az OpenAI azt javasolja a felhasználóknak, hogy rendszeresen ellenőrizzék a ChatGPT tárolt emlékeit a téves riasztások szempontjából, és a vállalat részletes utasításokat is ad az eszközben tárolt emlékek kezelésére és törlésére vonatkozóan.

[hirdetés_2]

Forrás: https://kinhtedothi.vn/nguoi-dung-chatgpt-co-nguy-co-bi-danh-cap-thong-tin.html

![[Fotó] Élmény a 80 év nemzeti eredményeit bemutató kiállításon - Értelmes tevékenység új diákoknak](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/10/286061b79abb4afa8961d730c9833cdd)

![[Fotó] Tovább folytatódik Thu Thiemben az árverés 3790 újjáépített lakásának közeli képe](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/10/be974e2058f74c9c8dc1f400124f3653)

![[Fotó] Óriási csővezeték vezeti a vizet a West-tóhoz, hozzájárulva a To Lich folyó újjáéledéséhez](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/10/887e1aab2cc643a0b2ef2ffac7cb00b4)

Hozzászólás (0)