خدعة احتيالية عن طريق انتحال صوت بصوت مزيف

في عصر الذكاء الاصطناعي سريع التطور، أصبح الصوت - أحد العوامل التي كانت تُعتبر دليلاً موثوقاً - أداةً خطيرةً في أيدي المجرمين. تتيح تقنية التزييف العميق للأصوات المزيفة أن تكون مطابقةً لأصوات الأشخاص الحقيقيين، مما يُنتج مكالماتٍ وهميةً متطورةً للاحتيال والاستيلاء على الممتلكات.

لماذا الصوت المزيف مخيف؟

Deepfake voice هي تقنية تستخدم الذكاء الاصطناعي (AI) والتعلم الآلي لإنشاء صوت مزيف مطابق لصوت الشخص الحقيقي.

مع دعم النماذج الحديثة مثل Tacotron وWaveNet وElevenLabs أو منصات استنساخ الصوت مثل Respeecher، يحتاج المحتالون فقط إلى 3 - 10 ثوانٍ من عينات الصوت لإنشاء تقليد عميق موثوق به بنسبة 95٪.

تصبح الأصوات المزيفة خطيرة بشكل خاص بسبب قدرتها على تقليد الأصوات بشكل مثالي تقريبًا، بدءًا من النطق والتجويد وحتى عادات التحدث الفريدة لكل شخص.

وهذا يجعل من الصعب للغاية على الضحايا التمييز بين الصوت الحقيقي والمزيف، خاصة عندما يكون الصوت ملكًا لأقاربهم أو أصدقائهم أو رؤسائهم.

يُعدّ استخراج الأصوات أمرًا سهلًا أيضًا، إذ يعرض معظم الناس اليوم أصواتهم عبر منصات مثل تيك توك، أو البث المباشر على مواقع التواصل الاجتماعي، أو البودكاست، أو الاجتماعات عبر الإنترنت. والأمر الأكثر إثارة للقلق هو أن الأصوات المزيفة لا تترك أثرًا بصريًا كالصور أو مقاطع الفيديو ، مما يُصعّب التحقيقات ويُعرّض الضحايا لخسارة مالية.

بضع ثوانٍ فقط من عينة الصوت كافية لإنشاء تزييف عميق

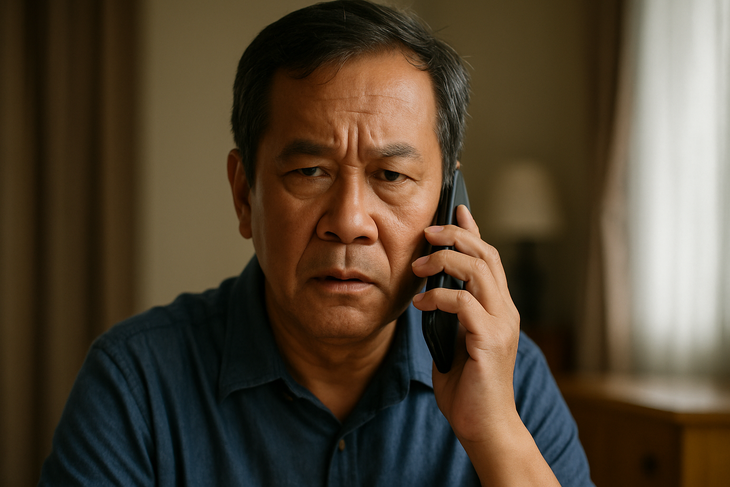

أصبحت عمليات الاحتيال باستخدام الصوت المزيف أكثر تعقيدًا، وغالبًا ما تستخدم سيناريو مألوفًا: انتحال شخصية أحد المعارف في حالة طوارئ لخلق حالة من الذعر والضغط على الضحية لتحويل الأموال على الفور.

في فيتنام، تلقت أم اتصالاً من "ابنها" يُبلغها بتعرضه لحادث وبحاجته الماسة للمال. وفي المملكة المتحدة، تعرض مدير شركة للاحتيال بأكثر من 240 ألف دولار بعد سماعه طلبًا من "مديره" بتحويل أموال عبر الهاتف. كما تعرض موظف إداري للاحتيال أيضًا عندما تلقى اتصالًا من "مدير كبير" يطلب فيه دفع مبلغ لـ"شريك استراتيجي".

النقطة المشتركة في هذه المواقف هي أن الصوت المزيف يتم إعادة إنتاجه تمامًا مثل صوت أحد الأقارب أو الرئيس، مما يجعل الضحية يثق به تمامًا ولا يكون لديه وقت للتحقق منه.

تأكد دائمًا، ولا تثق فورًا

مع تزايد عمليات الاحتيال باستخدام الأصوات المزيفة، يُنصح بعدم تحويل الأموال عبر الهاتف بالاعتماد على الصوت فقط، حتى لو كان الصوت مطابقًا تمامًا لصوت أحد المقربين. بدلًا من ذلك، يُنصح بالاتصال بالرقم القديم أو التحقق من المعلومات عبر قنوات متعددة قبل إجراء أي معاملة.

ويوصي العديد من الخبراء أيضًا بإعداد "كلمة مرور داخلية" داخل المنزل أو العمل للتحقق منها في المواقف غير المعتادة.

بالإضافة إلى ذلك، من الضروري الحد من نشر مقاطع الفيديو ذات الأصوات الواضحة على منصات التواصل الاجتماعي، وخاصةً الطويلة منها. ومن الضروري أيضًا التحذير والتوجيه الاستباقي للفئات الضعيفة، مثل كبار السن أو من لا يستخدمون التكنولوجيا إلا نادرًا، لأنهم أهداف رئيسية لعمليات الاحتيال عالية التقنية.

يمكن تزوير أصوات الأقارب والأصدقاء والزملاء.

وفي العديد من البلدان، بدأت السلطات في تشديد الرقابة على تقنية التزييف العميق من خلال إطارها القانوني الخاص.

في الولايات المتحدة، حظرت عدة ولايات استخدام التزييف العميق في الحملات الانتخابية أو لنشر معلومات مضللة. وأقرّ الاتحاد الأوروبي قانون الذكاء الاصطناعي، الذي يُلزم المؤسسات بالشفافية والتحذير بوضوح في حال إنتاج أي محتوى باستخدام الذكاء الاصطناعي.

وفي الوقت نفسه، في فيتنام، على الرغم من عدم وجود قواعد محددة للأصوات المزيفة، فإن الأفعال ذات الصلة يمكن التعامل معها وفقًا للقانون الحالي، مع جرائم مثل الاحتيال، أو انتهاك الخصوصية، أو الاحتيال على الهوية.

لكن الواقع هو أن التكنولوجيا تتطور بمعدل يتجاوز بكثير قدرة القانون على مراقبتها، مما يترك العديد من الثغرات التي يمكن للجهات السيئة استغلالها.

عندما لم يعد الصوت دليلا

كان الصوت في الماضي أمرًا حميميًا وجديرًا بالثقة، لكن مع الصوت المُزيّف، لم يعد دليلًا موثوقًا. في عصر الذكاء الاصطناعي، يحتاج كل فرد إلى معرفة بالدفاع الرقمي، والتحقق الاستباقي، واليقظة الدائمة، لأن المكالمة قد تكون فخًا.

المصدر: https://tuoitre.vn/lua-dao-bang-deepfake-voice-ngay-cang-tinh-vi-phai-lam-sao-20250709105303634.htm

تعليق (0)